Googles AMIE soll als Chatbot Differenzialdiagnosen erstellen und setzt auf Self-Play für bessere Diagnosegespräche.

Google Research und Google DeepMind haben einen medizinischen Chatbot namens Articulate Medical Intelligence Explorer (AMIE) entwickelt. Im Gegensatz zu anderen KI-Systemen im Gesundheitswesen wie Med-PaLM 2, die sich in der Regel auf die Erstellung medizinischer Zusammenfassungen oder die Beantwortung medizinischer Fragen konzentrieren, soll AMIE als diagnostisches Werkzeug dienen und Differenzialdiagnosen erstellen.

AMIE basiert auf Googles PaLM und wurde mit Datensätzen trainiert, die medizinische Schlussfolgerungen, medizinische Zusammenfassungen und reale klinische Gespräche enthalten. AMIE verwendet aber auch eine simulierte Lernumgebung mit automatischen Feedbackmechanismen.

Video: Google

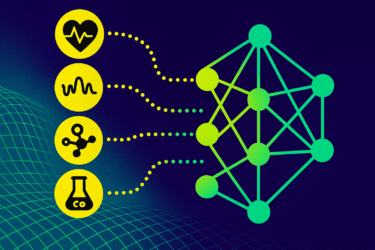

Die Self-Play-basierte diagnostische Dialogumgebung besteht aus zwei Schleifen: Eine "innere" Schleife, in der AMIE simulierte Gespräche mit einem KI-Patientensimulator führt und diese von einem Kritiker bewertet werden, sowie einer "äußeren" Schleife, in der die so simulierten und positiv bewerteten Dialoge als Material für die Feinabstimmung der nachfolgenden Iterationen von AMIE dienen. Durch diesen iterativen Prozess in Verbindung mit Chain-of-Thought konnte die Dialogqualität von AMIE deutlich verbessert werden. Die Ergebnisse sollen besser als die von GPT-4 sein.

AMIE hängt in Text-Beratung menschliche Ärzte ab

Das Team testete AMIE in einer randomisierten, doppelblinden Crossover-Studie, in der menschliche Akteure simulierte Patientengespräche nach dem Zufallsprinzip entweder mit echten Ärzten oder mit AMIE über eine Textschnittstelle führten. Das Team stellte fest, dass das KI-System in den simulierten diagnostischen Konsultationen mindestens so effektiv war wie die menschlichen Ärzte. Es habe eine höhere diagnostische Genauigkeit und Leistung bei vielen klinisch wichtigen Aspekten der Beratungsqualität, so Google. Die Ergebnisse seien sowohl von Fachärzten als auch von Patientenakteuren bewertet worden.

Allerdings würden echte Gespräche häufig von Angesicht zu Angesicht geführt, sodass die Studie möglicherweise den tatsächlichen Wert des menschlichen Gesprächs unterschätzt. In der Studie wurden zudem seltenere Erkrankungen simuliert.

Um AMIE von einem Forschungsprototyp in ein robustes klinisches Instrument umzuwandeln, seien umfangreiche weitere Forschungsarbeiten erforderlich, sagt das Team, darunter solche zu Fairness, Datenschutz, Robustheit und der Leistung des Systems unter realen Bedingungen.