Googles neue KI übersetzt 100 Sprachen, stellt selbst OpenAIs GPT-3 in den Schatten - und liefert eine Blaupause zu noch größeren Netzwerken.

Ende 2019 stellten Google-Forscher eine Übersetzungs-KI vor, die statt der sonst üblichen zwei gleich 100 Sprachen ins Englische übersetzen konnte – zumindest in Ansätzen. Das langfristige Ziel: eine universale Übersetzungs-KI.

In einem ersten Testlauf trainierten die Forscher damals ein riesiges neuronales Netzwerk mit 25 Milliarden Satzpaaren aus über 100 Sprachen. Das knapp 50 Milliarden Parameter große Netzwerk war die bis dato größte Text-KI und sollte ihre Fähigkeit generalisieren, Sprachen zu übersetzen.

Die Idee: Viele Sprachen teilen sich Übersetzungsregeln und eine Künstliche Intelligenz, die nicht mit zwei, sondern 100 Sprachen trainiert wird, hat gute Chancen, diese zu lernen. Tatsächlich stieg die Übersetzungsleistung mit dem größten Netzwerk sowohl für häufige als auch seltene Sprachen signifikant.

Google baut die bisher größte Text-KI

Googles „M4“-Ansatz (Massively Multilingual, Massive Neural Machine Translation) scheint also zu funktionieren. Doch kann die Übersetzungsleistung mit einem noch größeren Netzwerk gesteigert werden? Und wie kann ein so großes Netzwerk überhaupt konstruiert werden? Diesen Fragen ist Google nachgegangen.

Das Ergebnis: Googles neue Übersetzungs-KI stellt in puncto Größe selbst den OpenAI-Riesen GPT-3 in den Schatten. Ganze 600 Milliarden Parameter wiegt Googles Übersetzungs-KI. GPT-3 kommt auf lediglich 175 Milliarden Parameter. An einer Billionen-Variante forscht Google ebenfalls.

Mehr Parameter, mehr Leistung

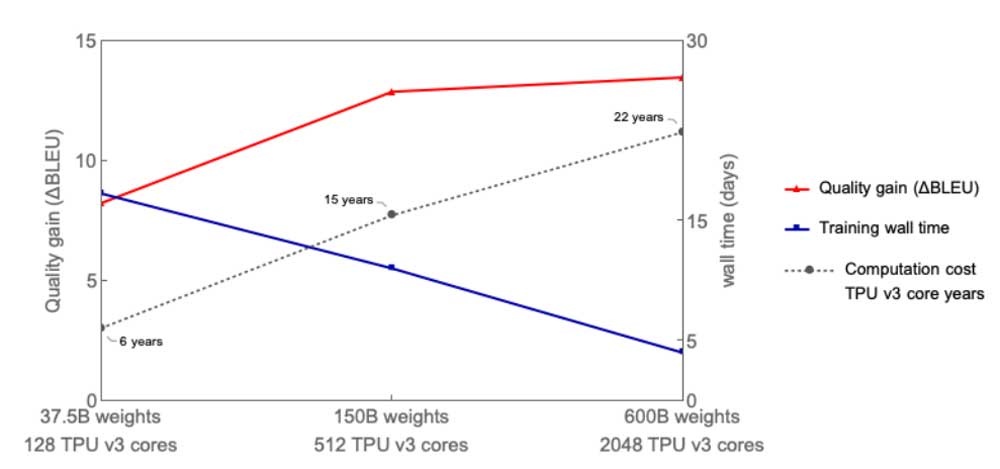

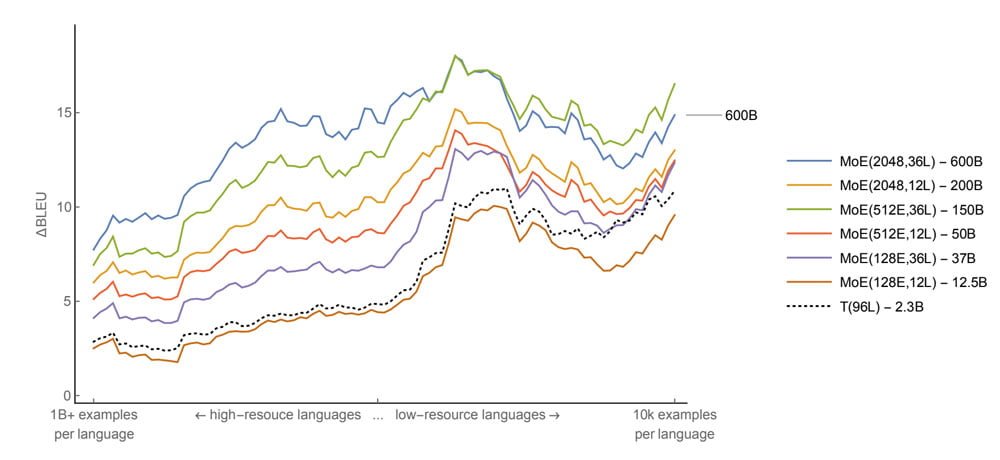

Es zeigt sich, dass Googles „M4“-Ansatz noch Luft nach oben hat: Die Übersetzungsleistung nimmt fast linear mit dem Anstieg der Netzwerkgröße zu.

Das größte Modell mit 600 Milliarden Parametern bringt die deutlichsten Verbesserungen. Allerdings liegt bei Sprachen, für die es wenige Übersetzungsbeispiele als Trainingsdaten gibt, ein etwas kleineres Modell vorne.

Die Google-Forscher vermuten, dass die goldene Mitte zwischen diesen beiden Modellen liegt oder das größere Modell mit einer leicht veränderten Architektur bessere Ergebnisse erzielen kann.

GShard macht riesiges Netzwerk möglich

Google konnte in den letzten Jahren mit stetig mehr Daten für das KI-Training und größeren Netzwerken konstant beachtliche Fortschritte bei der Übersetzungsleistung erzielen. Der BLEU-Score (linke Leiste) ist ein Indikator für die Qualität einer maschinellen Übersetzung.

Der „M4“-Ansatz bringt weitere Verbesserungen, benötigt jedoch viel Rechenleistung. Für bisherige Übersetzungs-KIs nutzte Google „GPipe“, ein Framework, das die benötigte Rechenleistung auf mehrere KI-Chips aufteilt. Damit können Entwickler den Code für eine KI schreiben, als gäbe es einen einzigen, riesigen Computer. Das Framework übernimmt die Aufteilung auf die vorhandene Hardware.

Für die jetzt neu vorgestellte Übersetzungs-KI haben die Forscher das neue Framework „GShard“ entwickelt, das die Aufgaben noch effizienter auf die vorhandene Hardware verteilt.

Mit GShard konnten die Forscher ein 600 Milliarden Parameter großes Modell auf 2.048 TPU v3 trainieren - und das in nur vier Tagen.

Mit dem vorher eingesetzten GPipe-Framework dauerte das Training eines vergleichbar leistungsfähigen Übersetzers mit lediglich 2,3 Milliarden Parametern sechs Wochen auf der gleichen Hardware.

Google verbessert auch die KI-Architektur

GShard schafft außerdem neue Möglichkeiten für Googles Transformer-Architektur, die modernen KI-Übersetzern meist zugrunde liegt. Üblicherweise skalieren Entwickler die Architektur, indem sie mehrere Transformer-Schichten stapeln.

Google nutzt jedoch einen anderen Ansatz: Die Forscher bauen in die Breite.

Innerhalb eines Transformer-Moduls gibt es ein einzelnes neuronales Netz, das Informationen in der Architektur weiterleitet. Bei einer Übersetzungsaufgabe wandern so etwa deutsche, englische und arabische Wörter durch das gleiche Netzwerk.

Google vervielfältigt dieses Netzwerk massiv und teilt die so entstandenen Kopien mit GShard auf unterschiedliche KI-Chips auf. So entstehen viele sogenannte Experten-Netzwerke, die sich auf die Weiterleitung bestimmter Sprachen oder Zeichen spezialisieren.

Während ein einzelnes Transformer-Modul also üblicherweise ein einzelnes weiterleitendes neuronales Netzwerk hat, das alle Jobs erledigt, hat Google mehrere Spezialisten, die auf mehreren KI-Chips laufen. Das größte Netzwerk hat ganze 2.048 Experten-Netzwerke für jedes einzelne Transformer-Modul.

Google tauft diese Architektur daher „Mixture-of-Experts“-Transformer (kurz: MoE Transformer). Durch diese Verbreiterung kommt das größte Modell trotz lediglich 36 Schichten auf 600 Milliarden Parameter. OpenAIs GPT-3 hat dagegen ganze 96 Schichten – kommt aber nur auf 175 Milliarden Parameter.

Das Experiment zeige, dass sich die Skalierung neuronaler Netze weiter lohne, schreiben die Forscher. Dafür habe man mit dem neuen GShard-Framework ein leicht zu bedienendes Werkzeug für Entwickler geschaffen. Im nächsten Schritt wollen die Forscher bei den Parametern die Eine-Billionen-Grenze knacken.

Via: Arxiv; Titelbild: Google Cloud TPU v3