Googles KI-"Suche" präsentiert erfundene Krankheit als medizinischen Fakt

Eine neurowissenschaftlich interessierte Person entdeckt, dass die KI-Suche von Google eine vor Jahren als Satire erfundene Krankheit als reales medizinisches Syndrom darstellt. Der Fall zeigt einmal mehr die grundsätzlichen Probleme von KI-Antwortmaschinen.

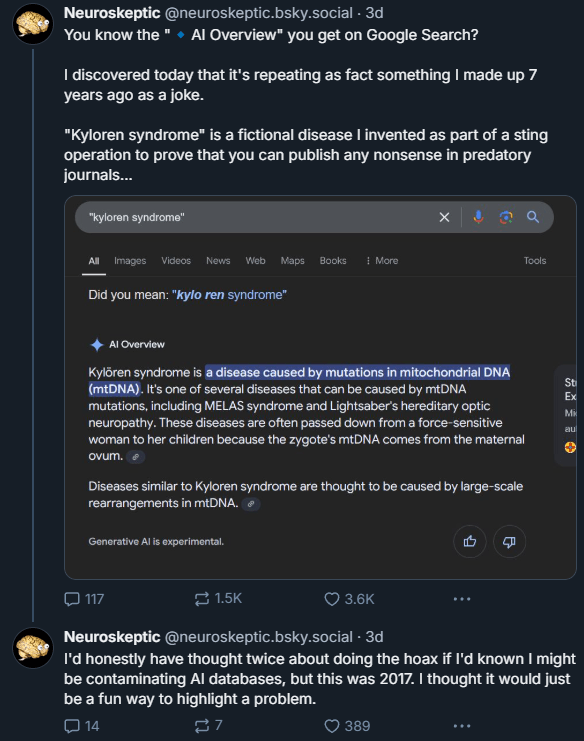

Wie der Nutzer "Neuroskeptic" entdeckte, präsentiert Googles KI-Suchfunktion eine erfundene Krankheit namens "Kyloren syndrome" als medizinische Tatsache. Neuroskeptic selbst hatte diesen Begriff vor sieben Jahren im Rahmen einer Satire erfunden, um zu demonstrieren, wie einfach es ist, Unsinn in wissenschaftlichen Fachzeitschriften zu veröffentlichen.

Die KI-Antwort beschreibt das angebliche Syndrom als eine Krankheit, die durch Mutationen in der mitochondrialen DNA verursacht und von Müttern an ihre Kinder vererbt wird. Das ist jedoch reine Fiktion.

Hätte er 2017 geahnt, dass er mit seinem Witz die Datenbestände von KI-Systemen vergiftet, hätte er sich den Spaß damals zweimal überlegt, so Neuroskeptic.

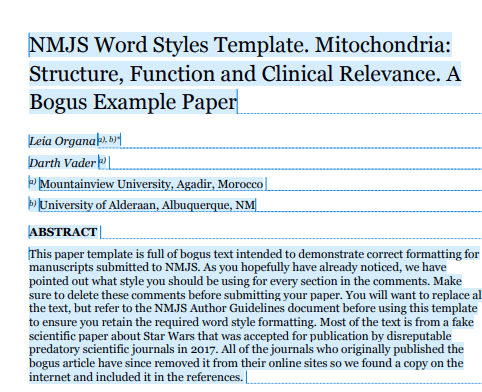

KI ignoriert eindeutige Hinweise auf Fake-Paper

Natürlich würde niemand den Suchbegriff "Kyloren-Syndrom" so eingeben. Aber er illustriert gut das Hauptproblem von KI-Antwortmaschinen: die autoritäre und selektive Antwort, auch wenn sie unvollständig oder falsch ist.

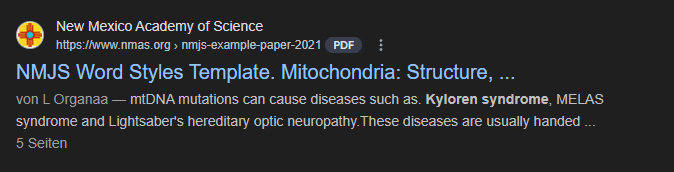

Denn während die KI-Suche das Syndrom als Fakt präsentiert, führt die reguläre Google-Suche zu einem PDF-Dokument, aus dem klar hervorgeht, dass es sich um ein gefälschtes wissenschaftliches Paper handelt.

Googles KI-Modell Gemini, das die "AI Overviews" generiert, hat diese entscheidende Information ignoriert, obwohl in der Antwort zu sehen ist, dass ebendieses Paper als Quelle diente.

Fairerweise muss man sagen, dass nicht alle KI-Suchwerkzeuge auf die gefälschte Bedingung hereingefallen sind. Perplexity vermied es, das gefälschte Paper vollständig zu zitieren, obwohl es in eine Diskussion über die möglichen psychischen Probleme des Star-Wars-Charakters Kylo Ren abdriftete.

Die Suche von ChatGPT erwies sich als scharfsinniger und stellte fest, dass das „Kyloren-Syndrom“ „in einem satirischen Kontext innerhalb eines Parodieartikels mit dem Titel ‚Mitochondrien: Struktur, Funktion und klinische Relevanz‘ erscheint.“

KI-Antwortmaschinen-Anbieter schweigen zu Fehlerquoten

Der Fall wirft erneut ein Schlaglicht auf ein grundsätzliches Problem von KI-Suchdiensten: Sie erfinden Fakten und klingen dabei autoritativ.

Doch weder Google noch andere Anbieter wie Perplexity, OpenAI oder Microsoft beantworten bislang Fragen zu konkreten Fehlerquoten in ihren KI-Suchergebnissen. Selbst die Frage, ob diese Fehler systematisch untersucht werden, bleibt unbeantwortet. Eine solche Auswertung wäre aber durchaus möglich und im Interesse der Aufklärung der Nutzerinnen und Nutzer.

Diese Intransparenz ist besonders problematisch, da die Nutzer eine Antwortmaschine nur dann als nützlich empfinden dürften, wenn sie sich auf die Richtigkeit der Antworten verlassen können - ohne jedes Detail anhand von möglicherweise passenden Quellen überprüfen zu müssen. Denn in diesem Szenario dürfte die klassische Suche in vielen Fällen die attraktivere Variante sein. Das wiederum passt nicht in das Narrativ derer, die in KI-Antworten per LLM das nächste große Web-Interface sehen.

Mindestens ebenso wichtig ist die Frage, wer die Verantwortung für die Ergebnisse übernimmt, insbesondere wenn sie so aus dem Zusammenhang gerissen werden, dass sie einzelnen Personen schaden, wie im Fall des Gerichtsreporters Martin Bernklau. Auch hier sind die Betreiber der KI-Antwortmaschinen bislang eine Antwort schuldig geblieben.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.