GTC '25: Nvidia zeigt Blackwell Ultra, DGX Spark, RTX Pro, Dynamo und Reasoning-Modelle

Nvidia hat auf seiner GTC-Konferenz 2025 eine umfassende Reihe neuer Produkte und Technologien vorgestellt, die das Unternehmen als Wegbereiter für eine neue Ära des KI-Reasonings positionieren sollen. Im Mittelpunkt standen die Blackwell Ultra-Plattform.

Die neue Nvidia Blackwell Ultra-Plattform stellt eine Weiterentwicklung der erst im Vorjahr eingeführten Blackwell-Architektur dar. Sie umfasst den Nvidia GB300 NVL72 Rack-Scale-Lösung und das Nvidia HGX B300 NVL16 System. Das Unternehmen geht damit zum ersten Mal zu seinem geplanten jährlichen Zyklus für KI-Beschleuniger über. Laut Nvidia liefert der GB300 NVL72 bei FP4-Genauigkeit 1,5-mal mehr KI-Leistung als der GB200 NVL72.

Die neuen Blackwell Ultra-Produkte sollen ab der zweiten Jahreshälfte 2025 von Partnern wie Cisco, Dell Technologies, Hewlett Packard Enterprise, Lenovo und Supermicro angeboten werden. Cloud-Service-Provider wie AWS, Google Cloud, Microsoft Azure und Oracle Cloud Infrastructure sowie GPU-Cloud-Anbieter wie CoreWeave werden laut Nvidia zu den ersten gehören, die Blackwell Ultra-basierte Instanzen anbieten.

Nvidia kündigte auch den DGX SuperPOD mit Blackwell Ultra GPUs an. Das DGX GB300-System verfügt über Nvidia Grace Blackwell Ultra Superchips – mit 36 Nvidia Grace CPUs und 72 Nvidia Blackwell Ultra GPUs – und eine flüssigkeitsgekühlte Rack-Scale-Architektur. Jedes DGX GB300-System verfügt zudem über 72 Nvidia ConnectX-8 SuperNICs, die Netzwerkgeschwindigkeiten von bis zu 800 Gb/s liefern.

Als Alternative bietet Nvidia das luftgekühlte DGX B300-System an, das auf der Nvidia B300 NVL16-Architektur basiert und für bestehende Rechenzentren konzipiert ist, die noch nicht auf Flüssigkühlung setzen.

Nvidia Dynamo: Optimierte Inferenzsoftware für KI-Reasoning

Neben der neuen Hardware stellte Nvidia auch Dynamo vor, eine neue Open-Source-Inferenz-Software, die KI-Reasoning-Modelle beschleunigen und skalieren soll.

Dynamo ist der Nachfolger des Triton Inference Server und wurde speziell für die Maximierung der Token-Einnahmen bei KI-Diensten entwickelt. In der Praxis bedeutet dies, dass mehr Anfragen verarbeitet werden können, während die Kosten pro Anfrage sinken - ein entscheidender Faktor für die Wirtschaftlichkeit von KI-Diensten.

Die Software orchestriert und beschleunigt die Inferenzkommunikation über tausende GPUs hinweg und nutzt dabei ein Verfahren namens "Disaggregated Serving". Dieses trennt die Verarbeitungs- und Generierungsphasen großer Sprachmodelle (LLMs) auf verschiedene GPUs auf, wodurch jede Phase unabhängig für ihre spezifischen Anforderungen optimiert werden kann.

Nach Angaben von Nvidia verdoppelt Dynamo bei gleichbleibender GPU-Anzahl die Leistung (und potenziellen Einnahmen) von "KI-Fabriken", die Llama-Modelle auf der aktuellen Hopper-Plattform betreiben. Beim Betrieb des DeepSeek-R1-Modells auf einem großen Cluster von GB200 NVL72-Racks soll die Software die Anzahl der generierten Tokens pro GPU um mehr als das 30-fache steigern.

Um diese Leistungsverbesserungen zu erreichen, integriert Dynamo mehrere Funktionen, die den Durchsatz erhöhen und die Kosten senken sollen. Die Software kann dynamisch GPUs hinzufügen, entfernen und neu zuweisen, um auf schwankende Anfragevolumen und -typen zu reagieren. Zudem kann sie bestimmte GPUs in großen Clustern identifizieren, die Antwortberechnungen minimieren können, und entsprechend Anfragen dorthin leiten.

Mehrere Unternehmen planen bereits den Einsatz von Dynamo, darunter etwa Perplexity AI.

Llama Nemotron: KI-Modelle für Reasoning und Agentic AI

Das Unternehmen kündigte zudem eine neue Llama Nemotron-Modellfamilie mit Reasoning-Fähigkeiten an, die Entwicklern und Unternehmen eine Grundlage für fortschrittliche KI-Agenten bieten soll. Die Genauigkeit in verschiedenen Benchmarks soll dabei um bis zu 20 Prozent höher liegen als die zugrundeliegenden Llama-Modelle.

Die Modelle sind als Nvidia NIM Microservices in den Größen Nano, Super und Ultra verfügbar. Wirklich aussagekräftige Vergleiche mit anderen Reasoning-Modellen gibt es noch nicht. Durch die Optimierung für Nvidia-Chips und FP4-Genauigkeit sollen die Modelle allerdings bis zu fünfmal schneller laufen als vergleichbare Open-Reasoning-Modelle - damit dürften sie auch deutlich günstiger im Betrieb sein.

Laut einer Pressemitteilung arbeiten Unternehmen wie Accenture, Amdocs, Atlassian, Box, Cadence, CrowdStrike, Deloitte, IQVIA, Microsoft, SAP und ServiceNow bereits mit Nvidia an den neuen Reasoning-Modellen und der dazugehörigen Software. Nvidia stellt mit AI-Q außerdem ein auf LangGraph basierendes Blueprint für agentische Systeme vor.

Silizium-Photonik für revolutionäre Netzwerktechnik

Mit Nvidia Spectrum-X Photonics und Nvidia Quantum-X Photonics stellte das Unternehmen auch eine neue Netzwerktechnologie vor, die optische Kommunikation direkt in Switches integriert. Diese Switches sollen den Energieverbrauch und die Betriebskosten der Kommunikation in Rechenzentren drastisch reduzieren.

Die neuen Switches bieten 1,6 Terabit pro Sekunde pro Port und liefern 3,5-mal mehr Energieeffizienz, 63-mal größere Signalintegrität und 10-mal bessere Netzwerkresilienz im Vergleich zu herkömmlichen Methoden. Nvidia Quantum-X Photonics InfiniBand-Switches sollen noch in diesem Jahr verfügbar sein, während Nvidia Spectrum-X Photonics Ethernet-Switches 2026 auf den Markt kommen sollen.

"Durch die Integration von Silizium-Photonik direkt in Switches durchbricht Nvidia die alten Grenzen von Hyperscale- und Unternehmens-Netzwerken", so Nvidias CEO Jensen Huang. Das öffne das Tor zu "KI-Fabriken mit Millionen von GPUs".

Persönliche KI-Supercomputer mit DGX Spark und DGX Station

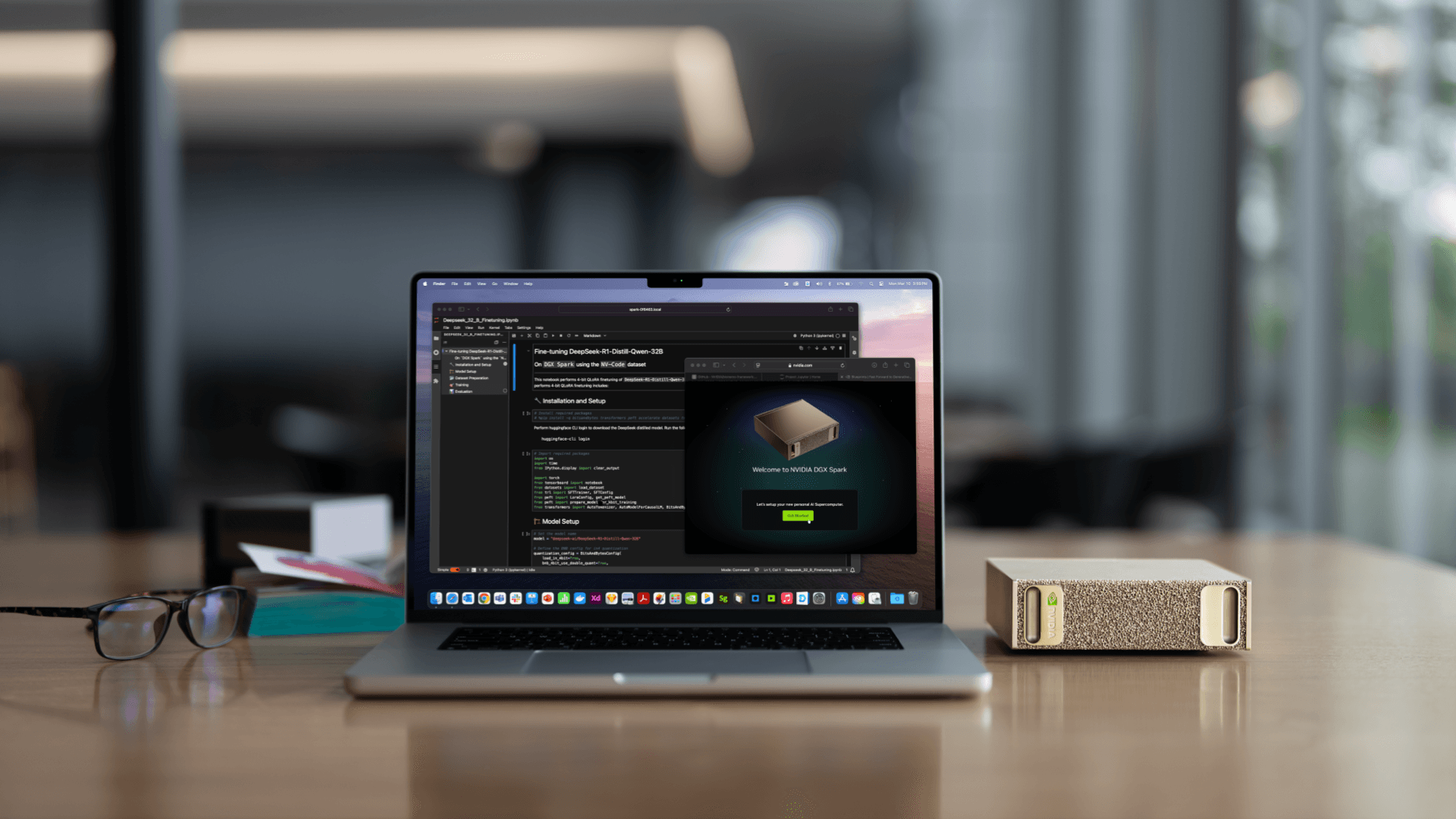

Für Entwickler, Forscher und Data Scientists stellte Nvidia die persönlichen KI-Computer DGX Spark und DGX Station vor.

DGX Spark (ehemals Digits) ist laut Nvidia der "kleinste KI-Supercomputer der Welt" und wird vom Nvidia GB10 Grace Blackwell Superchip angetrieben. DGX Station hingegen ist das erste Desktop-System mit dem Nvidia GB300 Grace Blackwell Ultra Desktop Superchip und verfügt über 784 GB kohärenten Speicherplatz für große Trainings- und Inferenzworkloads. Laut Huang ist das eine "neue Klasse von Computern", konzipiert für KI-native Entwickler und zum Ausführen KI-nativer Anwendungen.

Für Designer, Entwickler, Data Scientists und Kreative stellte Nvidia außerdem wie erwartet die Nvidia RTX PRO Blackwell-Serie vor. Die neuen GPUs bieten verbesserte Leistung mit dem Nvidia Streaming Multiprocessor, der vierten Generation der RT Cores und der fünften Generation der Tensor Cores. Sie unterstützen auch größeren und schnelleren GDDR7-Speicher, der bis zu 96 GB für Workstations und Server und bis zu 24 GB für Laptops bietet.

Isaac GR00T N1: Foundation Model für humanoide Roboter

Im Bereich der Robotik präsentierte Nvidia Isaac GR00T N1, das laut Unternehmen erste offene, vollständig anpassbare Foundation Model für generalisierte humanoide Reasoning- und Skill-Fähigkeiten. Das Modell war bereits früher vorgestellt worden, soll jetzt aber verfügbar sein. In einer Demo zeigte das Unternehmen wie Robotik-Hersteller mit dem Modell ihre humanoiden Roboter steuern.

Nvidia kündigte zudem eine Zusammenarbeit mit Google Deepmind und Disney Research an, um Newton zu entwickeln, eine Open-Source-Physik-Engine, die es Robotern ermöglicht, komplexe Aufgaben mit größerer Präzision zu bewältigen. Google Deepmind will Newton etwa eine Variante die Trainings-Platform MuJoCo integrieren.

Cosmos: World Foundation Models für Physical AI

Für Nvidia Cosmos stellte das Unternehmen neue World Foundation Models (WFMs) vor: Cosmos Transfer wandelt strukturierte Daten wie Segmentierungskarten und Lidar-Scans in fotorealistische Videos um – ideal für synthetische Trainingsdaten bei Robotik-Anwendungen. Cosmos Predict generiert virtuelle Weltzustände aus multimodalen Eingaben und kann mit den neuen Modellen auch Zwischenaktionen oder Bewegungstrajektorien vorhersagen. Auf Grace Blackwell Systemen ermöglicht dies laut Nvidia Echtzeit-Weltgenerierung.

Cosmos Reason ergänzt das Portfolio als offenes Reasoning-Modell mit raumzeitlichem Bewusstsein, das Videodaten interpretiert und Interaktionsergebnisse vorhersagt. Unternehmen wie Agility Robotics, 1X und Skild AI setzen die Technologien laut Nvidia bereits ein, um ihre autonomen Systeme zu verbessern.

Auf Blackwell folgt Vera Rubin und mehr

Nvidia-Chef Jensen Huang stellte außerdem die Vera Rubin GPU vor, die ab Mitte 2026 erhältlich sein soll. Sie besteht aus zwei Grafikprozessoren und der neuen Nvidia-CPU Vera". Laut Nvidia erreicht Vera Rubin bis zu 50 Petaflops bei KI-Berechnungen - doppelt so viel wie die aktuellen Blackwell-Chips. Auch die CPU ist doppelt so schnell wie ihr Vorgänger. Für Ende 2027 plant Nvidia die Vera Rubin Ultra mit mehreren GPUs sowie die Rubin Next, die vier GPU-Kerne kombiniert. Für 2028 kündigte Huang die Feynman-GPU an, die ebenfalls die Vera-CPU nutzt. Weitere Details nannte er nicht.

Nvidia kündigte außerdem ein Quantum Computing Research Center in Boston an, das führende Quantenhardware mit KI-Supercomputern integrieren soll. Das Zentrum wird mit Quantinuum, Quantum Machines und QuEra Computing zusammenarbeiten und soll noch in diesem Jahr den Betrieb aufnehmen.

Mit der Nvidia AI Data Platform stellte das Unternehmen zudem eine anpassbare Referenzarchitektur vor und im Bereich der Klimatechnologie präsentierte Nvidia den Nvidia Omniverse Blueprint für Earth-2-Wetteranalysen, um die Entwicklung genauerer Wettervorhersagelösungen zu beschleunigen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.