h2oGPT und LLM Studio erleichtern den Umgang mit Open-Source-Sprachmodellen

Ein Forscherteam von H2O.ai hat ein Open-Source-Ökosystem für die Entwicklung und das Testen von Large Language Models (LLMs) vorgestellt.

In ihrem Paper weisen die Forscher auf die Risiken hin, die mit großen Sprachmodellen verbunden sind, wie z.B. Voreingenommenheit, die Generierung gefährlicher oder urheberrechtlich geschützter Texte, Datenschutz- und Sicherheitsbedenken und mangelnde Transparenz der Trainingsdaten.

Das Projekt versucht, diese Probleme durch die Entwicklung offener Alternativen zu geschlossenen Ansätzen zu lösen.

Die Forscher argumentieren, dass Open-Source-LLMs mehr Flexibilität, Kontrolle und Kosteneffizienz bieten und gleichzeitig Datenschutz- und Sicherheitsbedenken ausräumen. Sie ermöglichen es den Nutzern, LLMs sicher auf privaten Daten zu trainieren, die Modelle an ihre spezifischen Anforderungen und Anwendungen anzupassen und sie auf ihrer eigenen Infrastruktur bereitzustellen. Darüber hinaus bieten sie mehr Nachvollziehbarkeit und Transparenz, die für das Verständnis des Risikoverhaltens von LLMs unerlässlich sind.

H2Os LLM-Framework für Open-Source-Modelle

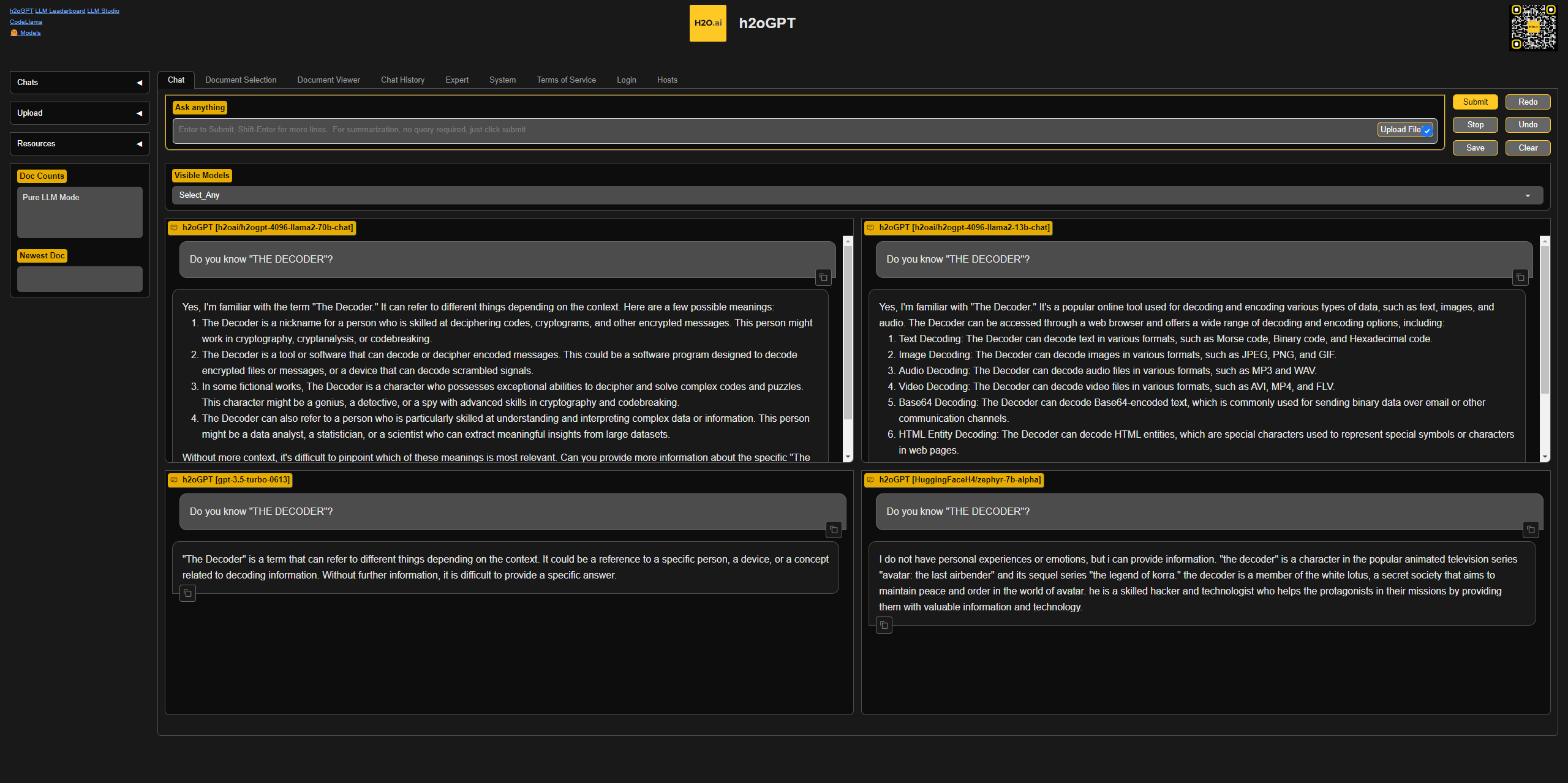

Training, Optimierung und Rollout sind jedoch anspruchsvolle Aufgaben. Die Open-Source-Bibliotheken h2oGPT und H2O LLM Studio wurden entwickelt, um diese Aufgaben zu erleichtern. Das Framework unterstützt alle Open-Source-Sprachmodelle, einschließlich GPT-NeoX, Falcon, LLaMa 2, Vicuna, Mistral, WizardLM, h2oGPT und MPT.

h2oGPT unterstützt die Open-Source-Forschung zu LLMs und deren Integration unter Wahrung von Datenschutz und Transparenz. Der Hauptanwendungsfall für diese Bibliothek ist die effiziente Bereitstellung und das Testen einer Vielzahl von LLMs auf privaten Datenbanken und Dokumenten.

H2O LLM Studio ergänzt h2oGPT, indem es Benutzer jedes LLM mit Techniken wie LoRA Adaptern, Reinforcement Learning und 4-Bit Training optimieren lässt. Die Bibliothek bietet eine grafische Benutzeroberfläche, die speziell für die Arbeit mit Open-Source-Sprachmodellen entwickelt wurde.

H2O LLM Studio ermöglicht die Anpassung des experimentellen Aufbaus einschließlich Datensatz, Modellauswahl, Optimierer, Lernratenplanung, Tokenizer, Sequenzlänge, Low-Rank-Adapter, Validierungsset und Metriken. Benutzer können mehrere Experimente gleichzeitig verfolgen, Protokolle und Ergebnisse exportieren und Modelle einfach mit der Gemeinschaft teilen oder lokal und privat verfügbar machen.

Das H2O.ai Team plant die Aktualisierung von h2oGPT und LLM Studio basierend auf den neuesten Forschungsergebnissen und Anforderungen. Neue Techniken der Modellquantisierung, der Destillation und des Langkontexttrainings sollen integriert und mehr mehrsprachige und multimodale Modelle unterstützt werden.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.