Hm, Moment mal! Forscher warnen vor vermenschlichten KI-"Gedankengängen"

Ein Forschungsteam der Arizona State University warnt davor, Zwischenschritte in Sprachmodellen als menschliche Denkprozesse zu interpretieren. Die Autoren sehen darin eine gefährliche Fehlannahme mit weitreichenden Folgen für Forschung und Anwendung.

In einem Positionspapier kritisieren Forscher der Arizona State University die weitverbreitete Praxis, Zwischen-Token in sogenannten Reasoning-Modellen als "Gedanken" oder "Argumentationsketten" zu interpretieren.

Die Vermenschlichung der Zwischen-Token sei eher eine "Cargo-Kult"-Erklärung, da sie dem Denken nur in der Form (Syntax) gleiche, nicht jedoch im Inhalt (Semantik). Die menschliche Deutung sei daher irreführend und schädlich, wenn man große Sprachmodelle besser verstehen und weiterentwickeln wolle, so die Autoren um Subbarao Kambhampati. Sie fordern die KI-Community auf, sich von der romantisierenden Vorstellung "denkender" Sprachmodelle zu lösen.

Zwischen-Token sind keine Denkprozesse

Grundlage der Kritik ist die Beobachtung, dass viele aktuelle Reasoning-Modelle wie Deepseeks R1 oder OpenAIs o-Serie beim Lösen von Aufgaben zunächst eine längere Folge von Zwischenschritten generieren, bevor sie eine finale Antwort ausgeben.

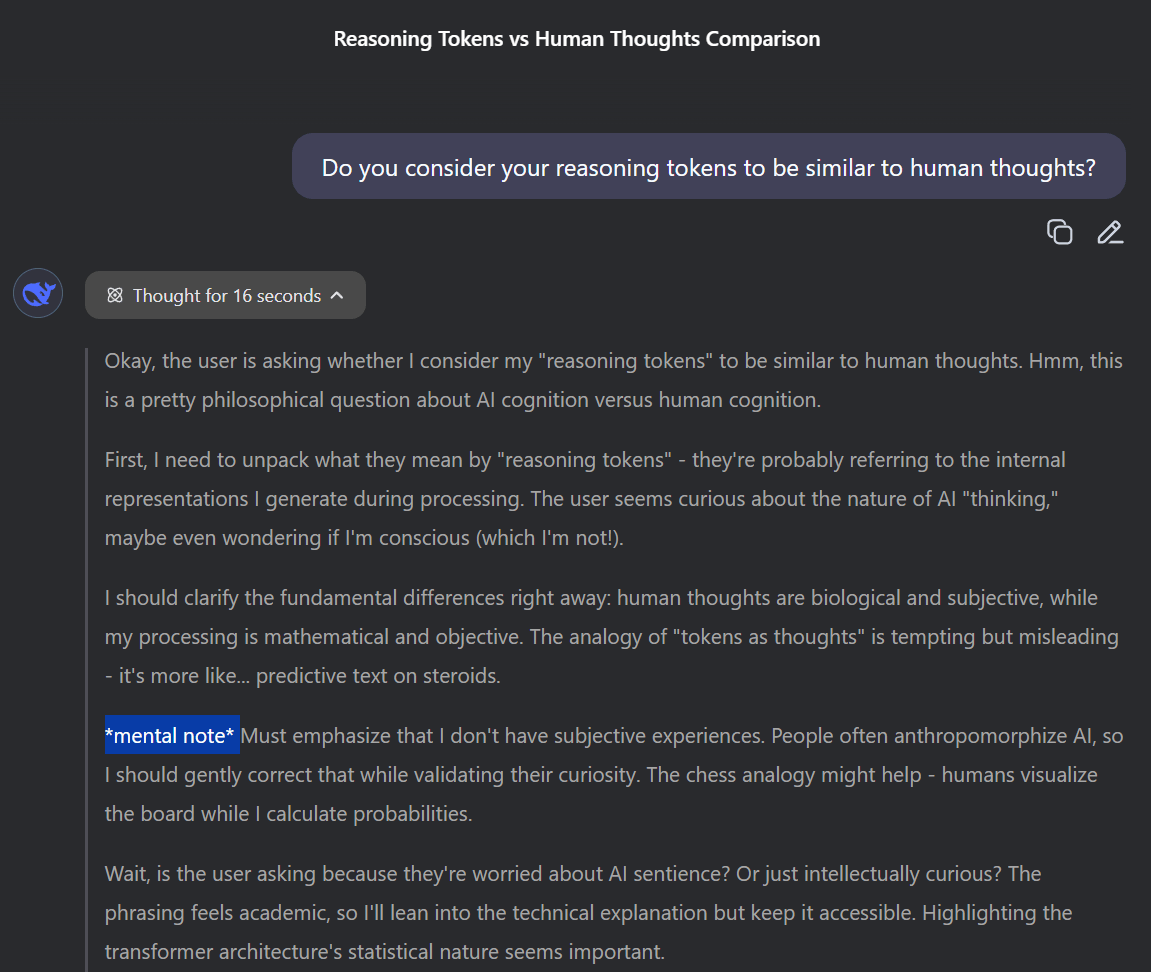

Diese sogenannten "Chains of Thought" werden häufig als Anzeichen für ein simuliertes Denken interpretiert. In vielen Chat-Anwendungen sind diese Zwischenschritte sichtbar und erinnern Nutzende an menschliche Gedankengänge.

Die Autoren widersprechen dieser Interpretation entschieden: Solche Zwischen-Token seien lediglich statistisch erzeugte Textsequenzen ohne semantische Struktur oder algorithmische Bedeutung. Die Vorstellung, sie könnten Einblick in das "Denken" des Modells geben, sei unbegründet. Vielmehr könne sie eine trügerische Sicherheit erzeugen, dass das Modell verständlich oder kontrollierbar sei.

Fehlgeleitete Forschung und falsches Vertrauen

Diese Fehlannahmen hätten laut den Forschern konkrete Folgen: Sie führten dazu, dass Wissenschaftler versuchten, diese vermeintlichen Gedankenketten interpretierbar zu machen oder ihre Länge, Lesbarkeit und sprachliche Kohärenz als Indikator für Problemlösungskomplexität zu deuten – obwohl es dafür keine belastbaren Belege gebe.

Beispielhaft nennen die Autoren Experimente, in denen Modelle mit absichtlich falschen oder bedeutungslosen Zwischenschritten trainiert wurden – mit teils besseren Ergebnissen als beim Training mit korrekt nachvollziehbaren Argumentationsketten. Auch zeige sich in Studien, dass es kaum eine Korrelation zwischen der Korrektheit der Zwischenschritte und dem Endergebnis gebe.

So habe etwa das Modell Deepseek R1-Zero, das auch englisch-chinesische Mischformen in den Zwischen-Token enthielt, laut den Autoren bessere Resultate erzielt als die später veröffentlichte Variante R1, deren Zwischenschritte gezielt auf menschliche Lesbarkeit optimiert worden waren. Reinforcement Learning könne Modelle dazu bringen, beliebige Zwischen-Token zu erzeugen – entscheidend sei allein, ob die finale Antwort korrekt sei.

Besonders kritisch sehen die Forscher die Tendenz, stilistische Ähnlichkeiten zwischen Modellantworten und menschlichem Denken als inhaltliche Tiefe zu interpretieren. Token wie "aha" oder "hmm" würden oft als Hinweis auf eine plötzliche Einsicht gewertet – obwohl sie lediglich statistisch wahrscheinliche Fortsetzungen im jeweiligen Kontext seien.

Laut Kambhampati lassen sich durchaus Fälle finden, in denen die Zwischen-Token klare Fehlannahmen enthalten, die endgültige Lösung aber dennoch korrekt ist. Der Versuch, die von Modellen wie R1 erzeugten Traces inhaltlich zu deuten, gleiche einem Rorschach-Test: Da die pseudo-englischen Textfragmente keine konsistente Bedeutung hätten, bleibe Beobachtern nur, sich auf vereinzelte Muster zu konzentrieren, die zufällig Sinn zu ergeben scheinen. Die vermeintliche Gültigkeit dieser Zwischen-Token stehe in keinem verlässlichen Zusammenhang zur Korrektheit der finalen Antwort.

Auch andere Studien zeigen, dass selbst Gedankenketten mit bedeutungslosen Zeichenfolgen oder inhaltlich falschen Zwischenschritten zu besseren Ergebnissen führen können – offenbar, weil sie statistisch als nützliche Prompt-Zusätze funktionieren.

Verifikation statt Vermenschlichung

Die Autoren argumentieren, dass die verbesserten Leistungen moderner Reasoning-Modelle nicht auf "Denken" zurückzuführen sind, sondern auf die schrittweise Integration externer Prüfsignale, beispielsweise durch automatische Verifikation oder Feedback-Systeme. Der Eindruck eines Denkprozesses sei lediglich ein Nebeneffekt dieses Optimierungsverfahrens.

Zwischen-Token sind demnach besser als Prompt-Methode zu verstehen, nicht als Abbild eines inneren mentalen Zustands. Das Ziel müsse darin bestehen, diese Prozesse gezielt zu optimieren, beispielsweise durch ein zweites Modell, das passende Zwischenschritte generiert, die nicht für Menschen nachvollziehbar oder semantisch sinnvoll sein müssen. Entscheidend sei nicht die Lesbarkeit der Zwischen-Token, sondern allein ihre Wirksamkeit bei der Verbesserung der Modellleistung.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.