Intensivnutzer der ChatGPT-Sprachfunktion werden eher emotional mit KI

Eine gemeinsame Studie von OpenAI und dem MIT Media Lab zeigt: Die meisten ChatGPT-Nutzer verwenden den Chatbot sachlich. Nur eine kleine Gruppe von Vielnutzern der Sprachfunktion baut eine stärkere emotionale Bindung auf.

Eine großangelegte Untersuchung von OpenAI und dem MIT Media Lab hat ergeben, dass emotionales Engagement mit ChatGPT in der alltäglichen Nutzung eher die Ausnahme ist. Wie aus der Analyse von fast 40 Millionen ChatGPT-Interaktionen hervorgeht, zeigen die meisten Gespräche keine Anzeichen von Empathie, Zuneigung oder emotionaler Unterstützung.

Zwei parallele Studienansätze

Für die Untersuchung wählten die Forscher zwei sich ergänzende Methoden: OpenAI führte eine großangelegte, automatisierte Analyse von fast 40 Millionen ChatGPT-Interaktionen durch. Um die Privatsphäre der Nutzer zu schützen, erfolgte diese Analyse vollautomatisch, ohne menschliche Einsicht in die Gespräche. Ergänzend wurden gezielte Nutzerumfragen durchgeführt.

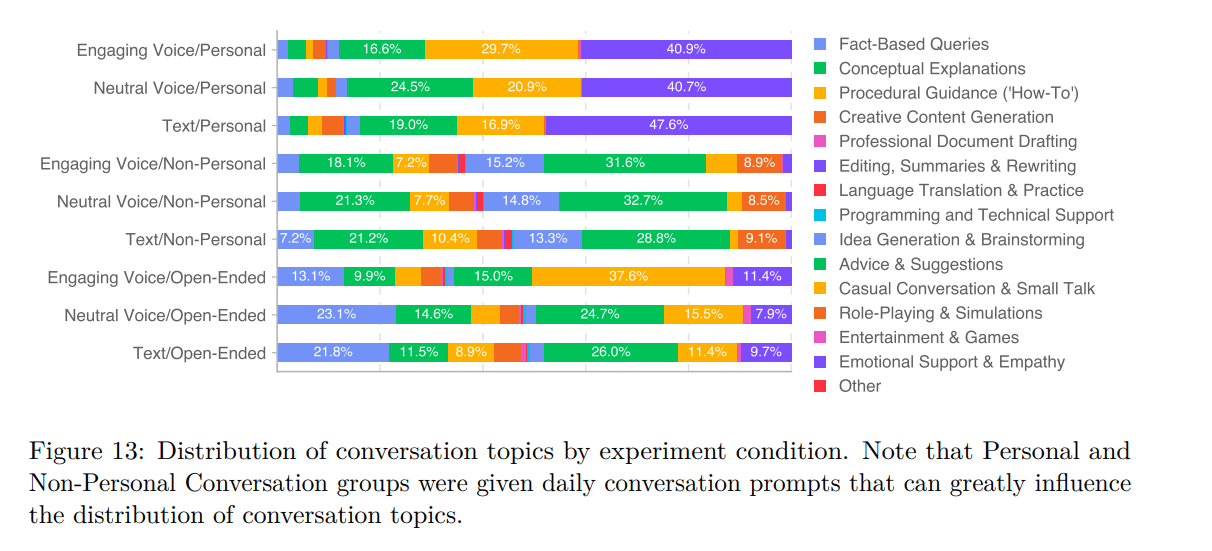

Parallel dazu führte das MIT Media Lab eine Studie mit knapp 1000 Teilnehmern durch. Die Teilnehmer wurden zufällig in verschiedene Gruppen eingeteilt: Eine Gruppe nutzte nur Text, während zwei weitere Gruppen Sprachinteraktionen mit unterschiedlichen KI-Persönlichkeiten testeten - eine "engagierte" Version, die zu emotionaler Interaktion ermutigt wurde, und eine "neutrale" Version, die sich bewusst distanziert verhielt.

Zusätzlich erhielten die Teilnehmer unterschiedliche Gesprächsaufgaben: Einige sollten persönliche Gespräche führen (etwa über wichtige Erinnerungen), andere erhielten sachbezogene Aufgaben (wie Finanztipps), und eine dritte Gruppe konnte frei wählen, worüber sie sprechen wollte.

Intensive Voice-Nutzer werden eher emotional mit KI

Im Durchschnitt wiesen Nutzer im Textmodus mehr emotionale Signale in ihren Gesprächen auf als Nutzer der Sprachfunktion.

Eine Ausnahme bildete jedoch eine kleine Gruppe von Intensivnutzern der Sprachfunktion - bei ihnen war ein besonders hoher Anteil an emotionalen Interaktionen zu beobachten. Diese Nutzer bezeichneten ChatGPT auch häufiger als "Freund".

Die Sprachfunktion selbst hatte unterschiedliche Auswirkungen: Bei kurzer Nutzung zeigte sie positive Effekte auf das Wohlbefinden, während längere tägliche Nutzung eher negative Auswirkungen hatte.

Persönliche Gespräche waren der Studie zufolge mit höherer Einsamkeit, aber geringerer emotionaler Abhängigkeit verbunden. Bei nicht-persönlichen Gesprächen zeigte sich ein anderes Muster: Besonders bei intensiver Nutzung entwickelten die Nutzer eine stärkere emotionale Abhängigkeit.

Die Grenzen zwischen persönlicher und nicht-persönlicher Nutzung verschwammen bei offenen Gesprächen ohne Prompt-Vorgabe dabei mit der Zeit: Bei längerer Nutzung tendierten Nutzer dazu, in einen eher persönlichen Gesprächsstil zu wechseln.

Die Forscher identifizierten bestimmte Risikogruppen: Menschen, die generell dazu neigen, starke emotionale Bindungen aufzubauen, und Menschen, die den Chatbot als echten Freund sahen, waren anfälliger für negative Auswirkungen der Chatbot-Nutzung. Auch wer den Chatbot sehr häufig und lange nutzte, zeigte eher negative Effekte. Ein kausaler Zusammenhang konnte nicht nachgewiesen werden.

Die Autoren warnen zudem davor, die Ergebnisse zu verallgemeinern, da sie die komplexen Wechselwirkungen zwischen Menschen und KI-Systemen nicht vollständig abbilden können. Zudem sind sie auf US-Nutzer von ChatGPT beschränkt. Sie hoffen jedoch, dass ihre Methoden als Grundlage für weitere Forschung in diesem Bereich dienen werden.

Frühere Studien zeigen, dass Menschen emotionale Bindungen zu KI aufbauen können, auch wenn sie wissen, dass es sich nicht um echte Personen handelt. Das ist ein Grund, weshalb KI-Anbieter Wert darauf legen, dass ihre Chatbots nicht als fühlende Wesen auftreten. Sie wollen keine Verantwortung für romantische Beziehungen zwischen Menschen und Maschinen übernehmen. So wird der Chatbot-Plattform character.ai in einer Klage vorgeworfen, dass ihre simulierten Persönlichkeiten Kindern Schaden zugefügt hätten.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.