KI-Chips: Graphcore schlägt das erste Mal Nvidia

Graphcores IPU-POD16 schlägt in einem wichtigen KI-Benchmark das erste Mal Nvidia. Bekommt der Platzhirsch ernsthafte Konkurrenz?

Auf dem Markt für KI-Hardware sind alternative Anbieter zu Nvidias KI-Angebot noch immer die Ausnahme. Unternehmen wie Cerebras oder Graphcore wollen das ändern und fordern Nvidia heraus: Cerebras riesiger KI-Chip hat 2,6 Billionen Transistoren und soll KI-Netze auf Gehirnniveau erlauben. Graphcores IPU-POD-Systeme setzen auf den MK2 GC200-Chip mit knapp 60 Milliarden Transistoren.

Das 2016 gegründete britische Unternehmen wird auf einen Unternehmenswert von knapp 2,8 Milliarden US-Dollar geschätzt und plant nach einer möglichen weiteren Finanzierungsrunde einen Börsengang ab dem kommenden Jahr. Den direkten Konkurrenten Nvidia forderte Graphcore bereits Ende 2020 heraus, als das Unternehmen verkündete, die eigene KI-Lösung IPU-POD16 biete mehr Leistung pro US-Dollar als Nvidias DGX A100 640 Gigabyte Server.

Graphcores Benchmarks zeigen Fortschritte

Diese Behauptung wurde von Nvidia und auch unabhängigen Experten kritisiert. Laut des Fachmagazins ServeTheHome entsprachen die von Graphcore angegebenen Preise für Nvidias DGX A100 nicht den tatsächlich gezahlten Preisen im Markt.

Der Preisvergleich sei außerdem für Graphcore notwendig, da die eigenen Produkte nicht mit der Trainings- und Inferenzgeschwindigkeit von Nvidias Alternative im MLPerf-Benchmark mithalten konnten. Der KI-Benchmark wird vom Konsortium MLCommons betrieben und soll die Leistung verschiedener Chip-Architekturen unabhängig von Herstellermessungen transparent machen.

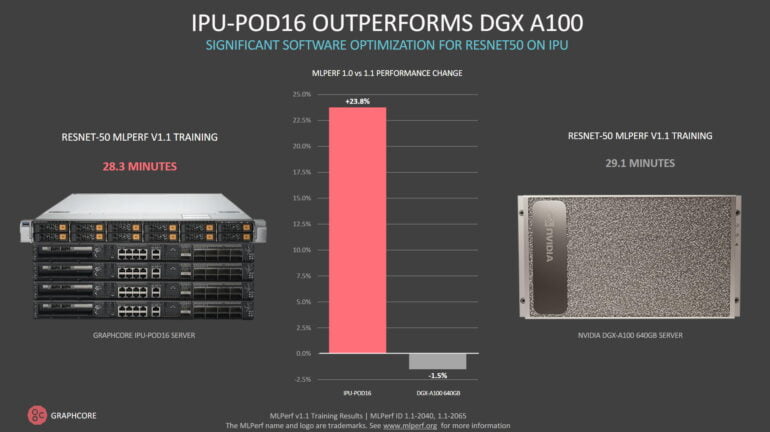

In der jüngsten Einreichung in den MLPerf-Benchmark zeigt Graphcores Produkt nun jedoch Fortschritte und schlägt in zumindest einer Kategorie Nvidias Produkt. Ermöglicht wurde dieser Erfolg laut Graphcore durch Softwareoptimierungen.

Sind knapp 60 Sekunden Vorteil ein großer Schritt?

Laut Graphcore benötigt das IPU-POD16 mit 16 Mk2 GC200-Chips 28,3 Minuten, um das Bildanalyse-Netz ResNet-50 zu trainieren. Nvidias DGX A100 benötige 29,1 Minuten. Im Vergleich zum letzten Test entspreche das einer Verbesserung von 24 Prozent. Graphcores Lösung hat also knapp 60 Sekunden Vorsprung.

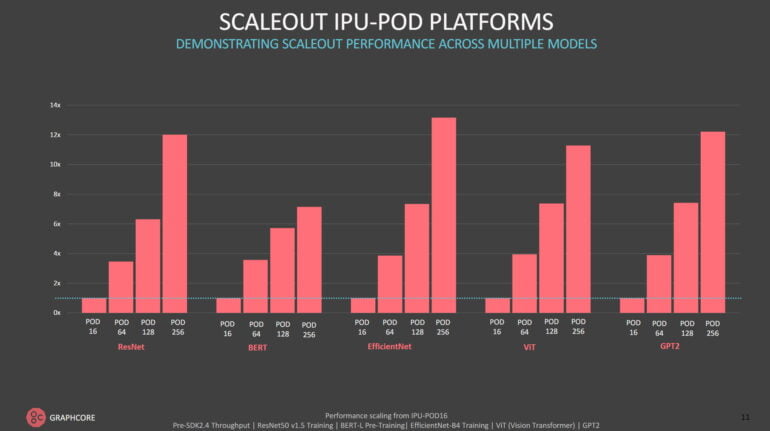

Das ist nicht viel, doch für ein Unternehmen, das mit Nvidia konkurrieren will, ein wichtiger Erfolg. Die Leistungsgewinne durch die neuen Softwareoptimierungen sind laut Graphcore in den größeren IPU-POD64-Systemen noch höher. Ganze 41 Prozent schneller läuft das System als noch vor einem halben Jahr. Die noch größeren Systeme IPU-POD128 und IPU-POD256 trainieren ResNet-50 in 5,67 bzw. 3,79 Minuten.

Auch beim KI-Training des Sprachmodells BERT spielt Graphcore oben mit, bleibt allerdings hinter Nvidia zurück. Hier liegen die Leistungsgewinne im Vergleich zum Sommer bei fünf bis zwölf Prozent.

Graphcore etabliert sich als Alternative

Die KI-Hardware des britischen Unternehmens bietet außerdem gute Performance beim Training von neueren KI-Modellen wie EfficientNet-B4, GPT-Modellen oder Vision-Transformern. Diese Modelle sind nicht Teil der geschlossenen Klasse von MLPerf, können aber in der offenen Klasse verglichen werden.

Laut Graphcore zeigt die eigene Hard- und Software hier teils deutliche Verbesserungen: Ein IPU-POD16 trainiere EfficientNet-B4 in 20,7 Stunden, ein DGX A100-System benötige 70,5 Stunden.

Graphcore plant weitere Softwareoptimierungen und Updates für Kunden. Im Laufe des Jahres 2021 haben sich Hardware- und Softwarepartner wie Hugging Face, PyTorch Lightning, VMWare und Docker Hub Graphcore angeschlossen. In Großbritannien scheint langsam ein echter Konkurrent für Nvidias KI-Geschäfte zu entstehen. Dort ist auch Nvidias geplanter Kauf von ARM stark umstritten.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.