Der renommierte KI-Forscher Geoffrey Hinton glaubt, dass mit Deep Learning trainierte KI menschenähnliche Intelligenz erreichen kann.

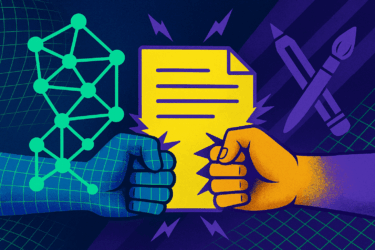

Die KI-Szene ist sich uneins: Manch einer, wie der KI-Forscher Gary Marcus, glaubt, dass die Deep-Learning-Methode in eine Sackgasse führt. Die grundlegende Kritik: Mit Deep Learning trainierte KI-Systeme können zwar enorme Erinnerungsleistungen abrufen, erlangen aber keinen gesunden Menschenverstand und können daher nicht flexibel auf Veränderungen in den Umgebungsparametern reagieren.

Der KI-Forscher und Turing-Preisträger Geoffrey Hinton (Universität Montreal / Microsoft) gehört zu den Befürwortern des Deep Learning. Seit den 1980ern forscht Hinton an der Technologie, es benötigte aber die Durchbrüche bei Datenverfügbarkeit und Rechenleistung der aktuellen Dekade, um sie glänzen zu lassen. Hinton ist mitverantwortlich für den ImageNet-Durchbruch, der Deep Learning für die Bildanalyse etablierte und Grundlage war für die rasante KI-Entwicklung der letzten zehn Jahre.

"Deep Learning kann alles"

Hinton geht davon aus, dass nach dem Deep Learning-Prinzip konzipierte und trainierte Künstliche Intelligenz eines Tages "alles können wird". Dafür benötige es allerdings noch grundlegende konzeptionelle Durchbrüche. Als Beispiel für so einen Durchbruch nennt Hinton die heute bei Sprach-KIs fast schon standardmäßig eingesetzte Transformer-Architektur, die tausende Wörter im Kontext gleichzeitig auswerten kann. Vorherigen Architekturen schafften nur bis zu hundert Wörter.

"Wir brauchen noch mehr dieser Durchbrüche", sagt Hinton, speziell mit Blick auf die Nachbildung des logischen Denkens. Sollten diese Durchbrüche gelingen, dann glaubt Hinton, dass mittels Deep Learning trainierte KI-Systeme die gesamte menschliche Intelligenz abbilden werden.

Eine weitere Voraussetzung sei dabei die massive Skalierung der Systeme: mehr Daten, größere Netze. Ein aktuell als groß geltendes KI-Modell wie GPT-3, das "wundervollen Text" generiere, habe 175 Milliarden Parameter. Das menschliche Gehirn hingegen habe 100 Billionen Paramter.

"Es [GPT-3] ist tausendmal kleiner als das Gehirn. GPT-3 kann jetzt einen ziemlich plausibel aussehenden Text erzeugen, und verglichen mit dem Gehirn ist es immer noch winzig klein", sagt Hinton.

Motorische Kontrolle sei ebenfalls ein wichtiger Forschungsbereich für KI, so Hinton. Er verweist auf eine Forschungsarbeit von Google, die bewiesen habe, dass ein KI-System feinmotorische Tätigkeiten wie das Öffnen einer Schublade bei gleichzeitiger Beschreibung dieser Tätigkeit lernen könne.

Quelle: MIT | Titelbild: Universität Toronto, Screenshot bei YouTube