KI rekonstruiert Gesichter anhand der Stimme - und das erstaunlich gut

Ein KI-Experiment der Universität Carnegie Mellon wirft erneut die Frage auf: Wo sind die Grenzen maschineller Statistik?

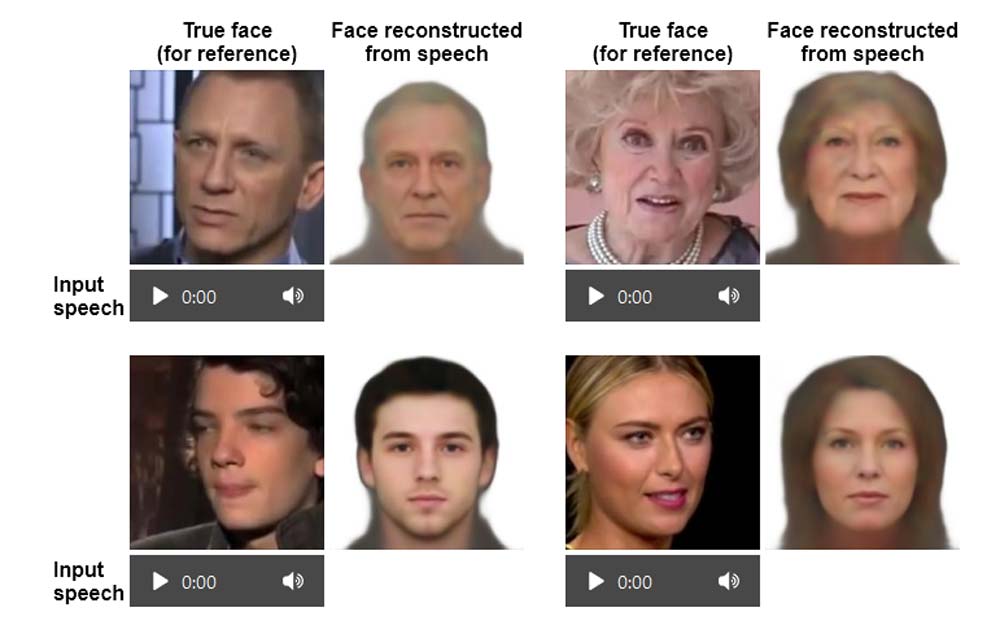

KI-Forscher der Universität Carnegie Mellon haben ein neuronales Netzwerk darauf trainiert, passend zu einer Stimme ein Gesicht zu zeichnen. Die KI analysiert dafür einen kurzen Audioclip und zeigt dann, wie das Gesicht hinter der Stimme im echten Leben aussehen könnte.

Fürs KI-Training verwendeten die Forscher Millionen Internetvideos sprechender Personen. Die KI analysierte sowohl die Sprache als auch die Struktur des Gesichts und untersuchte mögliche Zusammenhänge. Außerdem wurden physische Faktoren wie Alter, Geschlecht und Herkunft berücksichtigt.

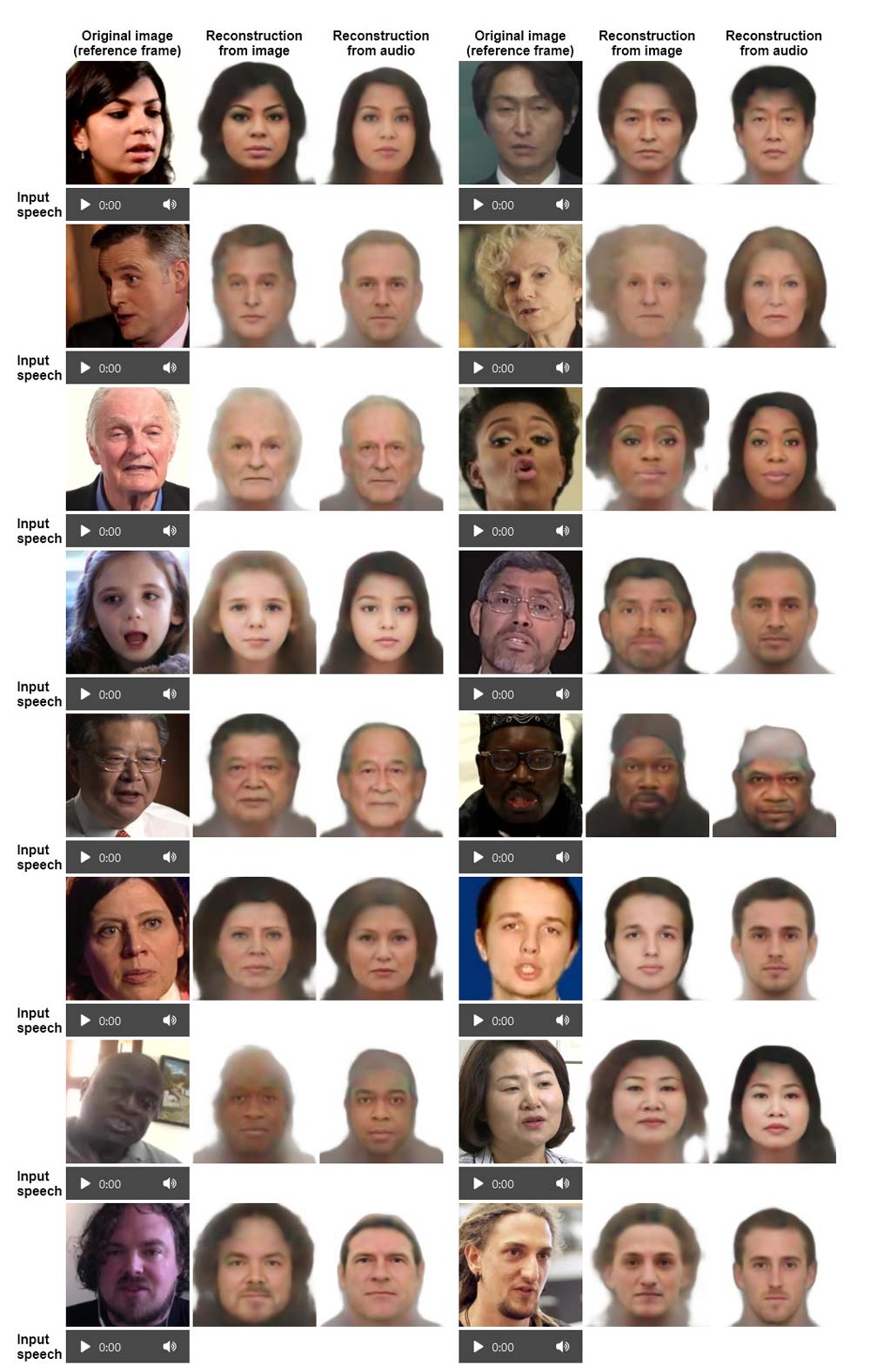

Die KI wühlte sich beim Training eigenständig durch die Daten, eine aufwendige Kennzeichnung vorab war nicht notwendig. Laut der Forscher liegen die Übereinstimmungen im Aussehen zwischen der halluzinierten und der tatsächlichen Person "deutlich über Zufallsniveau". Die folgenden Beispiele zeigen einen Vergleich zwischen einer bild- und einer audiobasierten KI-Rekonstruktion.

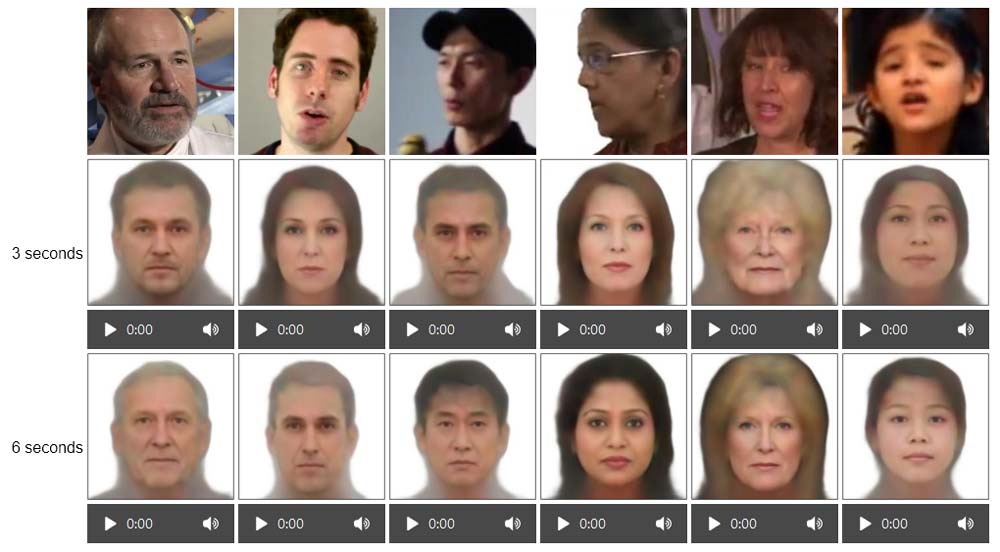

Die Forscher stellen außerdem fest, dass die Ähnlichkeit des generierten Gesichts bei längeren Audiobeispielen steigt. Die Verbesserung betrifft insbesondere die Vorhersage über Alter, Geschlecht und Herkunft.

Die Forscher weisen darauf hin, dass ihr Datensatz unvollständig und damit unausgewogen ist. Die Gesichter zu Stimmen mit ungewöhnlichem Klang oder in unterrepräsentierten Sprachen könnten weniger genau rekonstruiert werden.

Einige der Faktoren der Gesichtsprognose, wie zum Beispiel Haarfarbe oder die Frisur, hätten womöglich keinen direkten Zusammenhang mit dem Klang der Stimme. Wenn jedoch viele Sprecher in den Trainingsdaten in ähnlicher Weise sprechen und noch dazu visuelle Eigenschaften teilen, beeinflusse das die Vorhersagen.

Die Forscher beschreiben ihr Experiment im Detail auf einer Projektseite. Das vollständige Papier ist hier einsehbar.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.