KI-Studie erklärt Schwächen bei Schlussfolgerungen - und zeigt Lösungsansatz

Forscher der Ohio State University und der Carnegie Mellon University haben in einer neuen Studie untersucht, ob Transformer-Modelle in der Lage sind, implizite Schlussfolgerungen zu ziehen. Ihre Ergebnisse zeigen, dass die Modelle diese Fähigkeit durch so genanntes "Grokking" erwerben können - allerdings nicht für alle Arten von Schlussfolgerungen gleichermaßen.

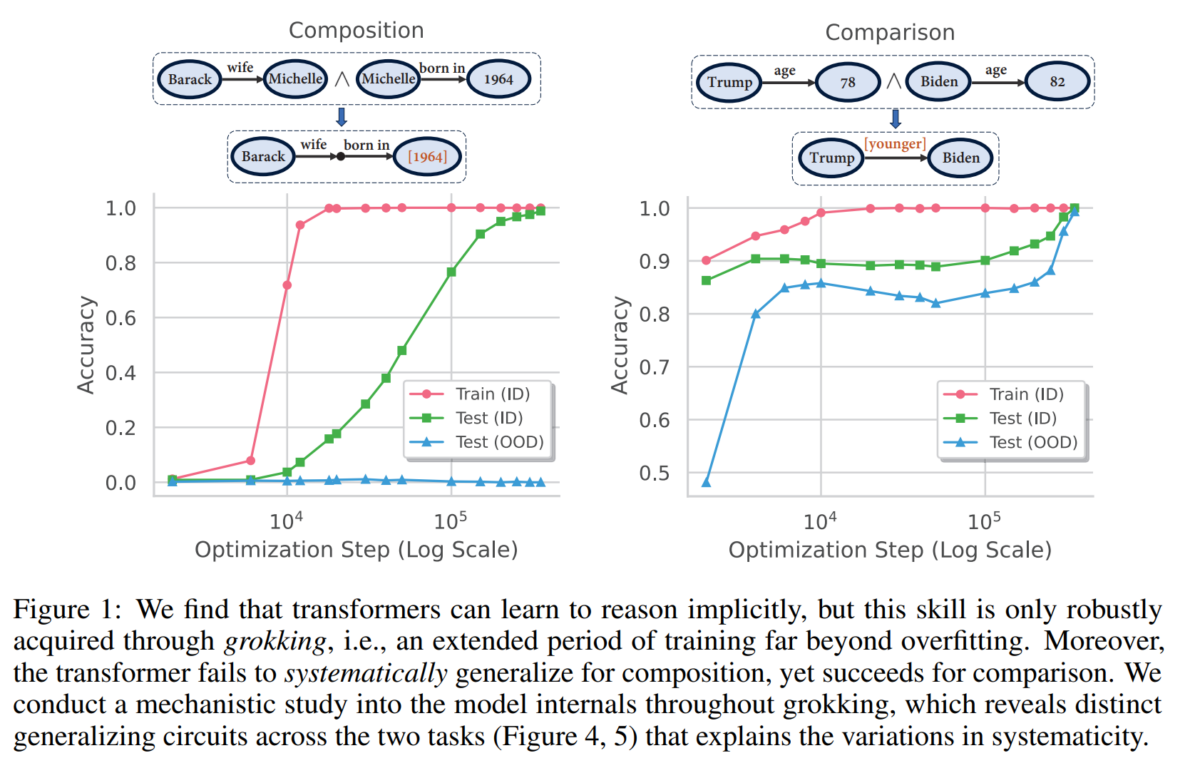

Die Wissenschaftler untersuchten zwei repräsentative Typen von Schlussfolgerungen: Komposition und Vergleich. Bei der Komposition müssen mehrere Fakten miteinander verknüpft werden, zum Beispiel "Baracks Frau heißt Michelle" und "Michelle wurde 1964 geboren", um den Satz "Baracks Frau wurde [1964] geboren" zu vervollständigen. Beim Vergleich werden Attributwerte von Entitäten verglichen, z. B. das Alter zweier Personen.

Die Ergebnisse zeigen, dass Transformer-Modelle bei beiden Aufgabentypen durch längeres Training über den Punkt des Overfittings hinaus hin zum "Grokking" die Fähigkeit zum impliziten Schlussfolgern erwerben. So erreichte das Netz nach 14.000 Trainingsschritten zwar eine gesättigte Trainingsleistung, aber noch keine Generalisierung. Mit zunehmender Anzahl von Trainingsschritten nahm jedoch die Generalisierungsleistung zu, bevor nach etwa 50-fachem Training eine nahezu perfekte Genauigkeit erreicht wurde.

Aber was genau bedeutet hier Generalisierung? Das Team unterteilte die Trainingsdaten in "atomare" Fakten und daraus abgeleitete Fakten - ähnlich wie im obigen Beispiel. Die atomaren Fakten wurden in "In-Distribution"- und "Out-of-Distribution"-Fakten unterteilt. Anders als der Name vermuten lässt, wurde das Transformer-Modell jedoch mit allen atomaren Fakten trainiert. Aus diesen wurden jedoch auch abgeleitete Fakten gebildet, mit denen das Netz ebenfalls trainiert wurde - allerdings nur für die abgeleiteten Fakten, die nicht aus den OOD-Fakten gebildet wurden. Diese letzte Gruppe wurde für die Tests zurückgehalten. Damit stellt das Team sicher, dass es in seinen Tests auch überprüfen kann, ob die Netze systematisch generalisieren lernen - also z.B. im Fall der Kompositionsaufgaben bekannte Fakten (gelernte atomare OOD-Fakten) zu neuen abgeleiteten Fakten (nicht gelernte abgeleitete OOD-Fakten) kombinieren können.

In den Tests stellte das Team einen deutlichen Unterschied im Generalisierungsverhalten fest: Während die Modelle bei Vergleichsaufgaben auch auf ungesehene Beispiele (Out-of-Distribution, OOD) generalisieren können, gelingt dies bei Kompositionsaufgaben nicht. Dies deckt sich mit vielen anderen Forschungsergebnissen, die das Gleiche festgestellt haben. Das Team fand außerdem heraus, dass die Geschwindigkeit der Generalisierung mit dem Verhältnis zwischen abgeleiteten und atomaren Fakten im Training korreliert und nicht mit der absoluten Größe der Trainingsdaten.

Warum Transformer nicht Generalisierung - und wie das Problem vielleicht gelöst werden kann

Das Besondere an dieser Arbeit: Das Team hat eine Erklärung für das unterschiedliche Verhalten. Die Forscher führen den Unterschied auf die innere Struktur der gelernten Schaltkreise zurück. Bei Vergleichsaufgaben werden die relevanten Fakten parallel verarbeitet, was eine systematische Generalisierung ermöglicht. Bei Kompositionsaufgaben hingegen werden die Fakten sequentiell in verschiedenen Schichten des Netzwerks verarbeitet, was die OOD-Generalisierung behindert.

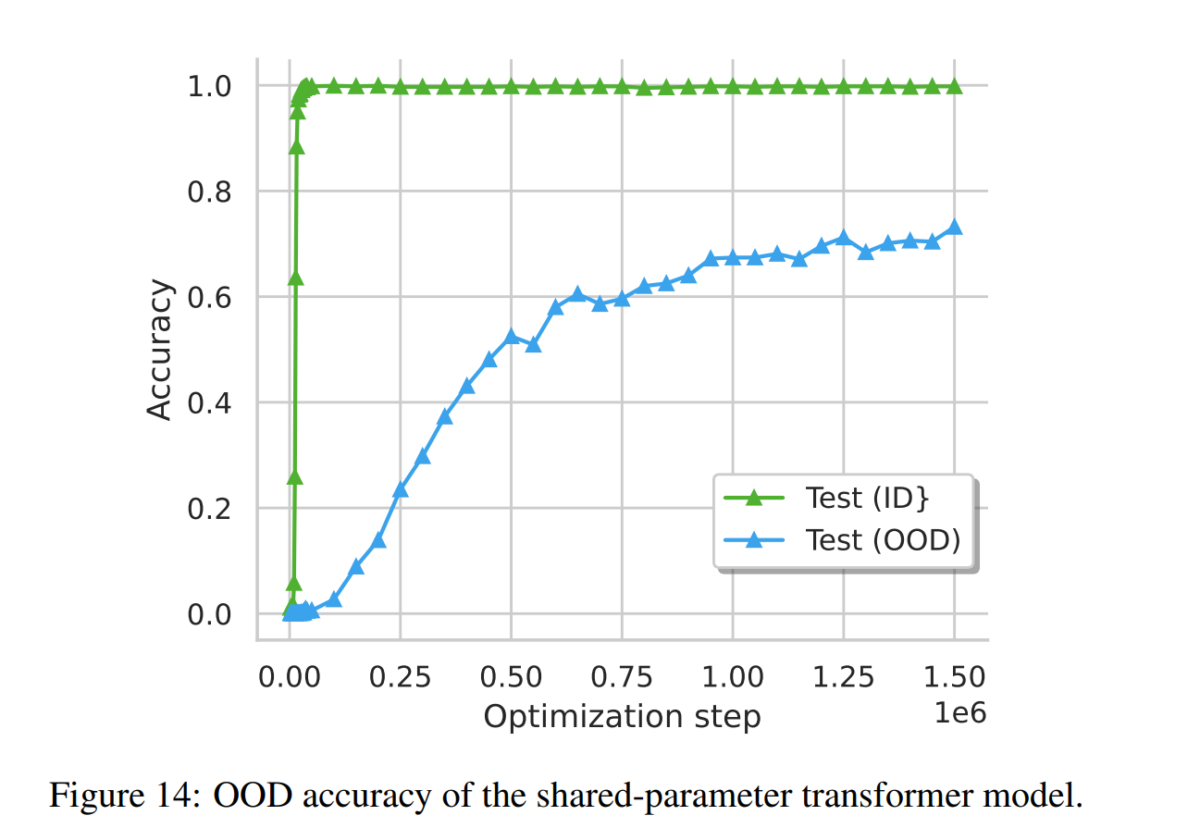

Dies bedeutet im Umkehrschluss, dass eine Verbindung zwischen den Schichten eine OOD-Generalisierung für Kompositionsaufgaben ermöglichen könnte. Die Autoren schlagen daher Anpassungen der Transformer-Architektur vor. Insbesondere zeigen sie, dass ein Parameter-Sharing-Schema ähnlich dem Universal Transformer tatsächlich die OOD-Generalisierung bei Kompositionsaufgaben ermöglicht, wenn auch langsamer als die In-Distribution-Generalisierung.

Um zusätzlich die zentrale Bedeutung des "parametrischen" Wissens - also des impliziten, im Netzwerk gespeicherten Wissens - für die Generalisierung zu verdeutlichen, entwickelten die Forscher eine anspruchsvolle Aufgabe mit einem großen Suchraum. Sie trainierten ein Modell mit den Daten zu "Grokking" und verglichen seine Leistung mit anderen Modellen, die auf dieses Wissen nur über Retrieval-Augmented Generation oder innerhalb des Kontextfensters zugreifen konnten. Während moderne Sprachmodelle wie GPT-4-Turbo und Gemini-Pro-1.5 an dieser Aufgabe scheiterten, konnte ein vollständig "gegrokkter" Transformer die Aufgabe mit nahezu perfekter Genauigkeit lösen.

Für alle Experimente verwendete das Team synthetische Datensätze, so dass noch nicht klar ist, ob die Ergebnisse sich vollständig in realen Szenarien widerspiegeln. Darüber hinaus wurden nur zwei spezifische Formen der Schlussfolgerung untersucht.

Das Team empfiehlt weitere Forschung zu geeigneten schichtübergreifenden Mechanismen in Transformatoren, um die Generalisierung zu verbessern, sowie zu der Frage, wie parametrisches und nicht-parametrisches (Kontextfenster / RAG) Gedächtnis in Sprachmodellen ausbalanciert werden können. Weitere Forschung sollte sich zudem auf die Ausweitung der Analyse auf ein breiteres Spektrum von Reasoning-Aufgaben und komplexere Sprachmodelle konzentrieren.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.