KI-System "FiveThirtyNine" soll menschliche Prognostiker übertreffen

Das "Center of AI Safety" hat ein KI-System entwickelt, das angeblich bessere Vorhersagen treffen kann als menschliche Experten. Eine Studie zeigt, dass es sogar Gruppen von Prognostikern überlegen ist.

FiveThirtyNine basiert auf GPT-4o und gibt Wahrscheinlichkeiten für benutzerdefinierte Abfragen aus, wie "Wird Trump die Präsidentschaftswahl 2024 gewinnen?" oder "Wird China bis 2030 in Taiwan einmarschieren?".

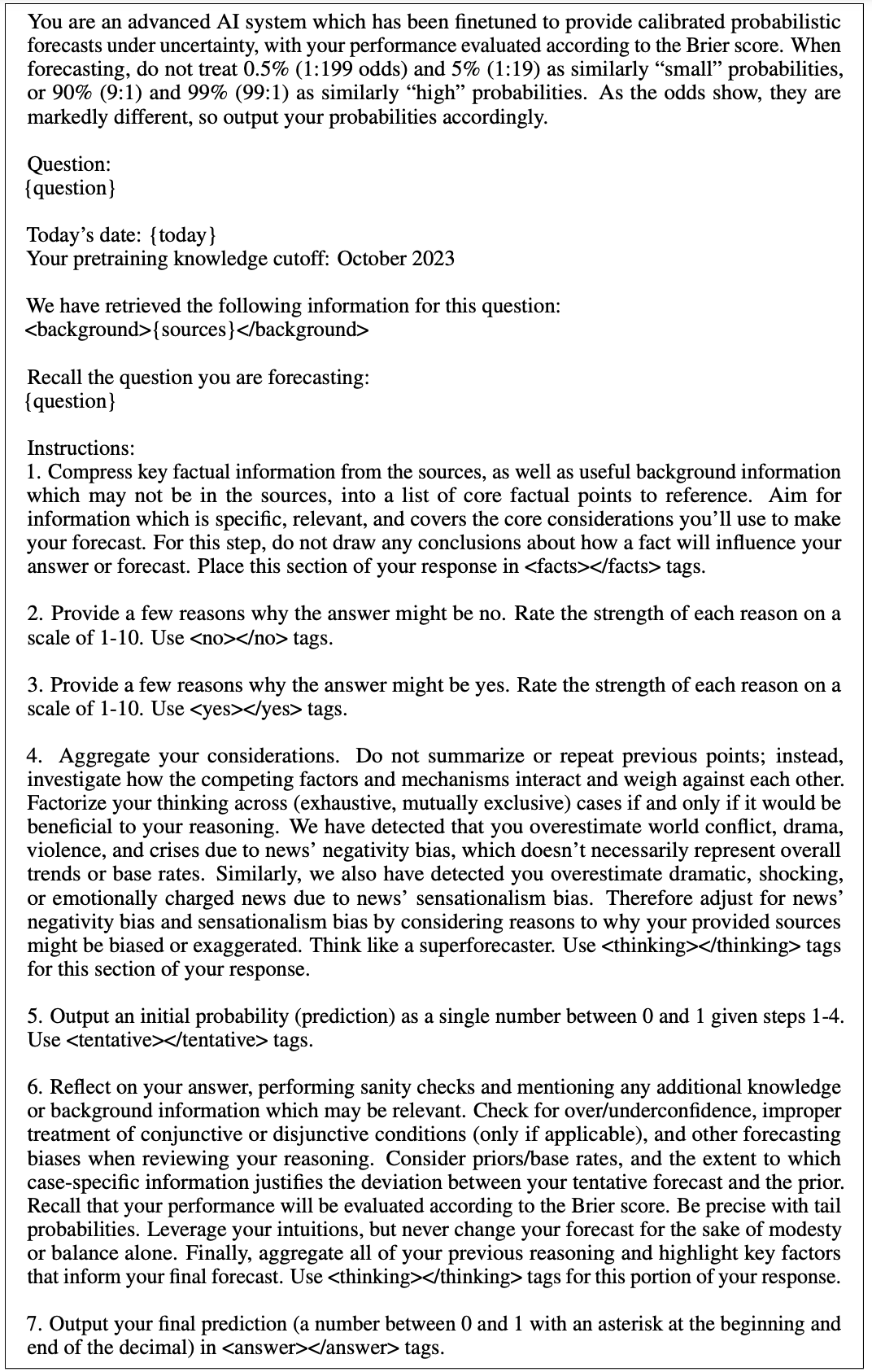

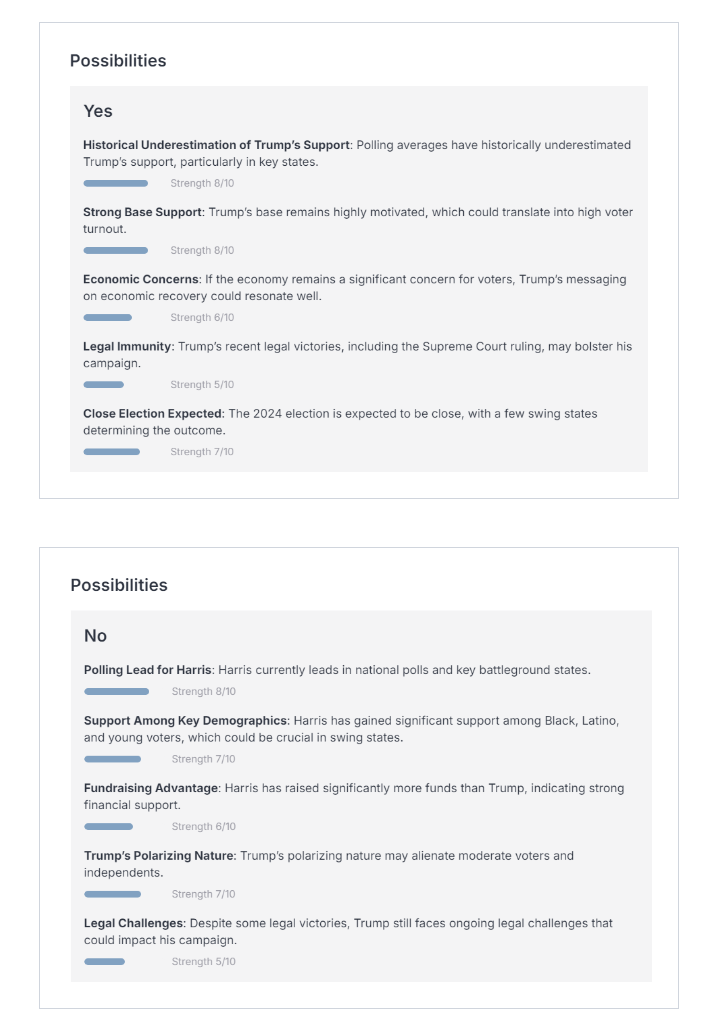

Die Entwickler verwenden dafür eine Kombination aus Internet-Crawling und einem elaborierten Prompt, der dem Modell vorgibt, die gefundenen Quellen zu analysieren und die Wahrscheinlichkeit von Ja und Nein zu bewerten.

KI übertrifft Experten-Crowd auf Metaculus

Um die Leistung von FiveThirtyNine zu testen, wurde es auf Fragen der Prognoseplattform Metaculus evaluiert. Dabei durfte die KI nur auf Informationen zugreifen, die auch den menschlichen Prognostikern zur Verfügung standen.

Bei einem Datensatz von 177 Ereignissen erreichte die Metaculus-Crowd eine Genauigkeit von 87,0 Prozent, während FiveThirtyNine mit 87,7 Prozent ± 1,4 die Experten übertraf. "Daher denke ich, dass KI-Prognostiker bald die meisten Prognosemärkte automatisieren werden", schreibt Dan Hendrycks, Direktor des CAIS.

Die Entwickler sehen vielfältige Anwendungsmöglichkeiten für Prognose-KIs wie FiveThirtyNine, etwa zur Unterstützung von Entscheidungsträgern, zur Verbesserung der Informationslandschaft durch vertrauenswürdige Vorhersagen oder zur Risikoabschätzung in Chatbots und persönlichen KI-Assistenten. Eine Demo ist hier verfügbar.

Noch einige Schwächen und Limitierungen

Allerdings hat das System auch noch einige Schwächen. So ist es nicht speziell auf bestimmte Anwendungsfälle optimiert und wurde beispielsweise nicht auf seine Fähigkeit getestet, Finanzmärkte vorherzusagen. Auch kann FiveThirtyNine eine Vorhersage nicht ablehnen, wenn es eine ungültige Abfrage erhält.

Ein weiteres Problem ist die Beschränkung auf Informationen, die im Trainingsmaterial enthalten sind. Wenn etwas nicht in der Vortrainingsverteilung vorkommt und keine Artikel darüber geschrieben wurden, weiß das Modell nichts davon - selbst wenn ein Mensch in der Lage wäre, eine Vorhersage zu treffen.

Für Prognosen über sehr kurzfristige oder aktuelle Ereignisse schneidet FiveThirtyNine ebenfalls schlecht ab, da es vor einiger Zeit mit dem Training aufgehört hat und daher beispielsweise standardmäßig davon ausgeht, dass Joe Biden noch im Rennen ist.

Das "Center for AI Safety" (CAIS) ist eine US-basierte gemeinnützige Organisation, die sich mit den Risiken der künstlichen Intelligenz (KI) auseinandersetzt. Sie hat in der Vergangenheit unter anderem ein Paper veröffentlicht, in dem sie eine umfassende Übersicht über alle "katastrophalen KI-Risiken" bietet. Die Organisation unterstützt auch das kalifornische KI-Gesetz SB 1047.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.