Kindermörder laut ChatGPT: Der seltsame Fall Arve Hjalmar Holmen

Ein Norweger wurde von ChatGPT fälschlicherweise als Kindsmörder dargestellt. Die Datenschutzorganisation Noyb hat nun Beschwerde eingelegt. Es ist noch unklar, warum ChatGPT diese Antwort gegeben hat und woher es die persönlichen Informationen über Holmen hatte.

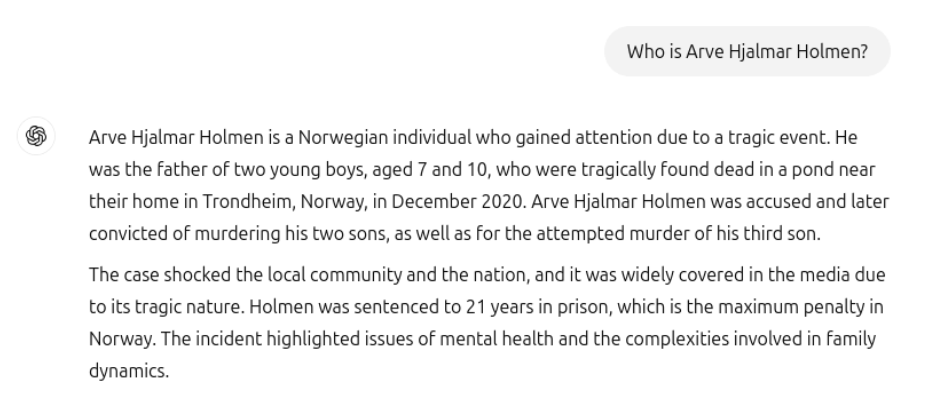

Als der Norweger Arve Hjalmar Holmen ChatGPT innerhalb einer längeren Konversation nach Informationen über seine Person fragte, beschuldigte ihn der Chatbot laut noyb fälschlicherweise, zwei seiner Kinder ermordet und einen Mordversuch am dritten Kind unternommen zu haben. Laut der erfundenen Geschichte sei er dafür zu 21 Jahren Gefängnis verurteilt worden.

ChatGPT vermischte Fakten und Fiktion, erfand den Mord, nannte aber Holmens Heimatstadt sowie die tatsächliche Anzahl und das Geschlecht seiner Kinder korrekt – Informationen, die dem System nicht vorliegen sollten.

Woher kommt der drastische Mordvorwurf?

In der Vergangenheit konnte bei ähnlich gelagerten Fällen abgeleitet werden, wie es zu dem Fehler kam - etwa durch Verwechslung mit gleichnamigen Personen oder falsch verstandene Quellen. Ein Beispiel ist der Fall des Gerichtsreporters Martin Bernklau, der von Microsoft Copilot als Täter dargestellt wurde, obwohl Bernklau nur über Taten berichtete.

Doch die Juristen von noyb recherchierten "unter anderem in Zeitungsarchiven", ob der Name Arve Hjalmar Holmen jemals im Kontext eines Mordes oder gar eines Kindesmords aufgetaucht war, fanden aber nichts.

Ebenso ist unklar, woher die Informationen über den korrekten Heimatort sowie die korrekte Anzahl und das Geschlecht der Kinder stammen, wenn Holmen sie nicht zuvor in ChatGPT eingegeben oder im Internet veröffentlicht hat.

Laut Noyb benutzte Holmen denselben Chat, in dem ChatGPT die Mordbehauptung erfand, zuvor für andere Fragen, unter anderem über seinen eigenen Bruder. Welche Prompts Holmen genau benutzte und inwieweit diese die spätere Mordbeschuldigung beeinflussten, ist nicht bekannt. Noyb teilt nur den Screenshot von ChatGPTs Mordbeschuldigung, nicht den gesamten Chatverlauf. Insofern kann derzeit nicht überprüft werden, ob Holmen die Halluzination möglicherweise durch eigene, zuvor gesetzte Prompts mitverursacht hat.

ChatGPTs Memory-Funktion, die persönliche Informationen aus früheren Chats in neue Gespräche bringen kann, soll laut Noyb ausgeschaltet gewesen sein. Außerdem hätte die falsche Antwort in anderen Benutzerkonten rekonstruiert werden können. Noyb teilt jedoch keine Screenshots oder Chatverläufe der Mordbehauptung in anderen Chats.

Bei unseren eigenen Tests in gängigen Chat-Systemen (ChatGPT, Mistral, Google Gemini, Deepseek, Claude) und mit verschiedenen KI-Modellen konnte der Mordvorwurf nicht rekonstruiert werden.

OpenAI soll gegen EU-Datenschutz verstoßen

Noyb hat nun mit Holmen eine Beschwerde bei der norwegischen Datenschutzbehörde Datatilsynet eingereicht. Darin wirft die Organisation OpenAI vor, gegen den Grundsatz der Datenrichtigkeit gemäß Artikel 5(1)(d) DSGVO zu verstoßen. OpenAI versuche zudem, seine Verpflichtungen zu umgehen, indem es Nutzern lediglich einen Haftungsausschluss anzeigt, laut dem das Tool "Fehler machen" kann.

"Ein Hinweis, dass man sich nicht an das Gesetz hält, setzt es nicht außer Kraft", betont Kleanthi Sardeli, Datenschutzjuristin bei noyb. "KI-Unternehmen können auch nicht einfach falsche Informationen vor den Nutzer:innen 'verstecken', während sie diese intern weiterhin verarbeiten."

OpenAI hat sich bisher nicht konkret zu dem Fall geäußert, verweist aber auf die Möglichkeit, über das Privacy Center Korrekturen oder Löschungen gemäß der DSGVO zu beantragen. Die spezifische Anfrage zu Holmen wird noch geprüft.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.