Künstliche Intelligenz: Putzroboter sollen Politikern gefährlich werden

Mit Künstlicher Intelligenz und maschinellen Lernverfahren haben Hacker mächtige Werkzeuge für neue Cyber-Attacken an der Hand. Eine Expertenuntersuchung beschreibt mögliche Hacks und Ansätze, um diese Risiken einzuschränken.

In dem Bericht The Malicious Use of Artificial Intelligence: Forecasting, Prevention, and Mitigation beschreiben 26 Experten aus 14 Institutionen und Organisationen auf rund 100 Seiten neue Cyber-Risiken durch Künstliche Intelligenz. Die Autoren arbeiten unter anderem für die Oxford und Cambridge Universität oder für die Non-Profit-KI-Organisation OpenAI. Das Papier basiert auf einem zweitägigen Workshop, der im Februar 2017 an der Oxford Universität stattfand.

Die Autoren beschreiben Szenarien, in denen sich Hacker das Automatisierungspotenzial und die fortschrittliche Sensorik von KI-Systemen zunutze machen. In einem Szenario attackiert ein gehackter und mit Sprengstoff ausgerüsteter Reinigungsroboter ein Ministerium. Er bewegt sich unerkannt unter anderen Reinigungsrobotern fort. Mittels Gesichtserkennung identifiziert er die Finanzministerin und sprengt sich in ihrer Nähe in die Luft.

Künstliche Intelligenz beauftragt menschliche Arbeiter

In einem zweiten Szenario beauftragt eine Künstliche Intelligenz einen freien Grafiker, eine stark personalisierte Werbeanzeige zu erstellen, die anhand von Online-Daten exakt auf einen spezifischen Nutzer zugeschnitten ist. Der Nutzer sieht diese Werbeanzeige bei Facebook und öffnet die mit ihr verbundene Broschüre, die Schadsoftware enthält. Die zieht sich Nutzerdaten und Zugänge vom PC, die dann auf einem Hacker-Marktplatz verkauft werden.

"Wir erwarten neue Arten von Cyber-Attacken, die menschliches Verhalten, Stimmungen und Überzeugungen analysieren und auszunutzen", schreiben die Autoren. Dies sei besonders in autoritären Staaten ein Risiko, könne aber - im Kontext von Fake-Medien, wie sie mit Deepfakes erstellt werden - auch in Demokratien eine konstruktive öffentliche Debatte verhindern.

Programmierer sollen Verantwortung übernehmen

Die Autoren sprechen einige Empfehlungen aus, wie den neuen Cyber-KI-Bedrohungen begegnet werden soll: Forscher in den Fachgebieten müssten verstehen, dass KI eine "Dual-Use"-Technologie ("doppelte Verwendung") sei. Sie könne sowohl zum Schaden als auch zum Wohle der Menschheit eingesetzt werden - so wie Nukleartechnik. Daher müssten sich mehr Menschen an der Diskussion zur Fortentwicklung Künstlicher Intelligenz beteiligen.

Gesetzgeber sollten enger mit der Tech-Branche zusammenarbeiten, um Risiken frühzeitig zu erkennen. Gängige Sicherheitspraktiken aus der IT-Branche müssten für KI-Attacken angepasst werden.

Außerdem müssten priorisiert Richtlinien und ethische Rahmenbedingungen entwickelt werden. Programmierer sollten eine "Kultur der Verantwortung" annehmen und bei ihrer Arbeit die Macht von geteilten Daten berücksichtigen.

Ausblick: Wie geht es weiter mit Künstlicher Intelligenz?

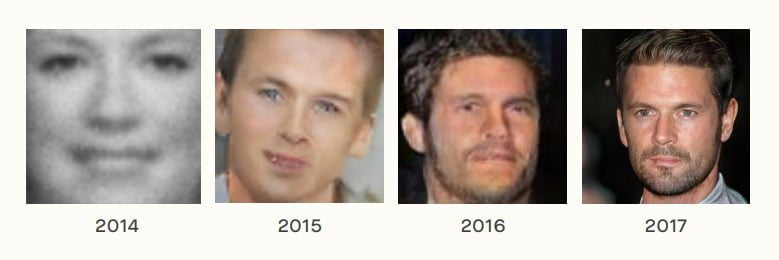

Abseits der Cyber-Bedrohungen erwarten die Autoren, dass Künstliche Intelligenz in vielen Bereichen weiter signifikante Fortschritte erzielt. Sie untermauern diese Annahme unter anderem mit durch KI generierte Fake-Porträts, die den visuellen Fortschritt von rund drei Jahren zeigen.

Heutige KI-Systeme beherrschten nur eine kleine Auswahl möglicher menschlicher Handlungen, so die Autoren. Allerdings wachse die Anzahl der Einsatzgebiete stetig.

Wenn eine Künstliche Intelligenz eine Fähigkeit entwickle, übertreffe sie in vielen Fällen selbst die talentiertesten Menschen. Viele KI-Forscher gingen davon aus, dass sich dieser Trend innerhalb der nächsten 50 Jahre zugunsten Künstlicher Intelligenz entwickle.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.