Update:

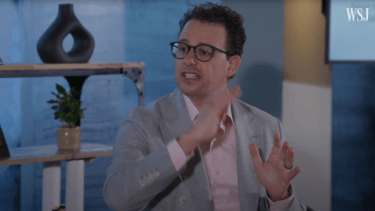

Microsofts CTO Kevin Scott bestätigt MAI auf LinkedIn: "Ich bin mir nicht sicher, warum das eine Neuigkeit sein soll."

Seit fast fünf Jahren baue Microsoft immer leistungsfähigere Supercomputer, die von OpenAI genutzt würden, um "bahnbrechende" KI-Modelle zu trainieren, so Scott.

Beide Unternehmen stellen diese Modelle dann in ihren Produkten und Dienstleistungen zur Verfügung. Microsofts eigene Forschungsteams entwickeln ebenfalls KI-Modelle, die in den Angeboten des Unternehmens verwendet werden, darunter einige Modelle wie Turing, MAI und das Open-Source-Modell Phi.

Scott betonte, dass die Vereinbarung mit OpenAI "weit in die Zukunft" reichen werde und kein Ende der Zusammenarbeit in Sicht sei.

Originalartikel vom 6. Mai 2024:

Microsoft arbeitet Insidern zufolge an einem eigenen großen KI-Sprachmodell, das es mit GPT-4 oder Google Gemini aufnehmen kann.

Microsoft will offenbar mehr Unabhängigkeit von OpenAI und trainiert erstmals ein eigenes großes KI-Sprachmodell (LLM), das mit den führenden Modellen von Google, Anthropic und OpenAI selbst konkurrieren kann, berichtet The Information. Verantwortlich für das neue Modell mit der internen Bezeichnung MAI-1 sei Mustafa Suleyman, so zwei Microsoft-Mitarbeiter.

Der ehemalige KI-Experte von Google Deepmind leitete zuletzt die KI-Firma Inflection, bevor Microsoft einen Großteil der Belegschaft übernahm und 650 Millionen Dollar für die Rechte am geistigen Eigentum zahlte.

MAI-1 soll jedoch ein Microsoft-Modell sein, kein von Inflection übernommenes, auch wenn es auf den Trainingsdaten und der Technologie des Start-ups basiert.

Das neue Modell wird den Quellen zufolge deutlich größer sein als die bisher von Microsoft trainierten Open-Source-Modelle. Es soll rund 500 Milliarden Parameter haben.

Zum Vergleich: Metas größtes Llama-3-Modell, das GPT-4 in allen Bereichen schlagen soll, hat mehr als 400 Milliarden Parameter.

Die Anzahl der Parameter ist jedoch lange nicht mehr das einzige Maß für die Leistungsfähigkeit eines KI-Modells. Das ursprüngliche GPT-4 hatte angeblich rund 1,8 Billionen Parameter.

Microsoft macht jetzt groß und klein

Damit verfolgt Microsoft nun eine Doppelstrategie: Neben "kleinen" und kostengünstigen Sprachmodellen für Apps und mobile Geräte will der Konzern auch große State-of-the-Art-Modelle entwickeln.

Der Schritt zeigt auch, dass Microsoft bezüglich KI einen eigenen, von OpenAI unabhängigen Weg gehen will. Deren Technologie steckt derzeit in allen KI-Copiloten von Microsoft. Gleichzeitig steht Microsoft immer wieder in Konkurrenz mit OpenAI im B2B-Geschäft.

Ein Grund dafür könnte sein, dass die Kartellbehörden in Europa und den USA die milliardenschwere Partnerschaft zwischen Microsoft und OpenAI prüfen. Mit der verdeckten Übernahme von Inflection hat Microsoft seine internen Kapazitäten zur Entwicklung eigener Sprachmodelle gestärkt.

Dass Microsoft durchaus in der Lage ist, konkurrenzfähige Sprachmodelle zu entwickeln, zeigt die Phi-Reihe: Diese kleineren Modelle für die lokale Anwendung sind auf Effizienz optimiert und kommen mit weniger Rechenleistung aus.

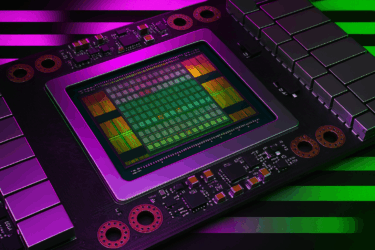

Für das Training des neuen, viel größeren Modells hat Microsoft laut Insidern einen großen Cluster von Nvidia-GPUs reserviert und Trainingsdaten zusammengestellt. Dazu gehören Daten von kleineren Modellen, von GPT-4 generierte Texte und öffentliche Daten aus dem Internet.

Der genaue Verwendungszweck von MAI-1 sei bisher nicht festgelegt und hänge von der Leistungsfähigkeit des Modells ab, so eine der Quellen. Microsoft könnte das neue Modell möglicherweise schon auf der Entwicklerkonferenz Build Ende Mai vorstellen - wenn die Entwicklung in den kommenden Wochen gut vorankommt.