Forschende von Meta stellen MCC vor, eine Methode, die aus einem einzigen Bild ein 3D-Modell rekonstruieren kann. Anwendungen sieht das Unternehmen in VR/AR und der Robotik.

KI-Modelle, die auf Architekturen wie Transformer und massig Trainingsdaten setzen, haben beeindruckende Sprachmodelle wie OpenAIs GPT-3 oder jüngst ChatGPT hervorgebracht.

Die Durchbrüche in der Verarbeitung natürlicher Sprache brachten eine zentrale Erkenntnis: Skalierung ermöglicht fundamentale Modelle, die bisherige Ansätze hinter sich lassen.

Die Voraussetzungen sind domänenunabhängige Architekturen wie Transformer, die neben Wörtern auch andere Modalitäten verarbeiten können sowie selbstüberwachtes Training aus unstrukturierten und teils unbeschrifteten Daten.

Diese Architektur wurde in Kombination mit großangelegtem, kategorieunabhängigem Lernen in den vergangenen Jahren vermehrt in Feldern außerhalb der Sprachverarbeitung angewandt, etwa bei der Bildsynthese oder der Bildanalyse.

Metas MCC bringt Skalierung in die 3D-Rekonstruktion

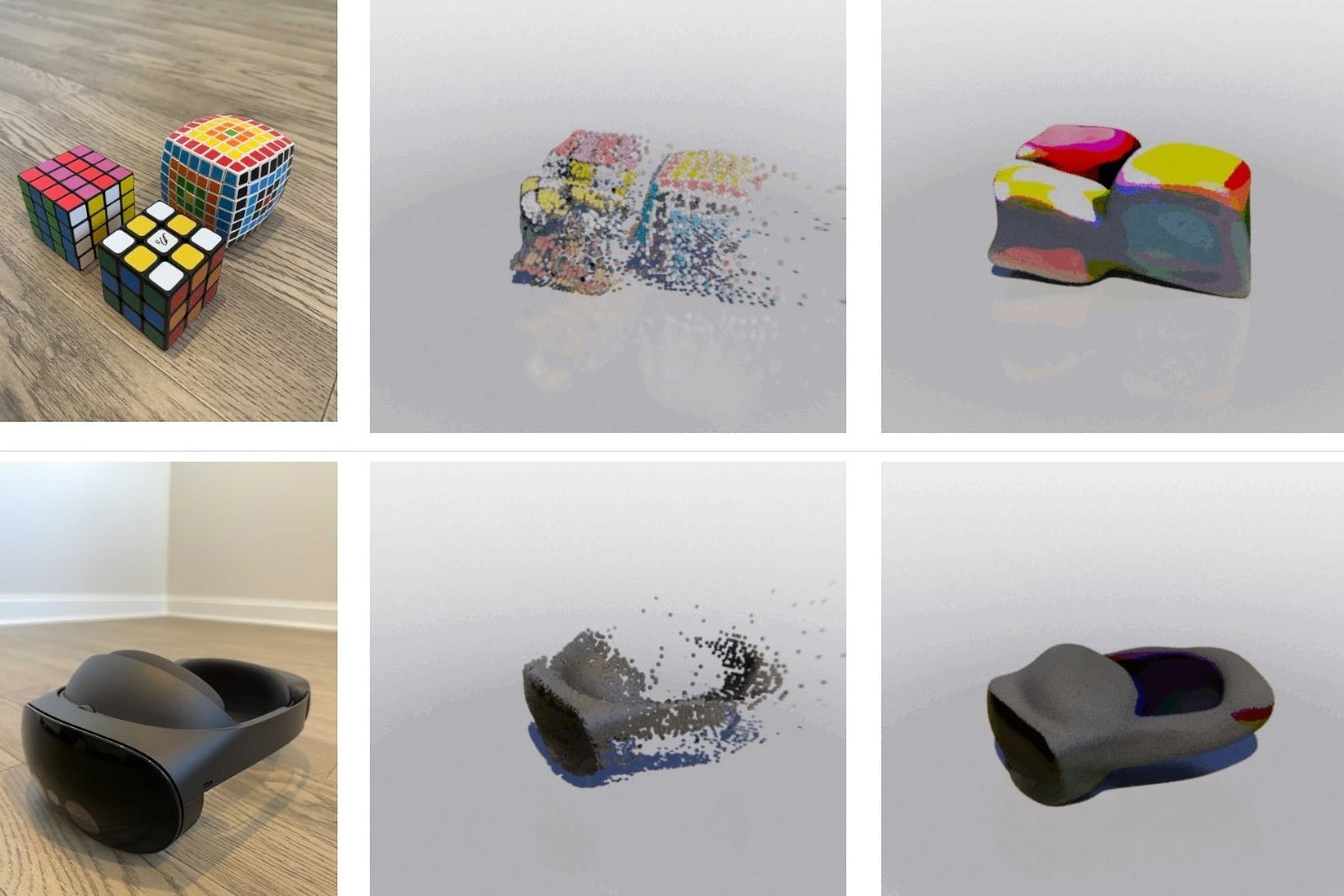

Metas FAIR Lab zeigt nun Multiview Compressive Coding (MCC), ein Transformer-basiertes Encoder-Decoder-Modell, das aus einem einzigen RGB-D-Bild 3D-Objekte rekonstruieren kann.

Die Forschenden sehen MCC als wichtigen Schritt auf dem Weg zu einem generalistischen KI-Modell für die 3D-Rekonstruktion mit Anwendungen in der Robotik oder AR/VR, wo ein besseres Verständnis von 3D-Räumen und -Objekten oder deren visuelle Rekonstruktion zahlreiche Möglichkeiten eröffnet.

Während andere Ansätze wie NeRFs mehrere Bilder benötigen, oder ihre Modelle mit 3D-CAD-Modellen oder anderen schwer zu beschaffenden und daher nicht skalierbaren Daten trainieren, setzt Meta auf die Rekonstruktion von 3D-Punkten aus RGB-D-Bildern.

Solche Bilder mit Tiefeninformationen sind mittlerweile durch die Verbreitung von iPhones mit Tiefensensoren und simplen KI-Netzen, die Tiefeninformationen aus RGB-Bildern ableiten, leicht verfügbar. Der Ansatz ist laut Meta daher gut skalierbar, große Datensätze seien in Zukunft leicht zu produzieren.

Um die Vorteile des Ansatzes zu zeigen, trainieren die Forschenden MCC mit zahlreichen Bildern und Videos mit Tiefeninformationen aus verschiedenen Datensätze, die Objekte oder ganze Szenen aus zahlreichen Blickwinkeln zeigen.

Während des KI-Trainings werden dem Modell einige verfügbare Ansichten jeder Szene oder jedes Objekts vorenthalten. Sie dienen als Lernsignal für die KI-Rekonstruktion. Der Ansatz entspricht dem Training von Sprach- oder Bildmodellen, bei denen häufig ebenfalls Teile der Daten maskiert werden.

Metas 3D-Rekonstruktion zeigt starke Generalisierbarkeit

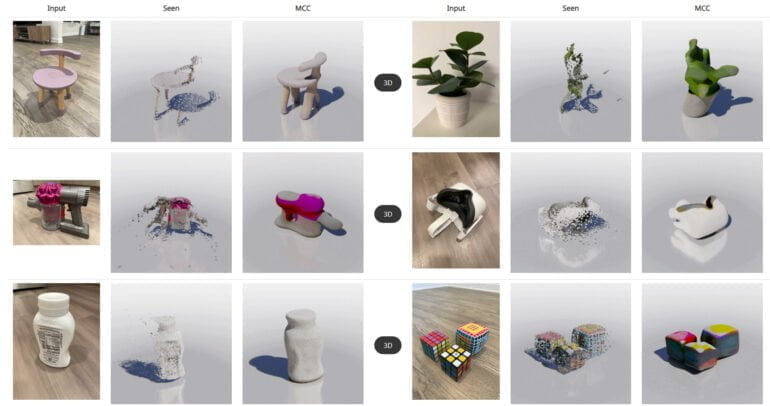

Metas KI-Modell zeigt in Tests, dass die Methode funktioniert und andere Ansätze übertrifft. Das Team sagt zudem, dass MCC auch mit Kategorien von Objekten oder ganzen Szenen umgehen kann, die es vorher noch nicht gesehen hat.

Video: Meta

Zudem zeigt MCC die erwarteten Skalierungseigenschaften: Die Leistung nimmt mit mehr Trainingsdaten und vielfältigeren Objektkategorien deutlich zu. iPhone-Aufnahmen, ImageNet- und DALL-E 2 Bilder können mit entsprechenden Tiefeninformationen ebenfalls in 3D-Punktewolken rekonstruiert werden.

Wir stellen MCC vor, ein universell einsetzbares 3D-Rekonstruktionsmodell, das sowohl für Objekte als auch für Szenen funktioniert. Wir zeigen die Verallgemeinerbarkeit in anspruchsvollen Umgebungen, einschließlich Aufnahmen in freier Wildbahn und KI-generierten Bildern von vorgestellten Objekten.

Unsere Ergebnisse zeigen, dass eine einfache punktbasierte Methode in Verbindung mit einem kategorieunabhängigen, groß angelegten Training effektiv ist. Wir hoffen, dass dies ein Schritt in Richtung eines allgemeinen Bildverarbeitungssystems für 3D-Verständnis ist.

Aus dem Paper

Die Qualität der Rekonstruktionen ist noch weit von einem menschlichen Verständnis entfernt. Doch mit der verhältnismäßig einfachen möglichen Skalierung von MCC könnte der Ansatz schnell besser werden.

Eine multimodale Variante, die etwa die Text-gesteuerte Synthese von 3D-Objekten ermöglicht, ist dann nur noch eine Frage der Zeit. Ähnliche Ansätze verfolgt auch OpenAI mit Point-E.

Zahlreiche Beispiele inklusive 3D-Modellen gibt es auf der MCC-Projektseite. Den Code gibt es auf Github.