Wenn ChatGPT & Co. ihre Antworten selbst überprüfen müssen, machen sie weniger Fehler, zeigt eine neue Studie von Meta.

ChatGPT und andere Sprachmodelle geben immer wieder falsche Informationen wieder - auch wenn sie eigentlich die richtige Information gelernt haben. Es gibt verschiedene Ansätze, um diese Fehlinformationen zu reduzieren. Forschende von Meta AI stellen nun mit Chain-of-Verification (CoVe) eine auf Prompts basierende Methode vor, die dieses Problem deutlich reduziert.

Neue Methode setzt auf Selbstverifikation des Sprachmodells

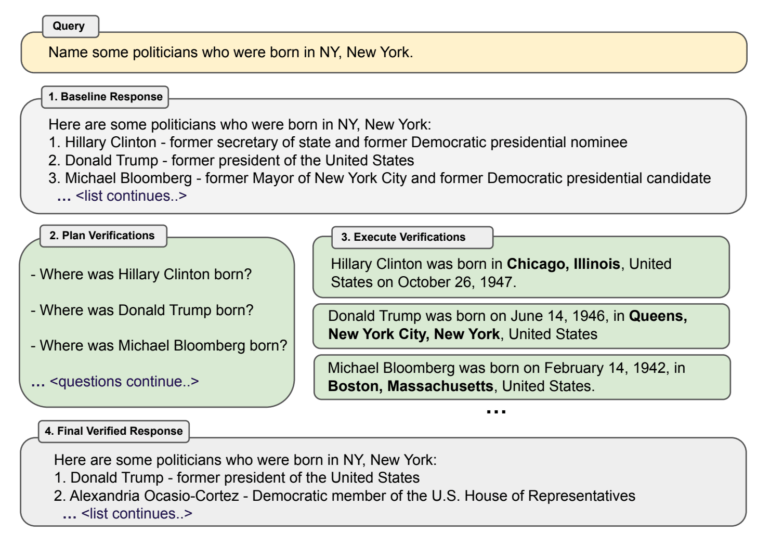

Bei CoVe gibt der Chatbot zunächst eine Ausgabe auf einen Prompt wie "Nenne einige Politiker, die in New York geboren wurden". Ausgehend von dieser Ausgabe, die oft bereits Fehler enthält, generiert das Sprachmodell dann Fragen, die die Aussagen verifizieren sollen, etwa "Wo wurde Donald Trump geboren?".

Diese "Verifizierungsfragen" werden dann jeweils als neuer Prompt unabhängig von der ersten Eingabe ausgeführt, um die mögliche Übernahme falscher Informationen aus der ersten Ausgabe zu verhindern. Das Sprachmodell überprüft dann die erste Eingabe anhand der separat gesammelten Fakten. Alle Tests wurden mit Llama 65B durchgeführt.

Chain-of-Verification reduziert Halluzinationen in Sprachmodellen deutlich

Das Team zeigt, dass die Antworten auf einzelne Fragen deutlich weniger Fehler enthalten und CoVe somit die Endausgabe auf einen Prompt deutlich verbessert. Bei listenbasierten Fragen, wie dem Politiker-Beispiel, kann CoVe die Genauigkeit mehr als verdoppeln und damit die Fehlerquote deutlich reduzieren.

In komplexeren Frage-Antwort-Szenarien bringt die Methode immer noch eine Verbesserung von 23 Prozent und auch in Langform-Inhalten steigert CoVe die Faktengenauigkeit um 28 Prozent. Allerdings lässt das Team bei solchen längeren Inhalten das Sprachmodell zusätzlich die Verifikationsantworten auf Inkonsistenzen gegenchecken.

In seinen Tests kann das Meta-Team auch zeigen, dass Instruction-Tuning und Chain-of-Thought-Prompting Halluzinationen nicht reduzieren, so schlägt Llama 65B mit CoVe das neuere, Instruction-tuned Modell Llama 2. In längeren Inhalten hängt das Modell mit CoVe auch ChatGPT und PerplexityAI ab, das sogar externe Fakten für seine Generierungen sammeln kann. CoVe arbeitet vollständig mit im Modell gespeichertem Wissen.

In Zukunft könnte die Methode aber auch durch externes Wissen verbessert werden, indem das Sprachmodell beispielsweise durch Zugriff auf eine externe Datenbank die Verifikationsfragen beantworten kann.