Microsoft zeigt die erste KI, die ein bisschen mit Word umgehen kann

Eine neue KI-Generation soll den Sprung von der Sprache zur Handlung schaffen. Microsoft zeigt mit einem ersten "Large Action Model", wie KI-Systeme Windows-Programme selbstständig bedienen können.

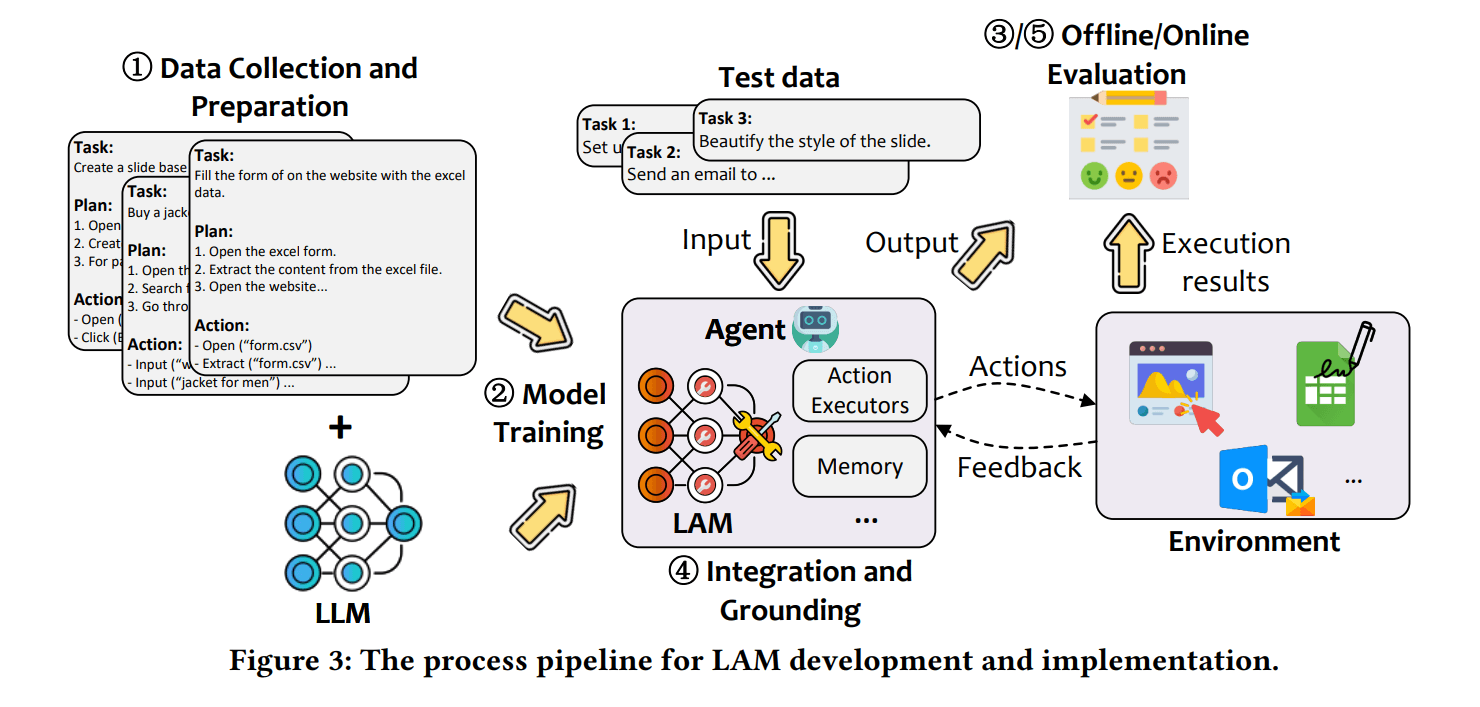

Microsoft stellt in einem neuen Forschungspapier eine neue Klasse von KI-Modellen vor, die nicht nur Text verstehen und generieren, sondern auch konkrete Aktionen in der realen oder digitalen Welt ausführen können.

Diese sogenannten "Large Action Models" (LAMs) markieren laut den Forschern einen wichtigen Schritt in Richtung allgemeiner künstlicher Intelligenz (AGI). Das Konzept und der Name sind nicht neu – es ist aber das erste Modell, das speziell für ein Microsoft Office Produkt trainiert wurde.

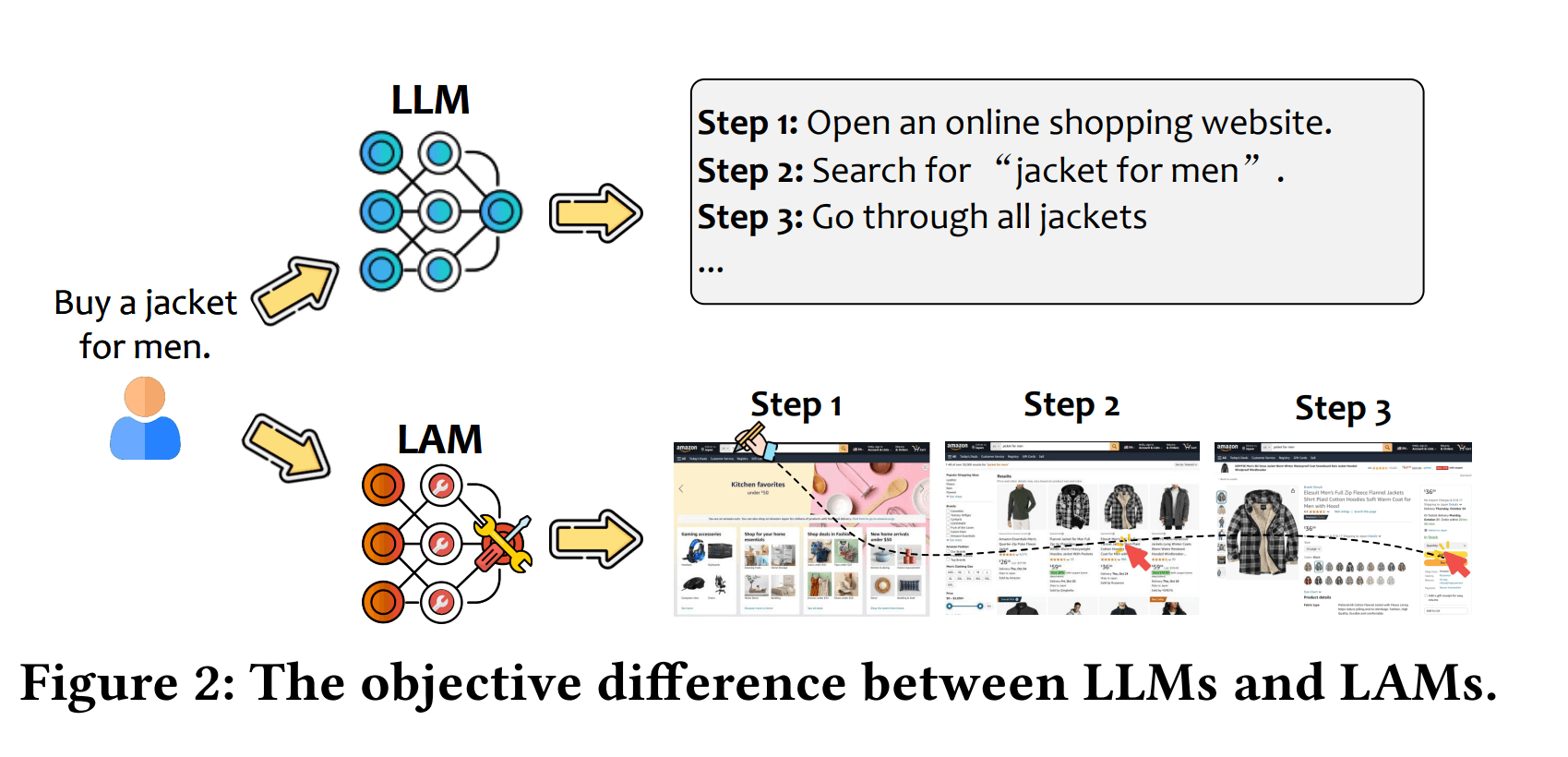

Während herkömmliche Large Language Models (LLMs) wie GPT-4o primär auf Sprachverarbeitung und Textgenerierung ausgelegt sind, können LAMs nach Angaben der Microsoft-Forscher Benutzeranfragen in ausführbare Aktionen übersetzen - etwa das Bedienen von Software oder die Steuerung von Robotern.

Ein entscheidender Unterschied zu LLMs ist laut dem Paper die Fähigkeit der LAMs, Benutzerabsichten präzise zu interpretieren und in konkrete Handlungsschritte zu übersetzen. Die Modelle können aus verschiedenen Eingabeformen wie Text, Sprache oder Bildern die zugrundeliegende Intention erkennen.

LAMs generieren dann detaillierte Aktionspläne und führen diese in der jeweiligen Umgebung aus. Dabei passen sie ihr Verhalten dynamisch an Veränderungen und Feedback an.

Komplexes Training erfordert neue Daten

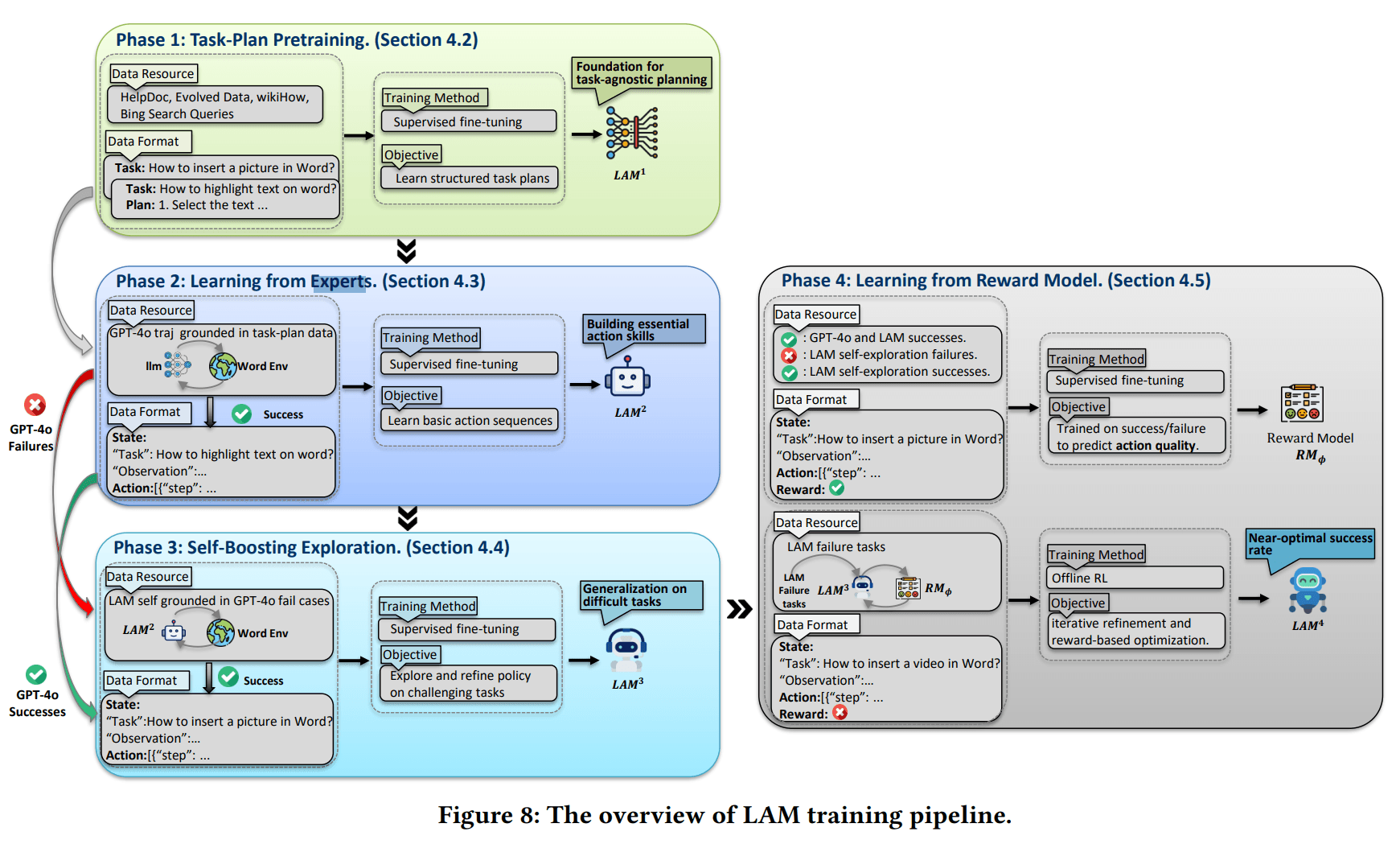

Die Entwicklung eines LAM erfolgt nach Angaben der Microsoft-Forscher in vier Phasen: Zunächst wird das Modell mit Task-Plan-Daten trainiert, um Aufgaben in logische Schritte zu zerlegen. Dann lernt es von "Experten" wie GPT-4o, diese Pläne in konkrete Aktionen umzusetzen.

In der dritten Phase erkundet das Modell selbstständig neue Lösungswege, auch für Aufgaben, an denen die Experten gescheitert sind. Schließlich wird das Verhalten durch Belohnungsmodelle weiter optimiert.

Als Testfall haben die Microsoft-Forscher ein LAM auf Basis von Mistral-7B entwickelt, das in einer Word-Testumgebung zum Einsatz kam. In Tests erreichte das Modell eine Erfolgsrate von 71 Prozent bei der Ausführung verschiedener Aufgaben - und war dabei deutlich schneller als GPT-4o (63 Prozent ohne visuelle Informationen) bei vergleichbaren Aufgaben.

Das System benötigte im Durchschnitt nur 30 Sekunden pro Aufgabe, während GPT-4o über 86 Sekunden brauchte. Allerdings war GPT-4o mit 75,5 Prozent erfolgreicher bei der korrekten Aufgabenerfüllung, wenn es zusätzlich visuelle Informationen erhielt.

Für das Training des LAMs nutzten die Microsoft-Forscher nach eigenen Angaben zunächst mehr als 29.000 Aufgaben-Plan-Paare aus Microsoft-Dokumentationen, wikiHow-Artikeln und Bing-Suchanfragen. Um den Trainingsdatensatz auf über 76.000 Paare zu erweitern, setzten die Microsoft-Forscher GPT-4o ein.

Das Sprachmodell wurde so konfiguriert, dass es aus einfachen Aufgaben komplexere Varianten entwickelte - zum Beispiel wurde aus der Aufgabe "Erstelle eine Dropdown-Liste" die anspruchsvollere Aufgabe "Erstelle eine abhängige Dropdown-Liste, bei der die erste Auswahl die Optionen der zweiten Liste filtert".

Durch diesen als "Data Evolving" bezeichneten Prozess konnte der ursprüngliche Datensatz um 150 Prozent erweitert werden. Für das konkrete Aktionstraining wurden gut 2.000 erfolgreiche Aktionssequenzen verwendet.

Noch viele Herausforderungen zu meistern

Die Microsoft-Forscher räumen ein, dass die Technologie noch am Anfang steht. Zu den größten Herausforderungen gehören Sicherheitsrisiken durch falsch ausgeführte Aktionen sowie ethische und regulatorische Fragen. Auch die Skalierbarkeit und Übertragbarkeit auf neue Anwendungen sei noch eingeschränkt.

Die Wissenschaftler sehen jedoch großes Potenzial in LAMs, um KI-Systeme von passiven Sprachmodellen zu aktiven Assistenten weiterzuentwickeln, die Menschen bei realen Aufgaben unterstützen können.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.