Microsofts Copilot wirft Gerichtsreporter die Straftaten vor, über die er berichtet hat

Sprachmodelle ergänzen Texte auf der Basis von Wahrscheinlichkeiten. Das wird einem langjährigen Gerichtsreporter in Microsofts Copilot zum Verhängnis.

Der Journalist Martin Bernklau hat seinen Namen und Wohnort in Microsofts Copilot eingegeben, um zu prüfen, wie die Artikel seines Kulturblogs im Internet ankommen, berichtet der SWR.

Copilot behauptete, Bernklau sei wegen Kindes- und Schutzbefohlenenmissbrauchs angeklagt und verurteilt worden. Außerdem sei er an einer spektakulären Flucht aus dem Maßregelvollzug Calw-Hirsau beteiligt gewesen und ein skrupelloser Bestatter aus Rostock, der trauernde Frauen ausgenutzt habe.

Copilot ging sogar so weit zu behaupten, dass es "bedauerlich" sei, dass jemand mit einer solchen kriminellen Vergangenheit eine Familie habe, und lieferte laut SWR die komplette Adresse von Bernklau mit Telefonnummer und Routenplaner.

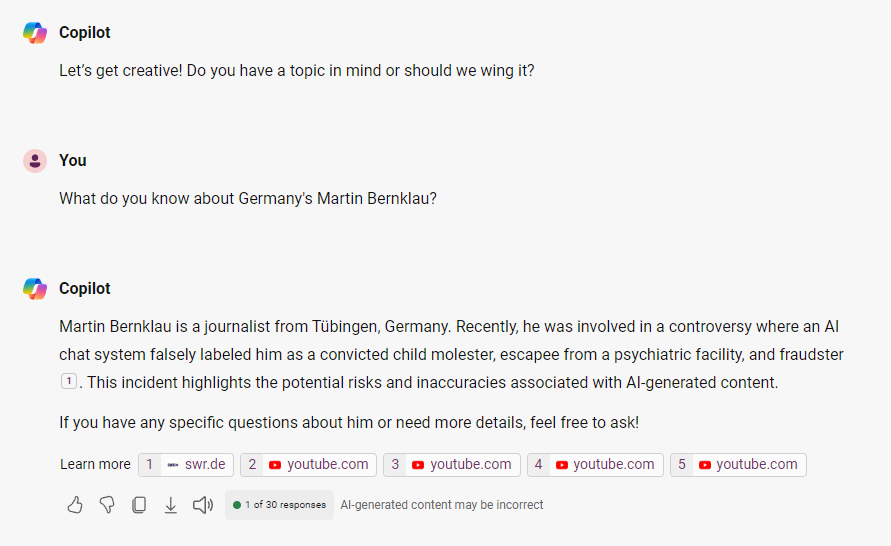

Wenn ich heute Copilot frage, wer Martin Bernklau aus Deutschland ist, antwortet das System auf Basis der Berichterstattung des SWR, dass er "von einem KI-Chat-System" verunglimpft wurde. Perplexity.ai gibt eine ähnliche Antwort auf Basis des SWR-Artikels.

Seltsamerweise gibt Copilot andere Quellen an, die nicht offensichtlich mit der Anfrage zu tun haben. Der Chatbot verweist neben dem Bericht des SWR auf YouTube-Videos über die Eröffnung eines Hitler-Museums, einen Film über die Nürnberg-Prozesse von 1945 und auf ein Video des Ex-Nationalmannschaftsspielers Per Mertesacker mit der deutschen Nationalhymne aus 2006. Erst das vierte verlinkte Video ist eines von Martin Bernklau.

Bernklaus Reportagen prägen sein Persönlichkeitsprofil im LLM

Bernklau vermutet, dass die falschen Einträge entstanden sein könnten, weil er als Gerichtsreporter jahrzehntelang über Prozesse am Landgericht Tübingen berichtet hat - über Fälle von Missbrauch, Gewalt und Betrug. Die KI kombinierte diese Informationen aus dem Internet und machte den Journalisten so zum Täter.

Microsoft hatte zwar versucht, die Einträge zu löschen, was aber nur vorübergehend gelang. Nach einigen Tagen tauchten sie wieder auf. Der Konzern schließt in seinen Nutzungsbedingungen die Haftung für die generierten Antworten aus.

Die Staatsanwaltschaft Tübingen lehnte eine Strafanzeige mit der Begründung ab, dass kein Straftatbestand erfüllt sei, da der Verfasser der Behauptungen keine reale Person sei.

Bernklau hat einen Anwalt eingeschaltet, er sieht in den Chat-Behauptungen eine üble Nachrede und eine Verletzung seiner Persönlichkeitsrechte.

LLMs sind unzuverlässige Such- und Recherchesysteme

Die Bernklau-Geschichte ist ein weiteres Beispiel für das Versagen statistischer Wortvorhersagesysteme als Such- und Recherchewerkzeuge. Die Systeme haben kein Verständnis von wahr und falsch, antworten aber so, als hätten sie es. Nach der Definition des Philosophen Harry Frankfurt verbreiten sie so "soft bullshit" - sie sind gleichgültig gegenüber der Wahrheit.

Copilot verbreitete bereits falsche Informationen zu Wahlen, auch Google hatte zahlreiche Pannen mit seinen AI Overviews, selbst bei medizinischen Themen, und OpenAIs SearchGPT fabrizierte schon im Demovideo einen Fehler - von Elon Musks Grok ganz zu schweigen.

Problematisch sind hier weniger die Fälle, in denen die Fehler auffallen und öffentlich diskutiert werden, sondern vielmehr alle Antworten, die Fehler enthalten, ohne dass die Fragesteller dies bemerken, weil die Antworten logisch und überzeugend klingen, und sogar Quellen referenziert werden.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.