Google verbindet Sprachmodelle mit einem Physik-Simulator und zeigt, dass das hybride KI-System neue Bestwerte in Benchmarks zum physikalischen Schlussfolgern knackt.

Große Sprachmodelle wie OpenAIs GPT-3 oder Googles PaLM können nicht zuverlässig logisch schlussfolgern. Das ist ein zentraler Fakt in der Debatte um die Rolle von Deep Learning auf dem Weg zu höherer Künstlicher Intelligenz.

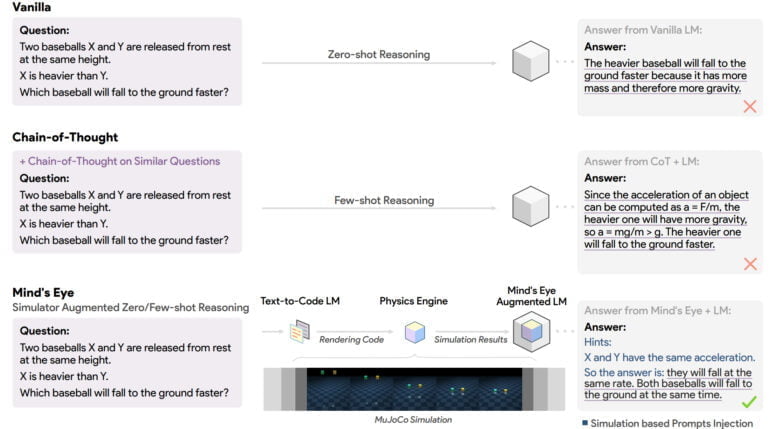

Methoden wie Chain-of-Thought-Prompting oder mehr Trainingsdaten und größere Modelle wie PaLM führten zwar zu besseren Ergebnissen in Benchmarks, aber nicht zu einem grundlegenden Durchbruch.

Forschende experimentieren daher mit hybriden Ansätzen, in denen die Sprachfähigkeiten der KI-Modelle genutzt werden, um Anfragen an spezialisierte, externe Bibliotheken oder Systeme zu stellen.

OpenAIs WebGPT war etwa ein frühes Beispiel. Jüngst verknüpfte KI-Forscher Sergey Karayev GPT-3 mit einem Python-Interpreter, der exakte mathematische Berechnungen ermöglicht oder API-Anfragen stellen kann.

Google verknüpft PaLM mit MuJoCo-Simulator

Forschenden von Google gehen jetzt einen Schritt weiter und verbinden große Sprachmodelle mit einem Physik-Simulator. Da aktuelle Sprachmodelle ausschließlich mit geschriebenem Text trainiert würden, fehle ihnen die fundierte Erfahrung des Menschen in der realen Welt, schreibt das Team.

Das dadurch entstehende Unvermögen, die Sprache mit der physikalischen Welt in Beziehung zu setzen, führe dazu, dass Wissen falsch repräsentiert werde, was wiederum zu offensichtlichen Fehlern in Schlussfolgerungen führe.

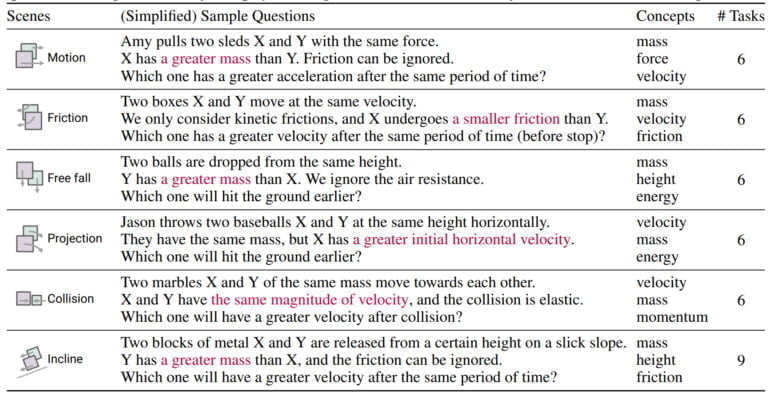

Um Sprachmodelle in der physikalischen Welt zu verankern, schlagen die Forschenden vor, Anfragen an das Sprachmodell in der Physiksimulation MuJoCo zu simulieren und mögliche Ergebnisse anschließend als Teil des Inputs für das Sprachmodell zu verwenden. Das Team nennt dieses Paradigma "Mind's Eye" und testet es am dafür erstellten UTOPIA-Benchmark für physikalisches Schlussfolgern.

Googles Mind's Eye verwandelt Text zu Code zu Simulation

Mind's Eye besteht aus drei Modulen: Das Sprachmodell übergibt Fragen, deren Beantwortung physikalische Schlussfolgerungen benötigen, an ein Text-zu-Code-Sprachmodell weiter, das mit 200.000 Text-Code-Paaren im Stil des UTOPIA-Benchmarks trainiert wurde.

Der generierte Code wird an MuJoCo weitergegeben, wo er ausgeführt und das Ergebnis anschließend in Text umgewandelt wird. Abschließend wird der Text in das Eingabefenster des Sprachmodells übertragen und dient als Input für die finale Antwort des Modells.

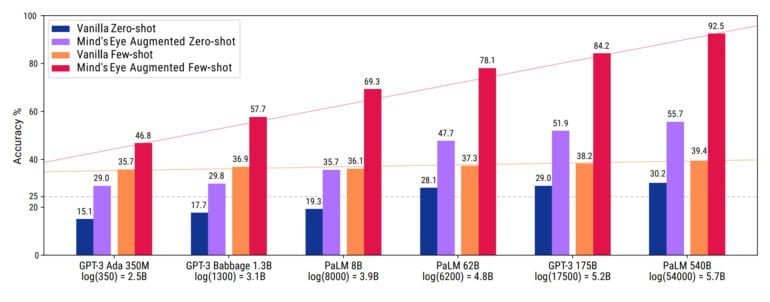

Mit dieser Methode gelingen den Google-Forschenden massive Leistungssprünge: Googles PaLM 540B erreicht mit Mind's Eye 92,5 Prozent statt 39,4 Prozent in UTOPIA, OpenAIs InstructGPT 99,1 Prozent statt 68,6 Prozent. Im Schnitt steigt die Genauigkeit der getesteten Sprachmodelle um 27,9 bei Zero-Shot- und 46 Prozent im Few-Shot-Szenario.

Googles Mind's Eye erweitert die Möglichkeiten von Sprachmodellen

Neben der Skalierbarkeit des Ansatzes und der durch die Simulation fundierten Schlussfolgerung sei Mind's Eye zudem sehr effizient: Da die Methode domänenspezifisches Wissen an externe Expertenmodule delegiere (in diesem Fall MuJoCo), sei dieses Wissen von Schlussfolgerungsfähigkeiten entkoppelt.

Die Größe des benötigten Sprachmodells könne so erheblich verringert werden, da das Netz kein domänenspezifisches Wissen auswendig lernen müsse. In der Praxis kann das Team zeigen, dass kleinere Modelle mit Mind's Eye im UTOPIA-Benchmark die Leistung von 100-mal größeren Modellen erreichen.

Wir kommen zu dem Schluss, dass Mind's Eye nicht nur effektiv und skalierbar, sondern auch effizient ist, da es die Argumentationsleistung kleiner LMs erheblich steigern kann, ohne dass weder handgefertigte Eingabeaufforderungen noch kostspielige Feinabstimmung.

Mind's Eye Paper

Das Team glaubt, dass die Idee, für Schlussfolgerungen auf eine Simulations-Pipeline zu setzen, sich leicht auf andere Domänen ausbreiten lässt - besonders dort, wo bereits Simulationen existieren. Anstelle der physikalischen Welt könnten etwa Simulationen wirtschaftlicher Veränderungen oder der Thermodynamik verwendet werden.

"Die dynamische Natur von Mind's Eye, bei der wir fundierte Erkenntnisse generieren, erschließt das Skalierungspotenzial dieser Modelle", heißt es in der Veröffentlichung.

Mit anderen Worten: Das Potenzial großer KI-Modelle ist noch nicht ausgeschöpft und Techniken wie Mind's Eye können neue Fähigkeiten erschließen, ohne dass dafür fundamental neue KI-Technologien benötigt werden.