Nvidia-Alternative Cerebras plant sechs neue Rechenzentren für schnelle KI-Inferenz

Der KI-Chiphersteller Cerebras Systems will mit neuen Rechenzentren seine Inferenz-Kapazitäten ausbauen.

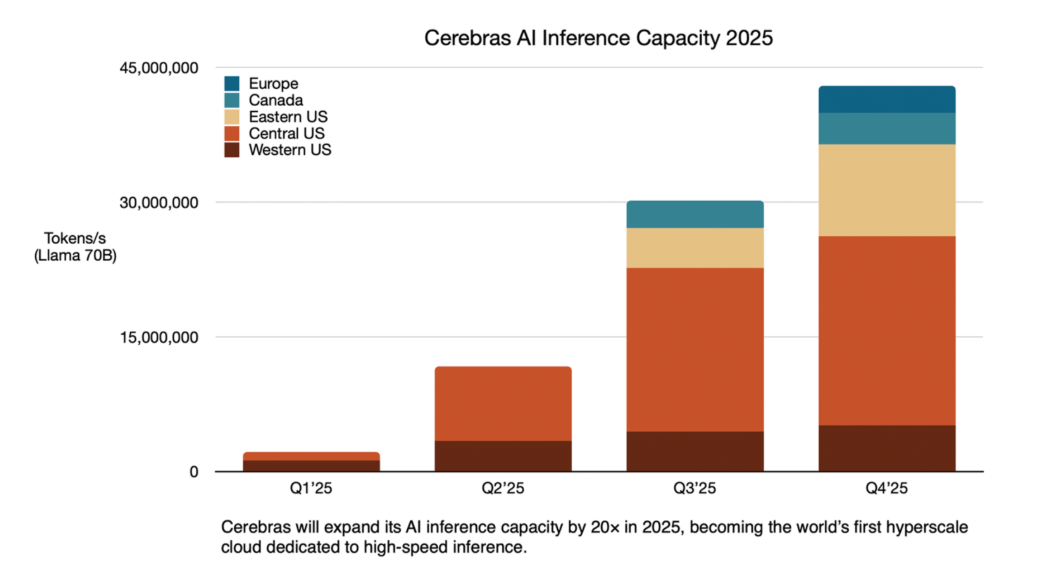

Die Standorte verteilen sich auf Nordamerika und Europa, wobei 85 Prozent der Kapazität in den USA liegen soll. Drei Rechenzentren in Santa Clara, Stockton und Dallas sind bereits aktiv. Minneapolis soll im zweiten Quartal 2025 folgen, Oklahoma City und Montreal im dritten Quartal sowie Atlanta und ein Standort in Frankreich im vierten Quartal.

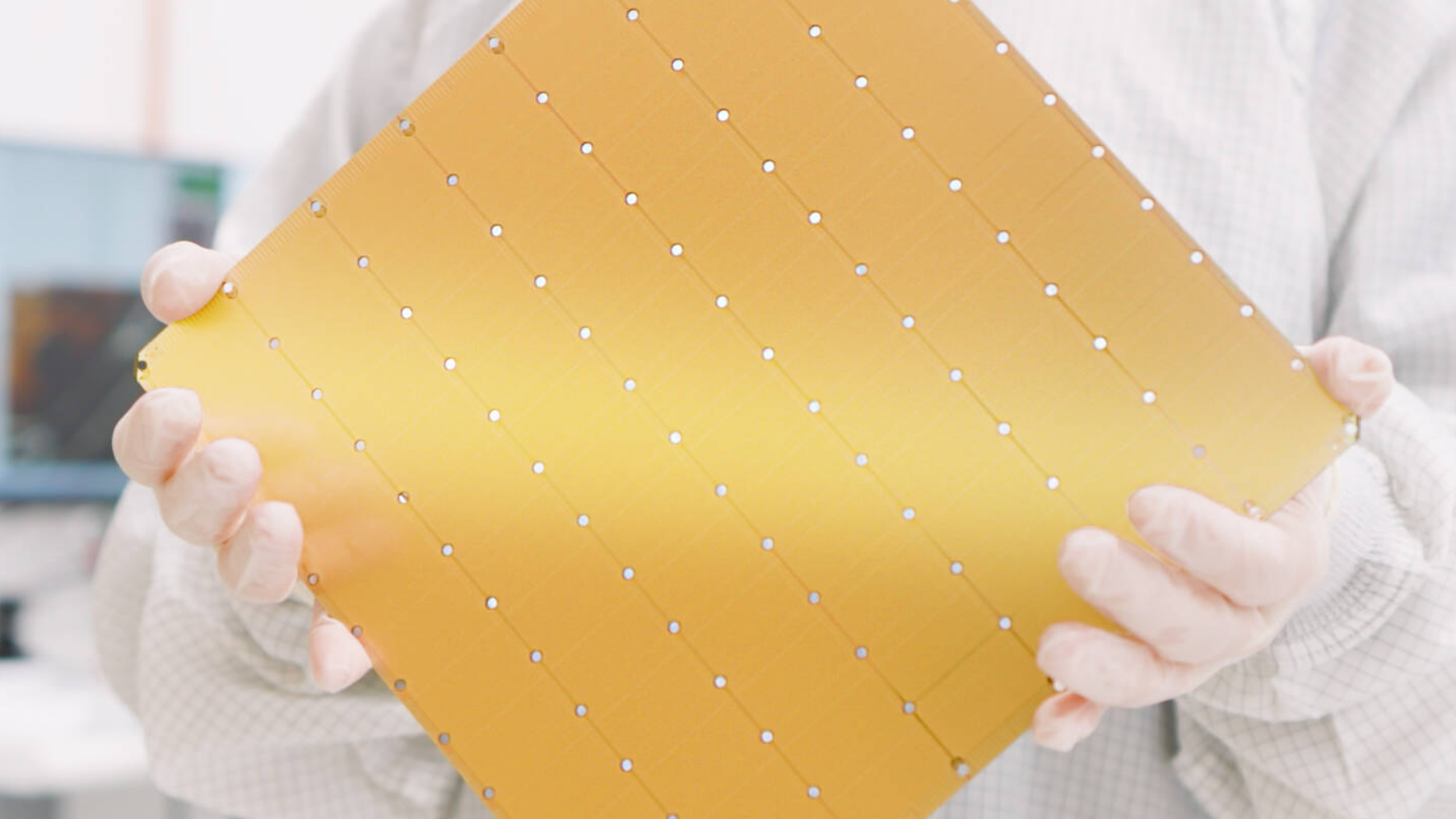

Die technologische Basis der Rechenzentren bilden die sogenannten Wafer-Scale Engines, eine von Cerebras entwickelte Chip-Architektur, die speziell für KI-Anwendungen optimiert wurde. Laut Unternehmensangaben sollen die Anlagen mit CS-3-Systemen ausgestattet werden und eine Inferenzgeschwindigkeit von 40 Millionen Llama-70B-Tokens pro Sekunde erreichen.

Das geplante Rechenzentrum in Oklahoma City soll etwa über 300 CS-3-Systeme beherbergen. Die Anlage wird nach Level-3+-Standards gebaut, mit Schutz gegen Tornados und Erdbeben sowie dreifach redundanter Stromversorgung. Sie wird im Juni 2025 in Betrieb genommen.

Erste Kunden nutzen die Cerebras-Infrastruktur

Zu den ersten Nutzern der Cerebras-Infrastruktur gehören das französische KI-Startup Mistral mit seinem Assistenten Le Chat und die KI-Antwortmaschine Perplexity. Auch HuggingFace und AlphaSense haben sich für die Nutzung der Systeme entschieden.

Die Technologie zielt besonders auf Reasoning-Modelle wie Deepseek-R1 und OpenAI o3 ab, die für ihre Berechnungen üblicherweise mehrere Minuten benötigen und viele Token für ihre Denkprozesse generieren.

Die Expansion ist Teil eines Skalierungsplans für 2025. Einige der Standorte werden in Kooperation mit dem emiratischen Partner G42 betrieben. In Montreal betreibt Enovum, eine Tochter von Bit Digital, das dortige Rechenzentrum. Die Anlage soll eine zehnmal höhere Inferenzgeschwindigkeit als aktuelle GPUs erreichen und soll im Juli 2025 vollständig betriebsbereit sein.

Cerebras Systems ist ein US-amerikanisches Unternehmen, das sich auf die Entwicklung spezieller KI-Chips konzentriert. Das Besondere: Cerebras nutzt einen kompletten Wafer als einen einzigen Chip, die sogenannte "Wafer Scale Engine". Der WSE-3 ist die dritte Generation des Wafer-Scale-KI-Chips von Cerebras Systems.

Die Technologie kommt bereits in verschiedenen Einrichtungen zum Einsatz, darunter das Argonne National Laboratory, das Pittsburgh Supercomputing Center und GlaxoSmithKline. Allerdings gibt es auch Einschränkungen: Das System läuft nicht mit nativem CUDA (Nvidia-Standard) und ist weniger flexibel als Nvidia-Lösungen bezüglich der Server-Kompatibilität.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.