Nvidia DatasetGAN: Unendlich viele Bilder für KI-Training

Daten sind die Grundlage der KI-Revolution: Ein neues KI-Werkzeug von Nvidia soll hochwertige Datensätze fürs KI-Training künstlich generieren. Das könnte den KI-Fortschritt beispielsweise beim autonomen Fahren weiter beschleunigen.

Bildanalyse-KIs werden meist mit per Hand beschrifteten Bildern trainiert. Der bekannteste Datensatz für das KI-Training ist ImageNet mit knapp 14 Millionen Bildern, die von zahlreichen Menschen über Amazons Micro-Jobber-Plattform „Mechanical Turk“ manuell verschiedenen Kategorien zugeordnet wurden. Die Beschriftung von Bildern und anderen Daten für das KI-Training ist ein Industriezweig geworden, in dem einige Unternehmen ihre Daten von günstigen Arbeitskräften im Ausland aufbereiten lassen.

Doch dieser Ansatz ist mitunter zeitaufwendig: Während eine simple Zuweisung eines Objektes wie im ImageNet-Datensatz nur wenige Sekunden dauert, kann das Beschriften einer komplexen Szene, in der alle relevanten Objekte auf den Pixel genau markiert werden müssen, zwischen 30 und 90 Minuten pro Bild dauern, rechnet Nvidia vor. Solche genauen Label werden etwa für das Training von autonomen Fahrzeugen verwendet.

Während zahlreiche KI-Forscher daher an Methoden arbeiten, die KI-Bildanalyse mit unüberwachtem Training (Erklärung) voranzutreiben, also mit unbeschriftetem Datenmaterial, haben Nvidia-Forscher einen alternativen Ansatz getestet: KI-generierte und -beschriftete Bilder für das überwachte Training.

KI produziert ihre Trainingsdaten selbst

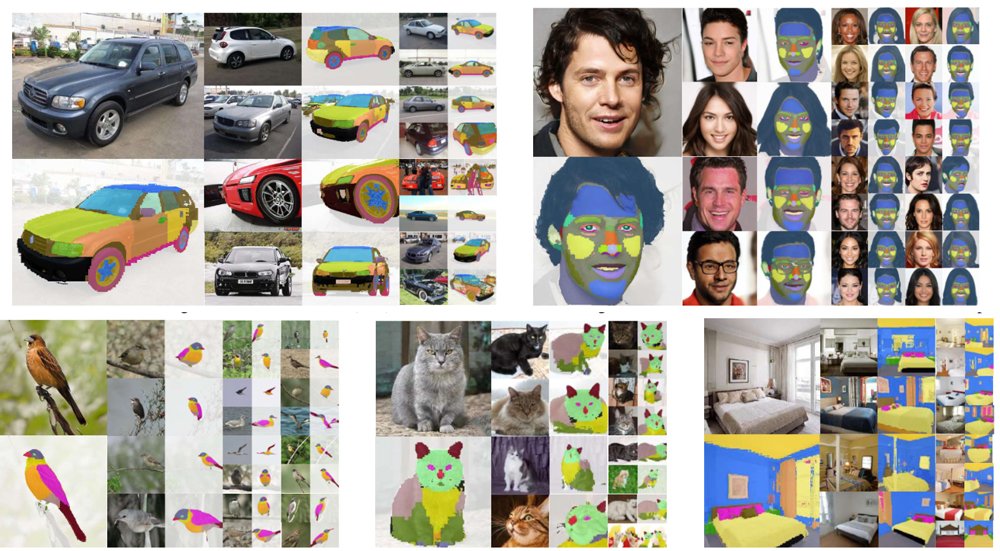

Nvidias DatasetGAN verspricht potenziell unendliche Trainingsdaten mit minimalen menschlichem Aufwand. Der Datengenerator setzt dafür auf StyleGAN, eine Bildgenerierungs-KI, die etwa auf der Webseite This Person does not exist auf Knopfdruck realistisch aussehende Porträtfotos von Menschen generiert.

Laut Nvidia müssen Systeme wie StyleGAN intern bereits semantische Strukturen aller gesehenen Objekte repräsentieren – andernfalls könnten sie diese nicht so täuschend echt generieren.

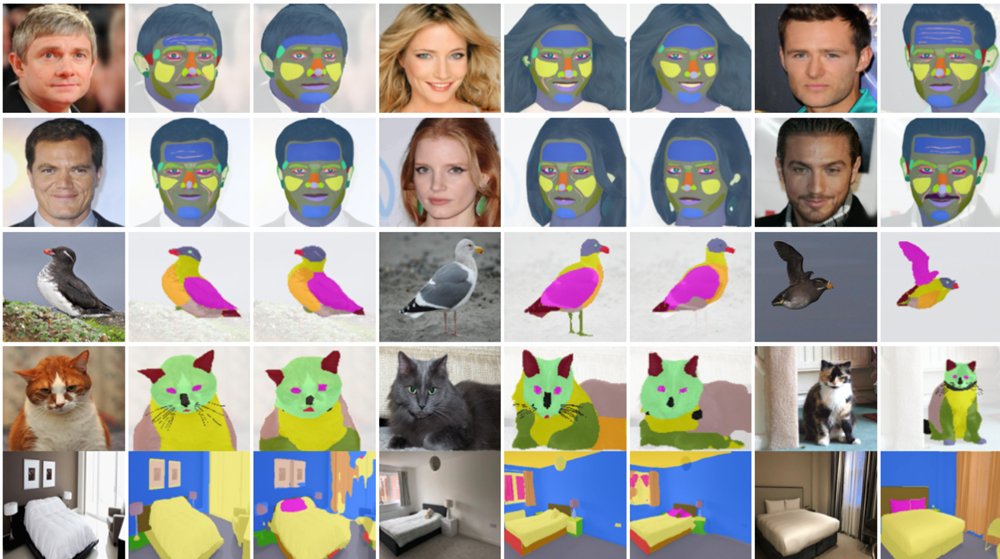

Die Forscher trainierten daher ein separates Netzwerk (Diskriminator), diese semantischen Strukturen aus den Ausgaben von StyleGAN auszulesen, in den Bildern zu markieren und zu beschriften. Dafür nutzte Nvidia jeweils einen per Hand gelabelten Datensatz, der für das Netzwerk als Vorlage diente.

Nach dem Training konnte das hinter StyleGAN geschaltete Netzwerk so automatisch die bereits vorhandenen semantischen Strukturen mit den gewünschten Labeln versehen und über die generierten Bilder legen.

DatasetGAN: Die neue Datensparsamkeit

Hervorzuheben ist Nvidias Vorgehen deshalb, da die für das Training des Diskriminators benötigten Datensätze winzig sind: Die Forscher nutzten lediglich zwischen 16 und 36 Beispielbilder der Klassen Schlafzimmer, Autos, Katzen, Vögel und Gesichter mit umfassenden, von menschlichen Experten erstellten Beschriftungen. So enthielt der Gesichtsdatensatz lediglich 16 Bilder mit 34 Kategorien wie Augen, Iris, Pupille, Wangen, Zähne, Nase, Nasenspitze und weitere.

Laut Nvidia schlägt ein mit DatasetGAN-generierten Daten überwacht trainiertes KI-System die Leistung von unüberwacht trainierten KIs deutlich und übertrifft in einigen Fällen auch überwacht trainierte KI-Systeme (Erklärung Supervised Learning), die mit bis zu 100-mal mehr Daten trainiert wurden.

Nvidia plant weitere Klassen für die Datenmaschine

Mit Nvidias DatasetGAN können Forscher also mit einer Handvoll hochdetailliert gelabelter Beispielfotos tausende neue Bilder generieren, die ebenfalls diese detaillierten Label tragen und mit diesen ihre Bildanalyse-KIs überwacht trainieren. Ob diese synthetischen Trainingsdaten in allen Anwendungsbereichen als Ersatz für echte und von Menschen gelabelten Bildern taugen, wird sich in weiteren Tests zeigen müssen.

Nvidias Forscher werden ihre Arbeit auf der diesjährigen KI-Konferenz CVPR 2021 vorstellen. Der Code soll ebenfalls veröffentlicht werden. In Zukunft wollen die Forscher DatasetGAN mit zahlreichen weiteren Klassen erweitern.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.