Nvidia-Forschende plädieren für mehr kleine Modelle in KI-Agenten

Nvidia-Wissenschaftler:innen sehen im Fokus auf große Sprachmodelle ökonomische und ökologische Nachteile, gerade im Hinblick auf agentische Anwendungen. Die Industrie soll ihre Strategie überdenken.

Ein aktuelles Forschungspapier von Nvidia-Forschenden kritisiert, dass die meisten KI-Agenten unnötig auf überdimensionierte Large Language Models setzen. Stattdessen würden für die allermeisten Anwendungsfälle Small Language Models (SLMs) ausreichen, argumentieren die Wissenschaftler:innen. Als Richtgröße für das Jahr 2025 nennen sie Modelle mit weniger als 10 Milliarden Parametern.

Massive Investitionen in falsche Richtung

Während der Markt für LLM-APIs, die Agentensystemen zugrunde liegen, 2024 auf 5,6 Milliarden US-Dollar geschätzt wurde, stiegen die Investitionen in die entsprechende Cloud-Infrastruktur auf 57 Milliarden US-Dollar. Das entspreche einer zehnfachen Diskrepanz.

"Diese operative Modell ist so tief verwurzelt in der Industrie, dass es die Grundlage für erhebliche Kapitalwetten bildet", schreiben die Nvidia-Wissenschaftler:innen. Sie bezweifeln jedoch, dass diese Investitionen in drei bis vier Jahren die erwarteten Renditen liefern werden.

Das Team argumentiert, dass SLMs für die meisten Aufgaben in Agentensystemen "prinzipiell ausreichend mächtig", "operativ geeigneter" und "notwendigerweise wirtschaftlicher" seien als ihre großen Pendants.

Kleine Modelle holen technisch auf

Die Forschenden belegen ihre Position mit diversen Beispielen teils älterer SLMs, die trotz ihrer geringen Größe beeindruckende Leistungen erzielen. Microsofts Phi-2 mit 2,7 Milliarden Parametern erreiche bei Alltagsverstand und Codegenerierung die Leistung von 30-Milliarden-Parameter-Modellen, laufe dabei aber 15-mal schneller.

Nvidias eigene Nemotron-H-Familie mit 2, 4,8 und 9 Milliarden Parametern erreiche bei Instruktionsbefolgung und Codegenerierung die Genauigkeit von 30-Milliarden-Parameter-LLMs bei einem Bruchteil der benötigten Rechenoperationen.

Deepseek-R1-Distill-Qwen-7B übertreffe sogar große proprietäre Modelle wie Claude-3.5-Sonnet und GPT-4o bei Reasoning-Aufgaben. Das RETRO-Modell von Deepmind erreiche mit 7,5 Milliarden Parametern die Leistung von GPT-3 mit 175 Milliarden Parametern bei 25-mal weniger Parametern.

Wirtschaftliche Vorteile überwiegen

Die ökonomischen Argumente für SLMs seien laut den Forschenden überwältigend. Die Bereitstellung eines 7-Milliarden-Parameter-SLM sei 10- bis 30-mal günstiger als die eines 70- bis 175-Milliarden-Parameter-LLM, sowohl bei Latenz als auch bei Energieverbrauch und benötigten Rechenoperationen.

Fine-Tuning von SLMs benötige nur wenige GPU-Stunden statt Wochen, was eine schnelle Anpassung an neue Anforderungen ermögliche. Zudem könnten SLMs lokal auf Consumer-Hardware ausgeführt werden, was niedrigere Latenz und bessere Datenkontrolle biete.

Die Forschenden argumentieren, dass SLMs einen höheren Anteil ihrer Parameter effektiv zu nutzen scheinen. LLMs würden oft nur einen Bruchteil ihrer Parameter für einzelne Eingaben aktivieren, was sie fundamental ineffizient mache.

Agenten brauchen keine Alleskönner

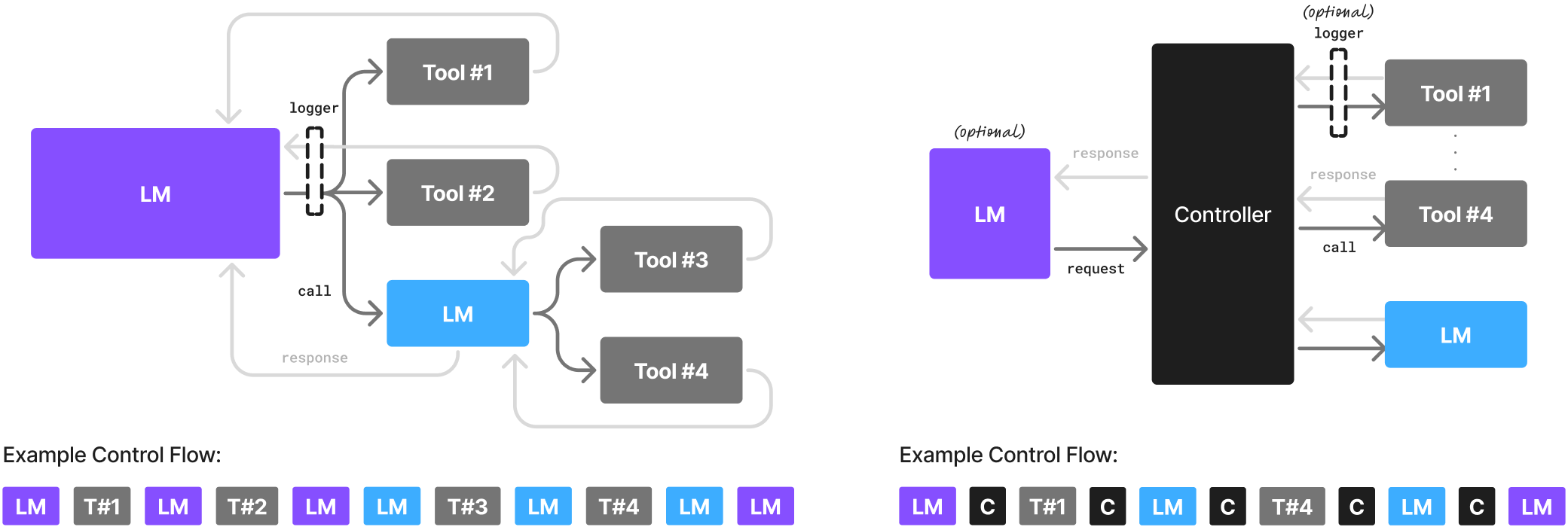

Ein Kernargument der Nvidia-Forschenden ist, dass KI-Agenten nur einen sehr schmalen Bereich der LLM-Fähigkeiten nutzen. "Ein KI-Agent ist im Wesentlichen ein stark instruierter und extern choreografierter Zugang zu einem Sprachmodell", schreiben sie.

Die meisten Aufgaben in Agentensystemen seien repetitiv, eingegrenzt und nicht auf Gespräche ausgelegt. Dafür reichten spezialisierte SLMs aus, die für spezifische Formate und Aufgaben fine-getuned wurden.

Die Forschenden schlagen heterogene Agentensysteme vor, die verschiedene Modellgrößen je nach Komplexität der Aufgabe einsetzen. SLMs würden standardmäßig verwendet, LLMs nur bei Bedarf für komplexe Reasoning-Aufgaben.

Barrieren und Migrationsstrategie

Als Haupthindernisse für die SLM-Adoption identifizieren die Forschenden die massiven Vorabinvestitionen in zentralisierte LLM-Infrastruktur, den Fokus auf generalistische Benchmarks bei der SLM-Entwicklung und mangelnde öffentliche Aufmerksamkeit für SLMs.

Das Team stellt einen sechsstufigen Fahrplan für die Migration von LLM- zu SLM-basierten Agenten vor, bestehend aus Datensammlung, Datenkuratierung und -filterung, Aufgaben-Clustering, SLM-Auswahl, spezialisiertes Fine-Tuning und kontinuierliche Verbesserung.

In Fallstudien schätzen die Forschenden, dass 40 bis 70 Prozent der LLM-Anfragen in populären Open-Source-Agenten wie MetaGPT, Open Operator und Cradle durch SLMs ersetzt werden könnten.

Die Nvidia-Forschenden rufen die Community zur Diskussion auf und wollen ausgewählte Reaktionen auf ihre Position online veröffentlichen. Sie sehen in der Verlagerung zu SLMs neben einer technischen Verbesserung auch eine moralische Verpflichtung angesichts steigender Infrastrukturkosten und Umweltbelastung. Das französische Unternehmen Mistral hat kürzlich eine umfassende Bilanz seines größten Sprachmodells veröffentlicht, die den Energieverbrauch erstmals mit Zahlen konkretisiert.

OpenAI hat außerdem jüngst den ChatGPT Agent eingeführt, der von einem größeren Modell angetrieben wird, um mit möglichst vielen Arten von Webseiten flexibel interagieren zu können. Auch die großen Modelle von Googles Gemini-Reihe dürften die Grundlage für kommende Agentensysteme sein.

Auf den ersten Blick mag es widersprüchlich erscheinen, dass ausgerechnet Forscher von Nvidia, dem Hauptprofiteur des LLM-Booms, für kleinere und günstigere Modelle plädieren. Doch die Positionierung könnte strategisch sinnvoll sein: Indem KI durch SLMs zugänglicher und wirtschaftlicher wird, könnte Nvidia den Gesamtmarkt für KI-Anwendungen massiv erweitern und die Technologie tief in Unternehmen und auf Endgeräten verankern.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.