Nvidia zeigt Text-zu-Video für Stable Diffusion

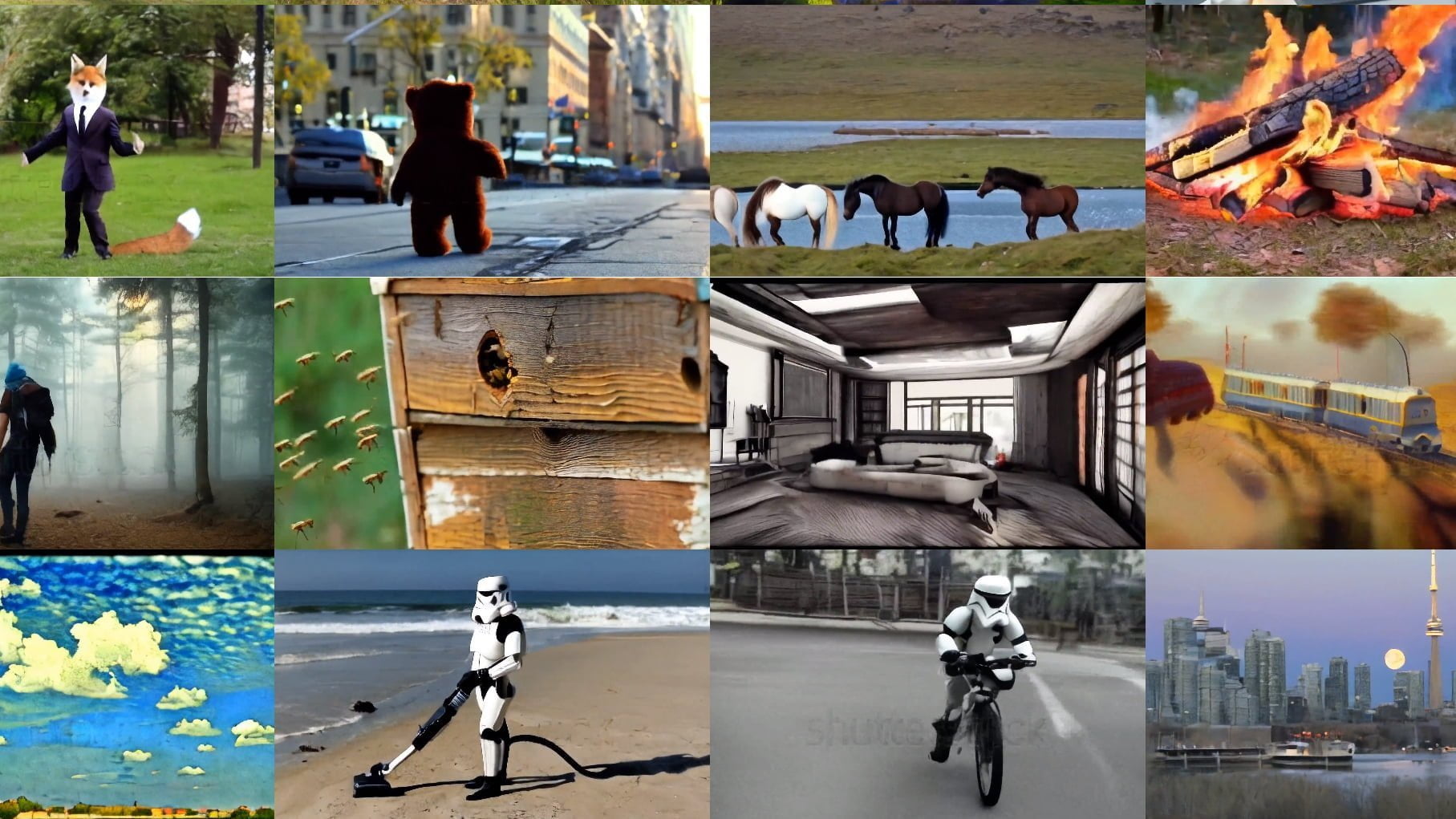

Nvidia macht Stable Diffusion zu einem Text-zu-Video-Modell, generiert hochauflösende Videos und zeigt, wie das Modell personalisiert werden kann.

Das generative KI-Modell von Nvidia basiert auf Diffusionsmodellen und erweitert diese um eine zeitliche Dimension, die eine zeitlich stabile Bildsynthese über mehrere Bilder hinweg ermöglicht. Das Team trainiert ein Video-Modell, um mehrere Minuten lange Videos von Autofahrten in einer Auflösung von 512 x 1.024 Pixeln zu erzeugen - und stellt damit neue Bestmarken auf.

Neben dieser Demonstration, die vor allem für die Forschung im Bereich des autonomen Fahrens relevant ist, zeigen die Forschenden, wie ein bestehendes Stable Diffusion-Modell in ein Video-Modell umgewandelt werden kann.

Video: Nvidia

Nvidia-Team macht Stable Diffusion zum Text-zu-Video-Modell

Dazu trainiert das Team in einem Finetuning-Schritt Stable Diffusion für kurze Zeit mit Videodaten und fügt dann hinter jeder bestehenden Schicht im Netz zusätzliche Schichten für die zeitliche Ausrichtung der Synthese ein und trainiert diese ebenfalls mit den Videodaten. Zusätzlich trainiert das Team zeitstabile Upscaler und erhält so Videos mit einer Auflösung von 1.280 x 2.048 Pixeln, die aus Textprompts generiert werden.

Video: Nvidia

Video: Nvidia

Mit Stable Diffusion als Grundlage für das Video-Modell muss das Team kein neues Modell von Grund auf trainieren und kann von bestehenden Fähigkeiten und Methoden profitieren. So enthält der verwendete WebVid-10M-Datensatz zwar nur Echtweltvideos, das Modell kann aber dank des zugrunde liegenden Stable Diffusion-Modells auch Kunstvideos generieren. Alle Videos sind zwischen 3,8 und 4,7 Sekunden lang - je nach Framerate.

Video-Stable-Diffusion kann mit Dreambooth individualisiert werden

Darüber hinaus kann das Team neben dem bereits erwähnten Upscaler eine weitere, von Stable Diffusion bekannte Methode nutzen: Die Individualisierung über Google Dreambooth. Mit dieser Methode kann ein bestehendes Stable Diffusion Modell mit wenigen Bildern ein neues Konzept lernen - zum Beispiel Gesichter, ein bestimmtes Gebäude oder ein Haustier - und dieses dann in neuen Synthesen ausgeben.

Das Team von Nvidia zeigt, dass Dreambooth auch mit dem auf Video spezialisierten Stable Diffusion Modell funktioniert und generiert Videos mit Objekten, die nicht Teil der ursprünglichen Trainingsdaten waren. Dies eröffnet neue Möglichkeiten für Content Creators, die mit DreamBooth ihre Video-Inhalte individualisieren könnten.

Video: Nvidia

Das Team hat via Dreambooth eine Katze im Modell hinterlegt. | Video: Nvidia

Weitere Beispiele gibt es auf der Projektseite von Nvidia Video LDM. Das Modell ist nicht verfügbar, jedoch ist einer der Autoren des Papers Robin Rombach - einer der Menschen hinter Stable Diffusion und bei Stability AI. Möglicherweise sehen wir also demnächst eine Open-Source-Implementation.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.