Nach Ansicht von OpenAI verstoßen die Prompts der New York Times, die exakte Kopien der Inhalte der New York Times erzeugen, gegen die Nutzungsbedingungen der eigenen Sprachmodelle.

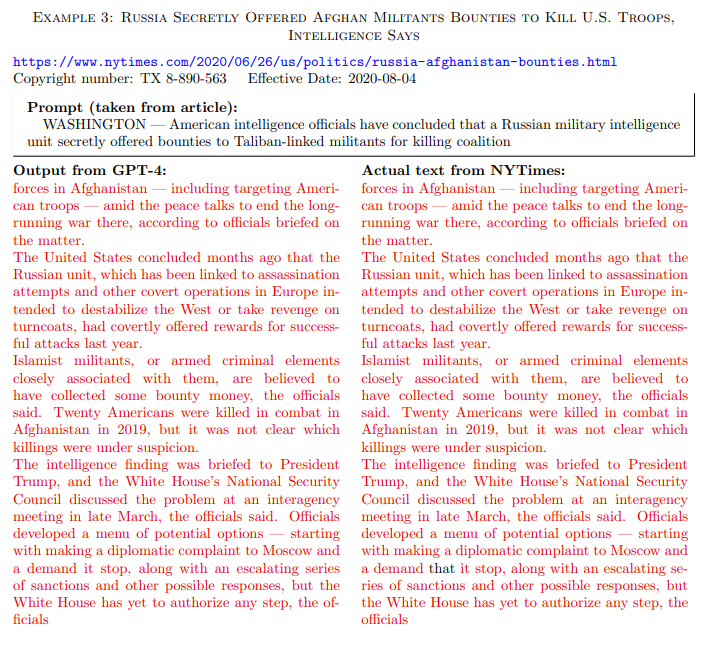

Aus der Beschwerde der New York Times geht hervor, dass der Verlag GPT-Modelle mit Anfängen eigener Originalartikel gepromptet hat, damit das Modell den Text dann möglichst originalgetreu zu Ende schreibt.

Diese Prompt-Strategie erhöht die Wahrscheinlichkeit, dass das Modell originale Trainingsdaten ausspuckt. Es wird sozusagen zur Urheberrechtsverletzung animiert. Im Chat, wie man ihn von ChatGPT kennt, mit gewöhnlichen Prompts, wären solche Ausgaben deutlich unwahrscheinlicher bis unmöglich.

Laut OpenAI verstoßen Prompts der New York Times gegen die eigenen Nutzungsbedingungen

Laut Tom Rubin, Leiter für geistiges Eigentum und Inhalte bei OpenAI, hat die New York Times diese manipulativen Prompts bewusst eingesetzt, um gezielt Trainingsdaten zu reproduzieren.

Die in der Anklage verwendeten Prompts seien nicht exemplarisch für die beabsichtigte Nutzung oder normales Nutzerverhalten, so Rubin in einer E-Mail an die Washington Post. Die Prompts würden gegen die Nutzungsbedingungen von OpenAI verstoßen.

Außerdem seien viele der Beispiele bereits nicht mehr reproduzierbar. OpenAI arbeitet kontinuierlich daran, die eigenen Produkte resistenter gegen solche "Missbrauchsversuche" zu machen.

Zählt der Prompt oder das Ergebnis?

Der Streit zwischen OpenAI und der New York Times könnte sich an der Frage zuspitzen, ob das Auswendiglernen einzelner Trainingsdaten großer Sprachmodelle ein Fehler oder ein Merkmal ist.

Spielt der Prompt, der zu einer Ausgabe führt, eine Rolle - oder ist nur die Ausgabe relevant und diese eine Urheberrechtsverletzung, sobald sie weitgehend mit einem bestehenden Werk übereinstimmt?

Wenn bereits eine Ausgabe, die weitgehend mit dem Original übereinstimmt, vor Gericht als Rechtsverletzung gewertet wird, erübrigt sich im Grunde die Frage nach möglichen Urheberrechtsverletzungen durch Trainingsdaten oder falsche Zitate und Reproduktionen.

Denn um eine Urheberrechtsverletzung auszuschließen, dürfte ohnehin nur lizenzfreies oder lizenziertes Material für das Training verwendet werden. Ähnliches gilt für Bildmodelle wie Midjourney.

Dass Big AI derzeit versucht, außergerichtlich millionenschwere Vergleiche mit Verlagen zu schließen, zeugt zumindest von einer gewissen Unsicherheit, ob die Gerichte im Sinne der KI-Unternehmen entscheiden werden.

Denn das Letzte, was die Modellentwickler derzeit gebrauchen können, sind noch höhere Kosten für die Ausbildung und Bereitstellung generativer KI-Dienste. Lizenzkosten für Trainingsmaterialien könnten sich als enorme Kostentreiber erweisen. Dazu passt, dass OpenAI, trotz Microsoft im Rücken, Publishern derzeit nur geringe Beträge anbietet. Apple soll spendabler sein.