OpenAI rudert bei Routing zurück: GPT-5-Modelle jetzt zur direkten Auswahl

OpenAI gibt Nutzer:innen von ChatGPT mehr Kontrolle über GPT-5: Drei manuelle Betriebsmodi, neue Modellschalter und die Rückkehr von GPT-4o deuten auf eine Abkehr vom bisherigen Routing-Modell hin.

OpenAI führt in ChatGPT die Möglichkeit ein, GPT-5 manuell zwischen den Modi "Auto", "Fast" und "Thinking" umzuschalten. Laut CEO Sam Altman sollten zwar die meisten Nutzer:innen den automatischen Modus bevorzugen, für manche könne die zusätzliche Kontrolle jedoch hilfreich sein.

Ein neues UI-Element zeigt zudem an, welches Modell eine Antwort generiert hat: Wer mit dem Mauszeiger über den Regenrate-Button fährt, erhält diese Information direkt im Interface.

Rückkehr zu mehr Nutzerkontrolle

Die Änderungen markieren eine Kehrtwende gegenüber dem mit GPT-5 gerade erst eingeführten Routing-Prinzip, bei dem ChatGPT automatisch entscheidet, welches Modell auf eine Anfrage antwortet.

Dieses System war mit dem Rollout von GPT-5 verstärkt in die Kritik geraten. Einige Nutzer:innen empfanden es als intransparent und unzuverlässig – insbesondere, weil bewährte Modelle wie GPT-4o ohne Vorwarnung deaktiviert wurden und der Router nicht immer die leistungsfähigste GPT-5-Variante auswählte.

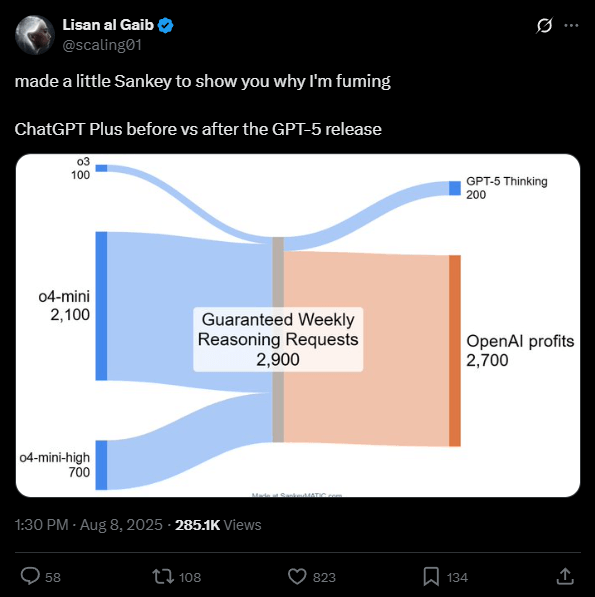

Zudem entstand der Eindruck, OpenAI wolle durch das Routing teure Anfragen auf günstigere Modelle umleiten und die Nutzung der rechenintensiven "Reasoning"-Varianten einschränken. Tatsächlich wurde bei zahlenden Nutzer:innen das Kontingent für GPT-5 Reasoning-Anfragen zunächst deutlich reduziert.

OpenAI reagierte auf diese Kritik mit einer Erhöhung der Limits. Für den Modus "GPT-5 Thinking" liegt das Wochenlimit nun bei 3.000 Nachrichten. Danach wird automatisch auf die kompaktere Variante "GPT-5 Thinking mini" umgeschaltet.

Altman betont jedoch, dass diese Limits je nach Nutzung weiter angepasst werden könnten. Auch auf der Webseite ist von einer temporären Anpassung die Rede.

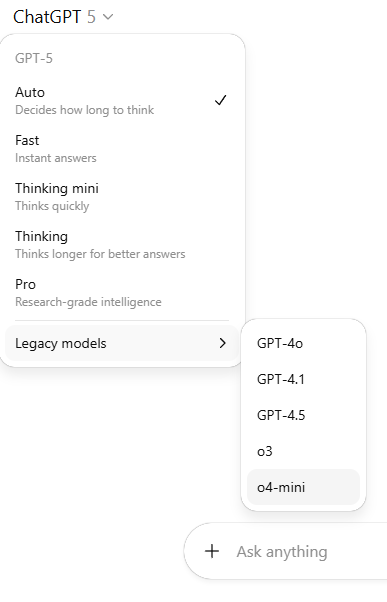

Wieder mehr Auswahl im Modellwähler

Parallel dazu stellt OpenAI GPT-4o wieder für alle zahlenden Nutzer:innen im Modellpicker zur Verfügung. Sollte das Modell in Zukunft eingestellt werden, will das Unternehmen dieses Mal frühzeitig informieren.

In den Web-Einstellungen von ChatGPT Bezahl-Accounts erscheint zudem ein neuer Schalter namens "Zeige weitere Modelle / Show additional models". Aktiviert man diesen, können weitere Modelle wie o3, 4.1 und GPT-5 Thinking mini manuell ausgewählt werden. GPT-4.5 bleibt allerdings Pro-Nutzer:innen vorbehalten – laut Altman, weil es "viel GPU-Leistung" benötigt.

Kritiker bemängeln fehlenden Fortschritt

Trotz der Nachbesserungen bleibt die grundlegende Kritik an GPT-5 bestehen. Der LLM-Scaling-Kritiker Gary Marcus bezeichnete das Modell in einem Blogbeitrag als "überfällig, überhyped und unterwältigend". Für ihn stellt GPT-5 keine bedeutende Weiterentwicklung dar, sondern lediglich eine überhastete inkrementelle Verbesserung.

Marcus verweist auf frühzeitig entdeckte Fehler in physikalischen Erklärungen, Schachaufgaben und Bildanalysen. Eine aktuelle Studie der Arizona State University stützt seine Kritik: Das sogenannte "Chain of Thought"-Schlussfolgern, eine vermeintliche Stärke großer Sprachmodelle, sei außerhalb des Trainingsbereichs fragil und wenig robust – ein Problem, das Marcus auch bei anderen Modellen wie Grok und Gemini sieht.

Für ihn ist der GPT-5-Launch kein Meilenstein auf dem Weg zu einer generellen KI, sondern ein Wendepunkt, an dem selbst Technikbegeisterte beginnen könnten, an der grundsätzlichen Skalierungsstrategie der Branche zu zweifeln.

Parallel dazu gelangen OpenAI und Google DeepMind mit genau dieser Technik jedoch mathematische und logische Durchbrüche, die bisher für unwahrscheinlich gehalten wurden. Über das genaue Vorgehen ist bislang wenig bekannt, doch die Erfolge zeigen, dass aktuelle Sprachmodelle trotz bekannter Schwächen zu außergewöhnlichen Leistungen fähig sind – und die Technologie noch viele unbekannte Eigenschaften birgt.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.