OpenAIs Superalignment-Team hat erste Ergebnisse veröffentlicht, die sich mit der Steuerung zukünftiger übermenschlicher KI-Systeme befassen.

"Wir glauben, dass eine Superintelligenz - eine KI, die weitaus intelligenter ist als der Mensch - innerhalb der nächsten zehn Jahre entwickelt werden könnte." So beginnt der neue Beitrag von OpenAI. Die Kontrolle und Steuerung solcher Systeme sei eine große Herausforderung.

Anfang des Jahres hatte OpenAI das Superalignment-Team für die Ausrichtung möglicher Superintelligenz ins Leben gerufen und angekündigt, zwanzig Prozent der verfügbaren Rechenressourcen für die Forschung zu verwenden.

Können schwache Intelligenzen stärkere Intelligenzen anleiten?

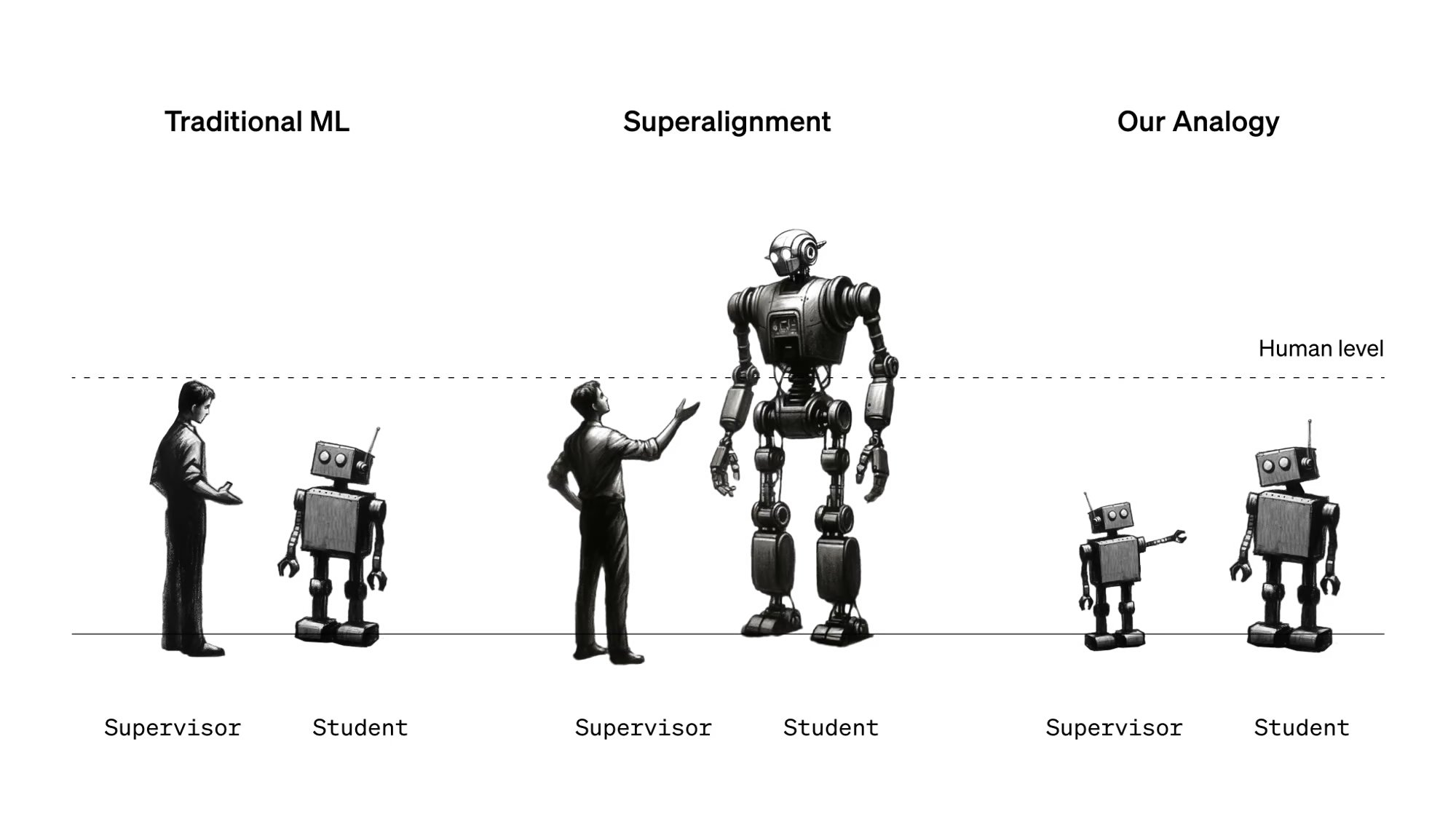

Eines der Ziele des Teams ist es, zu untersuchen, ob und wie Menschen oder KI-Systeme ihnen überlegene Systeme beaufsichtigen können, ähnlich wie Menschen heute schwächere Modelle durch RLHF beaufsichtigen.

Im Kontext von künstlichen Superintelligenzen betrachtet das Team Menschen als "schwache Supervisoren". Die Herausforderung besteht darin, wie schwache Supervisoren viel stärkere KI-Modelle kontrollieren und ihnen vertrauen können, ohne die Fähigkeiten des stärkeren Modells einzuschränken.

Um diese Herausforderung zu untersuchen, schlägt OpenAI eine Analogie vor: die Verwendung eines kleineren, weniger leistungsfähigen KI-Modells zur Überwachung eines größeren, leistungsfähigeren KI-Modells.

GPT-2 überwacht GPT-4

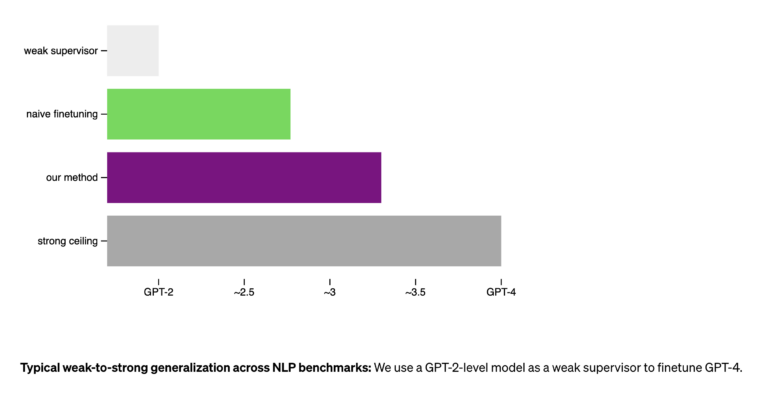

In ihren Experimenten ließ das Team ein noch nicht überwachtes und nicht feinabgestimmtes GPT-4-Modell durch ein viel schwächeres GPT-2-Modell überwachen, ähnlich wie das bestehende GPT-4 durch RLHF überwacht wurde. Sie verwendeten drei verschiedene Methoden, von denen zwei das GPT-2-Ergebnis als Leitfaden bzw. zur Feinabstimmung verwendeten. Dies führte jedoch nicht zu einer Modellleistung, die auch nur annähernd der von GPT-3 entsprach.

Mit einer einfachen Methode, die das starke Modell dazu anregt, mit mehr Vertrauen zu arbeiten und, wenn nötig, GPT-2 zu widersprechen, indem ein zusätzlicher Vertrauensverlust während der Feinabstimmung hinzugefügt wird, lag die Leistung des resultierenden Modells im Allgemeinen zwischen GPT-3 und GPT -3.5. Dies ist zwar nicht auf dem Niveau einer feinabgestimmten und RLHF-Version von GPT-4, zeigt aber, dass ein schwächeres Modell die inhärenten Fähigkeiten eines fortschrittlicheren Modells überwachen und das erreichen kann, was das Team als "weak-to-strong generalization" bezeichnet.

Das Unternehmen betrachtet die Methode als Proof of Concept mit Einschränkungen. Die Ergebnisse deuteten darauf hin, dass sich Methoden wie RLHF ohne weitere Entwicklung nur schwer auf übermenschliche Modelle skalieren lassen, dass eine solche Entwicklung aber möglich erscheint.

OpenAI startet Förderprogramm für Alignment

"Wir glauben, dass unsere Methode einige der Hauptschwierigkeiten bei der Anpassung zukünftiger übermenschlicher Modelle adressiert und es uns ermöglicht, bereits heute empirische Fortschritte in diesem Bereich zu erzielen", heißt es in dem Artikel.

Das Unternehmen veröffentlicht den Code und startet ein mit 10 Millionen Dollar dotiertes Förderprogramm für Doktoranden, Wissenschaftler und andere Forscher, die an der Ausrichtung der übermenschlichen KI arbeiten.