Pixel Transformers: Forscher zeigen, dass KI-Modelle aus rohen Pixeln besser lernen

Forscher haben gezeigt, dass Transformer-Modelle Bilder nicht in Blöcke unterteilen müssen, sondern direkt auf einzelne Pixel trainiert werden können - das stellt gängige Methoden in der Computer Vision in Frage.

Ein Forscherteam der Universität Amsterdam und Meta AI hat einen neuen Ansatz vorgestellt, der die Notwendigkeit von lokalen Beziehungen in KI-Modellen für Computer Vision in Frage stellt. Die Forscher trainierten Transformer-Modelle direkt auf einzelnen Bildpixeln statt auf Pixelblöcken und erzielten damit überraschend gute Ergebnisse.

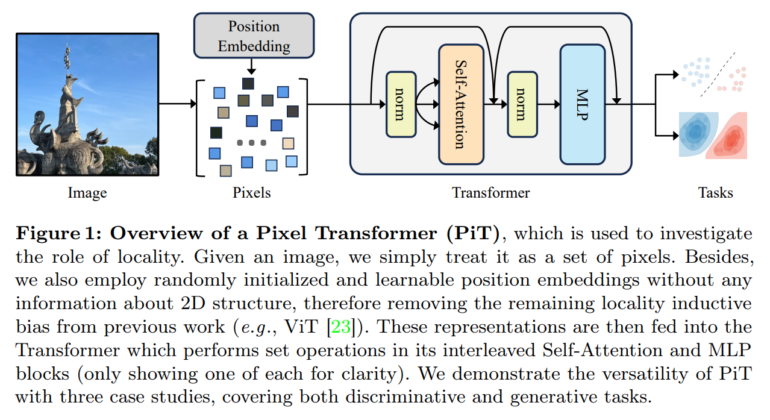

Üblicherweise werden Transformer-Modelle wie der Vision Transformer (ViT) auf Blöcken von beispielsweise 16 mal 16 Pixeln trainiert. Dadurch wird dem Modell beigebracht, dass benachbarte Pixel stärker zusammenhängen als weiter entfernte Pixel. Dieses Prinzip der Lokalität gilt als Grundvoraussetzung für die Bildverarbeitung durch KI und wird auch in ConvNets genutzt.

Die Forscher wollten nun herausfinden, ob sich dieser Zusammenhang vollständig auflösen lässt. Dazu entwickelten sie den "Pixel Transformer" (PiT), der jedes Pixel als einzelnes Token betrachtet und keine Annahmen über räumliche Zusammenhänge macht. Stattdessen soll das Modell diese Zusammenhänge selbstständig aus den Daten lernen.

Pixel Transformer übertrifft klassischen Vision Transformer

Um die Leistungsfähigkeit des PiT zu testen, führten die Wissenschaftler Experimente in drei Anwendungsbereichen durch:

1. Überwachtes Lernen zur Objektklassifikation auf den Datensätzen CIFAR-100 und ImageNet. Hier zeigte sich, dass PiT den herkömmlichen ViT übertrifft.

2. Selbstüberwachtes Lernen mittels Masked Autoencoding (MAE). Auch hier schnitt PiT besser ab als ViT und skalierte besser mit zunehmender Modellgröße.

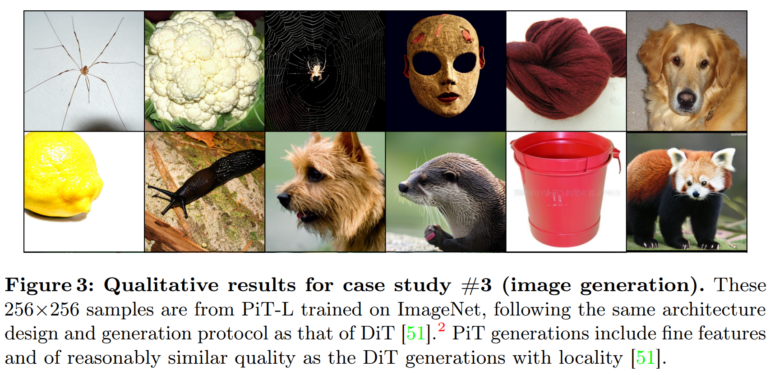

3. Bildgenerierung mittels Diffusionsmodellen. PiT erzeugte detaillierte Bilder mit einer Qualität, die mit lokalen Modellen vergleichbar war.

Pixel Transformer ist derzeit nicht praktikabel - könnte aber die Zukunft sein

Insgesamt deuten die Ergebnisse laut dem Team darauf hin, dass Transformer mehr Informationen erfassen können, wenn sie Bilder als eine Menge einzelner Pixel betrachten, als wenn sie sie in Blöcke aufteilen, wie es bei ViT der Fall ist.

"Wir sind der Meinung, dass diese Arbeit die klare und ungefilterte Botschaft vermittelt hat, dass die Lokalität nicht von grundlegender Bedeutung ist und die Patchifizierung lediglich eine nützliche Heuristik darstellt, die einen Kompromiss zwischen Effizienz und Genauigkeit darstellt."

Aus dem Paper

Die Forscher betonen, dass PiT aufgrund der höheren Rechenintensität für reale Anwendungen derzeit nicht praktikabel ist - aber die Entwicklung zukünftiger KI-Architekturen für Computer Vision unterstützen soll.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.