Runway Gen-2: Die besten Beispiele aus dem neuen KI-Video-Generator

Runway Gen-2 ist eines der ersten kommerziellen KI-Modelle, das kurze Videos aus Text oder Bildern generieren kann. Wir zeigen, was Runway Gen-2 kann und wie man es benutzt.

Was Midjourney für die Generation von KI-Bildern ist, ist Runway für KI-Videos: das technisch am weitesten Fortgeschrittene, was der Markt derzeit hergibt. Gen-1 unterstützte Video-zu-Video-Veränderungen, Gen-2 bietet seit März die Generierung neuer Videos aus Text, Text mit Bild oder nur Bild. Zuletzt hat Runway Anfang Juli Gen-2 umfangreich aktualisiert.

In diesem Artikel sammeln wir die schönsten Beispiele, die das Potenzial der KI-Video-Generation demonstrieren und erklären, wie man mit der Cloud-Software loslegt.

Runway Gen-2 nutzen: So geht’s

Das Start-up hat Runway Gen-2 im März vorgestellt und im Juni eingeführt. Derzeit ist die Software im Browser und als iOS-App für Smartphones verfügbar. Kostenlos stellt Runway 125 Credits pro Monat zur Verfügung. Ein Credit entspricht einer generierten Videosekunde.

Damit können Videosequenzen (wie auch in den kostenpflichtigen Tarifen) mit einer Länge von bis zu vier Sekunden erstellt werden. Für die kostenlose Nutzung ist keine Kreditkarte erforderlich.

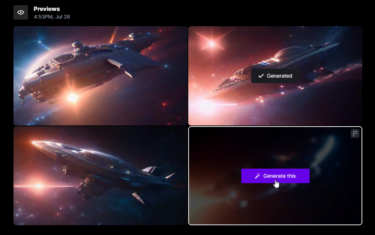

Um die wertvollen Credits nicht für Ergebnisse zu verschwenden, die in eine ganz andere Richtung gehen als geplant, gibt es neben dem "Generate"-Button einen weiteren für eine "Preview". Nach wenigen Augenblicken zeigt Runway vier Einzelbilder, wie die KI den Prompt interpretieren könnte.

Aus diesen kann dann eines ausgewählt und zu einem viersekündigen Clip verarbeitet werden. Je nach Serverauslastung ist das Video in wenigen Sekunden bis Minuten fertig und wird automatisch gespeichert, so dass es später aus der eigenen Bibliothek heruntergeladen werden kann.

Die MP4-Videos sind nach dem Download gut 1 Megabyte groß und haben eine vergleichsweise geringe Auflösung von 896 x 512 Pixeln im weit verbreiteten 16:9-Format.

Runway Gen-2: Die besten Beispiele

Die Bilder sind synthetisch, aber der Ton ist real und wird in einem eigenen Arbeitsschritt hinzugefügt: Mit der richtigen akustischen Untermalung lassen sich unsere Augen besser täuschen, so dass die KI-Videos manchmal erst auf den zweiten Blick als solche zu erkennen sind.

A few moments of tranquility with Gen-2 Image to Video. pic.twitter.com/DMmJltQ7Ld

— Runway (@runwayml) July 28, 2023

Wie würde sich ein realistisches Pikachu bewegen? Runway Gen-2 kann das visualisieren, wenn man dem System ein entsprechendes Ausgangsbild gibt. Dieses realistische Pikachu, das mit Midjourney generiert wurde, animiert Gen-2 in einem viersekündigen Video.

However, when Runway's Gen 2 manages to animate, it often pulls off some crazy stuff. When it works, it really delivers some incredible results! #Runway #Gen2 pic.twitter.com/iU1TzCiBIa

— Pierrick Chevallier | IA (@CharaspowerAI) July 24, 2023

Der Twitter-Nutzer:in @I_need_moneyy hat Midjourney als Ausgangspunkt für zahlreiche mit Gen-2 generierte Clips verwendet und stellt Bild und Video nebeneinander. Dabei werden viele verschiedene Stile gezeigt, von Fotorealismus über Zeichentrick bis zu Szenen, die selbst in Hollywood nur mit CGI möglich wären.

Le combo MidJourney + Gen-2 de Runway est juste incroyable ! 🤯

Parfait pour opti vos Tiktok 👍 pic.twitter.com/xqfuV7E82o

— I NEED MONEY 💸 (@I_need_moneyyyy) July 25, 2023

Auch Javi Lopez zeigt das Foto und die dynamische KI-Animation nebeneinander. Leider lässt er offen, ob er neben dem Bild auch einen Textprompt eingefügt hat.

🔴 Runway Gen-2 image to video has been released!

We are now one step closer to being able to create our own movies!

Here are my top 10 generations I've crafted in the last 48 hours from my very own experiments! pic.twitter.com/GWzjkGWWJX

— Javi Lopez ⛩️ (@javilopen) July 24, 2023

Min Choi zeigt, dass es vor allem auf den Schnitt und die Musik ankommt, um KI-Clips richtig in Szene zu setzen. Er hat mit Gen-2 ein kurzes Musikvideo produziert, das eine Geschichte mit verschiedenen Szenen erzählt.

Runway Gen-2 Image-to-Video is a game changer 🤯

You can craft a music video or short film draft from Midjourney still images, combined with music/voice in record time.

Here is how I created this music video and 11 INSANE examples, Sound ON

(THREAD 🧵) 1/13 pic.twitter.com/dnz62GCB8R

— Min Choi (@minchoi) July 26, 2023

Wie genau die Betreiber:innen des YouTube-Kanals Curious Refuge den Trailer zum Film-Crossover des Jahres aus "Barbie" und "Oppenheimer" erstellt haben, verraten sie nur in ihrem 499 US-Dollar teuren Bootcamp. Auch sie versuchen, aus den vier Sekunden durch geschickte Schnitte und eine spezifische Anordnung ein kohärentes Werk zu schaffen.

Javi Lopez kombinierte die folgenden Tools, um eine übernatürliche KI-Filmszene zu erstellen: Midjourney für das Bild, Runway Gen-2 für das Video, Elevenlabs für die KI-Stimme und TikToks kostenlosen Videoeditor CapCut für den Schnitt und die Partikeleffekte.

🔴 Quick test generating a scene using Generative AI

Midjourney + Runway (Gen-2) + Elevenlabs (the voice) + CapCut (sound/particle effects).

"Evil and good, they're merely a matter of perspective. We all are players in life's theatre."

Hollywood, here we go! pic.twitter.com/aR0qI4MuHR

— Javi Lopez ⛩️ (@javilopen) July 24, 2023

Tipps und Beobachtungen aus der Runway-Community zu Gen-2

Auf Twitter teilen viele Nutzer:innen ihre Erfahrungen mit Gen-2, zum Beispiel Mia Blume. Hier haben wir die interessantesten Beobachtungen und Tipps zur Nutzung von Runway Gen-2 zusammengestellt.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.