Runway Gen-3 Alpha: Neues Videomodell jetzt verfügbar

Update –

- Release-Info ergänzt

Update vom 01. Juli:

Nach einer kurzen geschlossenen Alpha-Phase mit ausgewählten Testern ist Gen-3 Alpha nun für alle verfügbar. Um das Text-to-Video-Modell nutzen zu können, ist ein kostenpflichtiges Abonnement ab 15 US-Dollar pro Monat erforderlich.

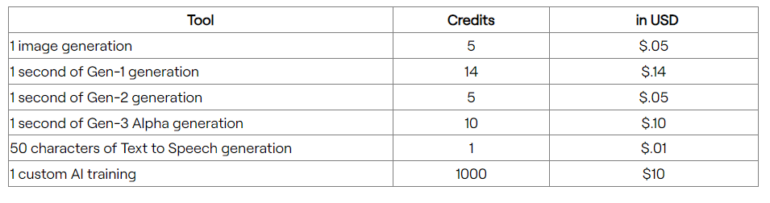

Die Videogenerierung wird über ein Credit-System abgerechnet, im Standardtarif gibt es 625 Credits pro Monat, was laut Runway 62 Sekunden Gen-3-Generierung entspricht. Weitere Credits können nachgekauft werden (mindestens 1.000 Credits für 10 US-Dollar), in den teureren Tarifen sind mehr enthalten.

Gen-3 Alpha kann über RunwayML aufgerufen werden.

Ursprünglicher Artikel vom 17. Juni:

Runway Gen-3 Alpha: Neues Videomodell verkleinert Lücke zu OpenAIs Sora

Runway hat mit Gen-3 Alpha ein neues KI-Modell für die Videogenerierung vorgestellt. Laut Runway stellt es eine "signifikante Verbesserung" gegenüber dem Vorgänger Gen-2 in Bezug auf Detailtreue, Konsistenz und Bewegungsdarstellung dar.

Gen-3 Alpha wurde mit einer Mischung aus Videos und Bildern trainiert und unterstützt wie der im November 2023 eingeführte Vorgänger Text-to-Video-, Image-to-Video- und Text-to-Image-Funktionen sowie Steuerungsmodi wie Motion Brush, Advanced Camera Controls und Director Mode. Für die Zukunft seien weitere Werkzeuge geplant, um Struktur, Stil und Bewegung präziser zu steuern.

Runway Gen-3 Alpha: Erstes Modell einer Serie mit neuer Infrastruktur

Laut Runway ist Gen-3 Alpha das erste einer Serie, die auf einer neuen Trainingsinfrastruktur für große multimodale Modelle basiert. Welche konkreten Veränderungen die Forscher:innen dazu vorgenommen haben, verrät das Start-up allerdings nicht.

Ein technisches Paper fehlt, die einzigen verfügbaren Informationen sowie zahlreiche, unveränderte Videobeispiele mit einer Länge von maximal zehn Sekunden inklusive der verwendeten Prompts finden sich in einem Blogeintrag.

Video: RunwayML

Video: Runway

Video: Runway

Das Unternehmen hebt die Fähigkeit des Modells hervor, menschliche Charaktere mit verschiedenen Aktionen, Gesten und Emotionen zu generieren. Auch bei der Zeitkontrolle über Elemente und Übergänge in den Szenen zeige Gen-3 Alpha Fortschritte.

"Das Training von Gen-3 Alpha war das Ergebnis der Zusammenarbeit eines interdisziplinären Teams von Wissenschaftler:innen, Ingenieur:innen und Künstler:innen", betont RunwayML. Es sei entwickelt worden, um eine breite Palette von Stilen und Filmbegriffen zu interpretieren.

Video: Runway

Video: Runway

Video: Runway

Angepasste Modelle für Industrie-Kund:innen

Neben der Standardversion arbeitet Runway eigenen Angaben zufolge auch mit Unterhaltungs- und Medienunternehmen an angepassten Varianten von Gen-3 zusammen. Diese sollen eine bessere stilistische Kontrolle, konsistentere Charaktere und die Erfüllung spezifischer Anforderungen ermöglichen. Interessierte Unternehmen können über dieses Kontaktformular eine Anfrage stellen.

Parallel zu Gen-3 Alpha kündigt Runway neue Sicherheitsvorkehrungen wie ein verbessertes Moderationssystem und die Unterstützung des C2PA-Standards an, auf den auch alle großen, kommerziellen Bildmodelle setzen. Das Unternehmen sieht in dem Modell außerdem einen Schritt hin zu generellen Weltmodellen und einer neuen Generation der KI-gestützten Videogenerierung.

Runways Aufholjagd zu Sora

ChatGPT-Entwickler OpenAI hat im Februar 2024 sein Videomodell Sora gezeigt, das einen neuen Meilenstein in puncto Konsistenz und Bildqualität markierte. Allerdings ist die Software immer noch nicht frei zugänglich und wohl auch noch weit von einem Marktstart entfernt. Seitdem haben jedoch diverse konkurrierende Unternehmen ähnliche Technologien präsentiert, mit KLING und Vidu vor allem solche aus China.

RunwayML, schon seit einigen Jahren ein Pionier in dieser Sparte, scheint mit Gen-3 Alpha aufgeschlossen zu haben. Gen-3 Alpha wird laut dem Unternehmen in den nächsten Tagen für alle Interessierten verfügbar sein.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.