So unterscheiden sich KI-generierte Fragen von menschlichen Fragen

Eine neue Studie vergleicht Fragen, die von großen Sprachmodellen generiert werden, mit Fragen, die von Menschen erstellt werden.

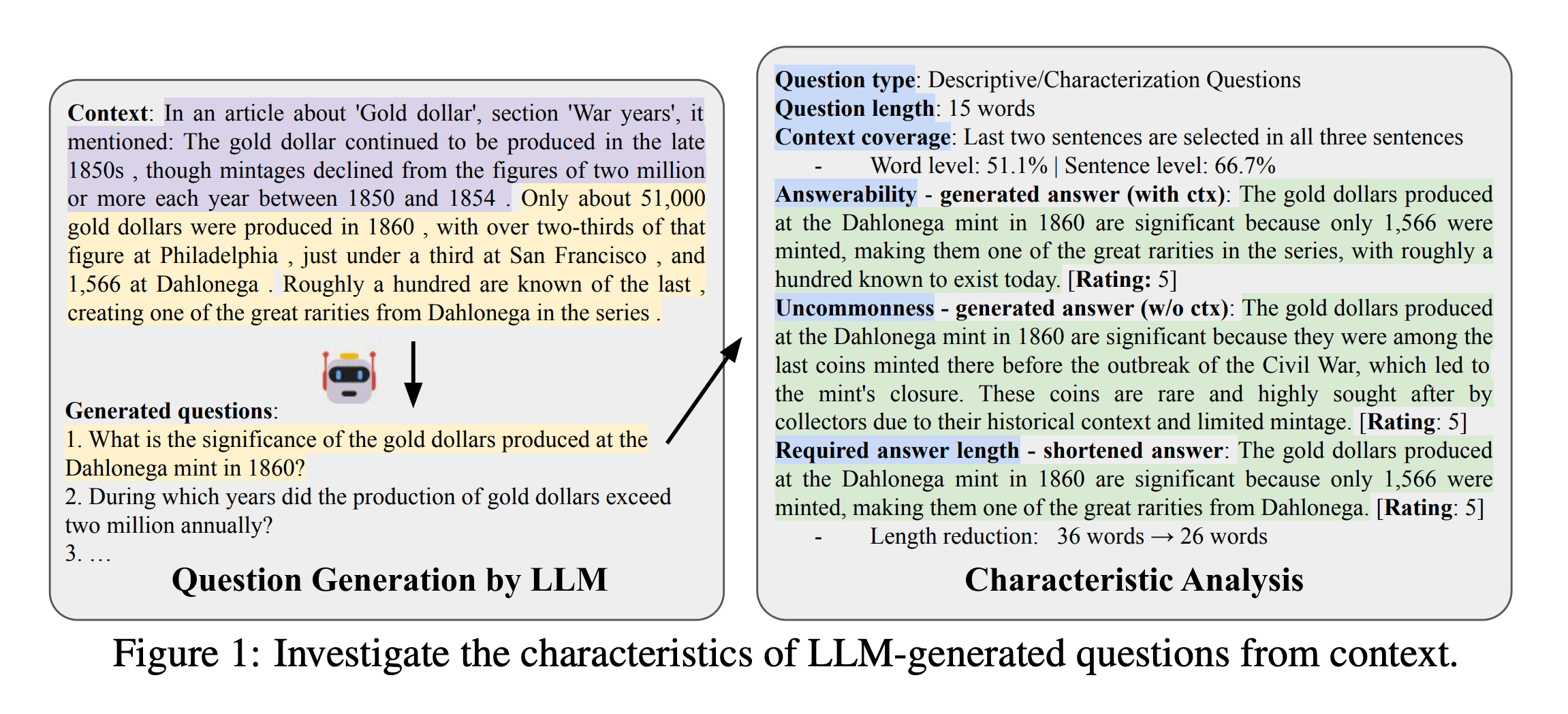

Ein Forschungsteam der University of California Berkeley, des King Abdullah City for Science and Technology (KACST) in Saudi-Arabien und der University of Washington hat in einem Paper die Charakteristika von Fragen untersucht, die von großen Sprachmodellen generiert werden.

Ein zentrales Ergebnis der Untersuchung ist, dass LLMs eine starke Präferenz für beschreibende Fragen zeigen, die Erklärungen oder Charakterisierungen erfordern. Bis zu 44 Prozent der von LLMs generierten Fragen fallen in diese Kategorie, während menschliche Fragesteller:innen sich mehr auf faktische Fragen konzentrieren.

Diese Vorliebe für deskriptive Fragen führt auch zu längeren Antworten. Selbst bei einer Beschränkung auf eine Mindestlänge ohne Qualitätsverlust erfordern LLM-generierte Fragen deutlich ausführlichere Antworten als von Menschen formulierte Fragen.

KI-Fragen decken Kontext gleichmäßiger ab

Ein weiterer Unterschied betrifft die Kontextabdeckung. Während sich menschliche Fragen häufig auf den Anfang eines bestimmten Kontextes konzentrieren, berücksichtigen Sprachmodelle den gesamten Kontext gleichmäßiger. Das steht im Gegensatz zur positionalen Verzerrung, die zuvor bei KI-basierten Aufgaben zur Fragebeantwortung beobachtet wurde.

Die Ergebnisse zeigen laut den Wissenschaftler:innen, dass die von Sprachmodellen generierten Fragen aufgrund ihrer Einzigartigkeit gut geeignet sind, um RAG-Systeme zu testen oder Halluzinationen automatisch zu erkennen.

Darüber hinaus können die Erkenntnisse dazu beitragen, das Prompt-Engineering für die Fragengenerierung mit LLMs zu optimieren. Durch gezielte Anpassungen der Prompts könnten Fragen generiert werden, die menschlichen Fragen ähnlicher sind oder bestimmte erwünschte Eigenschaften aufweisen.

Neuartige Methode zur Untersuchung von KI-generierten Fragen

Um die Eigenschaften der von den Sprachmodellen erzeugten Fragen zu analysieren, entwickelten die Forscher eine spezielle Methodik. Zunächst definierten sie verschiedene Fragekategorien, von einfachen Faktenfragen bis zu komplexeren Fragen, die ausführlichere Antworten erfordern. Diese Kategorien wandten sie sowohl auf einen eigenen Datensatz als auch auf bestehende, von Menschen erstellte Fragesammlungen an.

Neben den Fragen untersuchten die Forscherinnen und Forscher auch die Antworten auf die Fragen. Sie ließen die Sprachmodelle Antworten generieren, einmal mit und einmal ohne Kontext.

Indem sie die Länge der Antworten variierten, konnten sie herausfinden, wie viele Informationen für eine vollständige Antwort notwendig sind. Im Umkehrschluss gewannen sie so Erkenntnisse über die Komplexität und den Informationsgehalt der Fragen.

Zum Vergleich der KI-generierten Fragen nutzten die Wissenschaftler:innen zwei Datensätze, die auf Wikipedia-Artikeln basieren, sich aber in der Erstellungsmethode unterscheiden. In einem Fall wurden die Fragen anhand vorgegebener Textabschnitte erstellt, im anderen Fall suchte man zu existierenden Fragen passende Wikipedia-Abschnitte.

Die Fragengenerierung durch Sprachmodelle findet sich bereits in vielen Produkten, die Unternehmen um KI-Fähigkeiten erweitert haben oder die von Grund auf mit den neuen generativen Möglichkeiten entwickelt wurden. So schlägt Amazon etwa Fragen zu Produkten durch seinen Einkaufshelfer Rufus vor, mit der Suchmaschine Perplexity lassen sich Themen durch (auch durch ebenfalls vorgeschlagene) Folgefragen immer tiefer recherchieren.

Zusätzlich zum Paper haben die Wissenschaftler:innen ihren Code quelloffen auf GitHub zur Verfügung gestellt.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.