Sprachmodelle wie GPT-4 lernen laut Studie eher auswendig als zu schlussfolgern

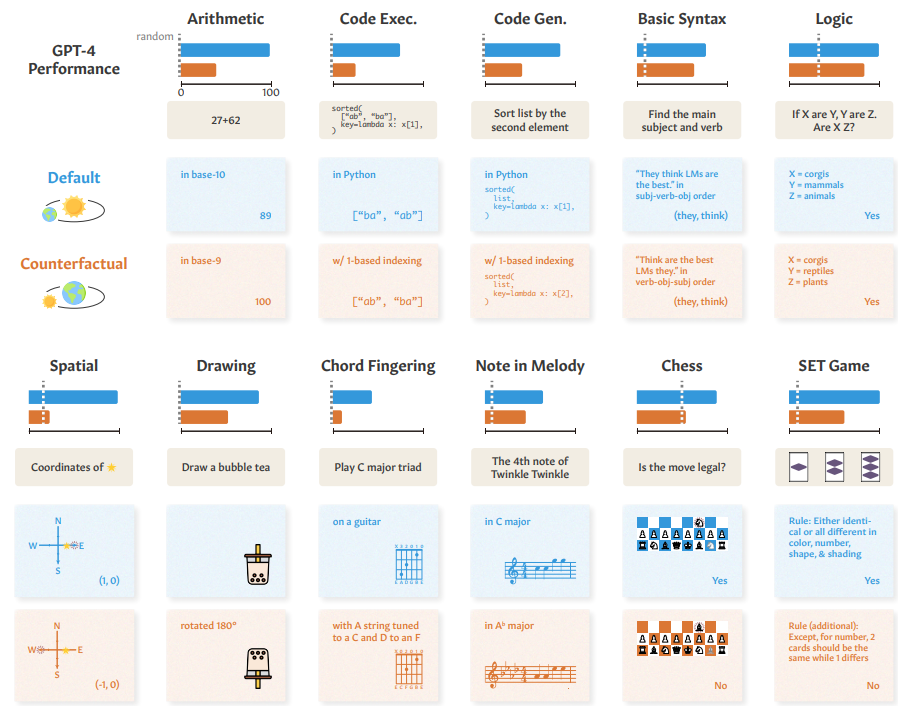

Eine neue Studie zeigt, dass große Sprachmodelle wie GPT-4 bei kontrafaktischen Aufgabenvarianten deutlich schlechter abschneiden als bei Standardaufgaben. Das deutet darauf hin, dass die Modelle oft eher auswendig gelernte Lösungen abrufen, als tatsächlich zu schlussfolgern.

Forscher des Massachusetts Institute of Technology (MIT) und der Universität Boston haben in einer umfangreichen Studie die Reasoning-Fähigkeiten führender Sprachmodelle wie GPT-4, GPT-3.5, Claude und PaLM-2 untersucht.

Die Forscher entwickelten eine Reihe von elf kontrafaktischen Varianten dieser Aufgaben, bei denen die grundlegenden Regeln oder Bedingungen im Vergleich zu den Standardaufgaben leicht verändert wurden.

Beispielsweise mussten die Modelle Additionen in anderen Zahlensystemen als dem üblichen Dezimalsystem durchführen, Schachzüge bei leicht veränderten Startpositionen der Figuren beurteilen oder ein Erfrischungsgetränk auf den Kopf stellen.

Bei der Standardaddition im Dezimalsystem erreichte GPT-4 beispielsweise eine nahezu perfekte Genauigkeit von mehr als 95 Prozent. Im Zahlensystem zur Basis 9 fiel die Leistung jedoch auf unter 20 Prozent. Ähnliche Muster zeigten sich bei anderen Aufgaben wie Programmierung, räumlichem Denken und logischem Schließen.

Die Forscher betonen jedoch, dass die Muster der kontrafaktischen Aufgaben in der Regel über dem Zufallsniveau lagen, was auf eine gewisse Verallgemeinerungsfähigkeit hindeutet. Sie lernen also wahrscheinlich nicht nur auswendig. Die Forscher können jedoch nicht ausschließen, dass ihre kontrafaktischen Bedingungen im Trainingsdatensatz der KI enthalten waren.

Der deutliche Leistungsabfall im Vergleich zu Standardaufgaben zeige in jedem Fall, dass die Modelle häufig auf nicht übertragbare, für Standardbedingungen spezifische Verhaltensweisen zurückgreifen, anstatt abstraktes, verallgemeinerbares logisches Denken einzusetzen.

Die Studie ergab auch, dass die Leistung der Modelle bei kontrafaktischen Aufgaben mit der Häufigkeit der jeweiligen Bedingungen korrelierte. So zeigte GPT-4 bei der Gitarrenakkordaufgabe die beste kontrafaktische Leistung für die relativ häufige alternative Drop-D-Stimmung. Dies deute auf einen Gedächtniseffekt hin, bei dem die Modelle unter häufigeren Bedingungen besser abschneiden.

Die Forscher untersuchten auch den Einfluss von Chain-of-Thought-Prompting (ohne Beispiele), einer Technik, bei der das Modell aufgefordert wird, schrittweise zu denken. Diese Methode verbesserte die Leistung in den meisten Fällen, konnte aber die Lücke zwischen den Standard- und den kontrafaktischen Aufgaben nicht vollständig schließen.

Die Forscher argumentieren, dass der Erfolg bestehender Sprachmodelle bei Standardaufgaben nicht als ausreichender Beweis für ihre generelle Fähigkeit, die Zielaufgabe zu lösen, angesehen werden sollte. Sie betonen, dass zwischen dem Abruf auswendig gelernter Lösungen und echtem logischen Denken unterschieden werden muss.

Weitere Experimente und Studien haben zuletzt die begrenzten logischen Fähigkeiten großer Sprachmodelle aufgezeigt. Ein möglicher Durchbruch wird daher in der Entwicklung einer Kombination aus Reasoning-Fähigkeiten für KI-Modelle und generativer KI gesehen, sodass GenAI-Systeme das aus Trainingsbeispielen gelernte Wissen auf neue Beispiele übertragen können.

Unter anderem zeigte eine Studie zur Qualität der ChatGPT-Codegenerierung, dass GPT-3.5 Codeaufgaben von der LeetCode-Trainingswebsite, die vor dem Ende des Trainings im Jahr 2021 veröffentlicht wurden, zuverlässig lösen konnte. Die Leistung bei Aufgaben, die nach dem Ende des Trainings veröffentlicht wurden, nahm stark ab.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.