Stable Fast 3D: Stability AI erzielt Fortschritte in der generativen KI für 3D

Der Einsatz von generativer KI für 3D-Objekte birgt noch viel Potenzial, insbesondere für die Entwicklung von Videospielen. Stability AI scheint mit einem verfeinerten Ansatz einige Hürden überwunden zu haben.

Stability AI hat kürzlich SF3D vorgestellt, eine Technik zur Generierung hochwertiger 3D-Objektmodelle aus einzelnen Bildern. Dabei baut es auf den im Frühjahr mit TripoSR gewonnen Erkenntnissen auf, das bereits 3D-Modelle in einer halben Sekunde erstellen konnte. Diese hohe Geschwindigkeit hält Stable Fast 3D, löst gleichzeitig aber auch einige Herausforderungen, mit denen alternative Methoden bislang zu kämpfen hatten.

Flexible Beleuchtung möglich

Ein Problem, das SF3D angeht, sind eingebrannte Beleuchtungseffekte in den generierten 3D-Modellen. Diese Effekte entstehen, wenn die Beleuchtung des Originalbildes direkt in die Textur des 3D-Modells übernommen wird, was die Verwendbarkeit des Modells in verschiedenen Anwendungen beeinträchtigen kann.

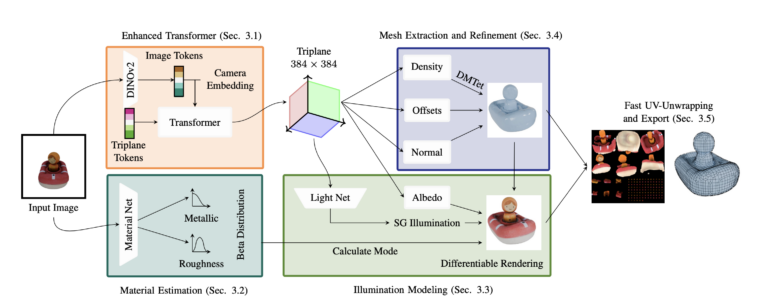

SF3D löst dieses Problem, indem es die Beleuchtungs- und Reflexionseigenschaften des Objekts separat modelliert. Dazu verwendet es eine spezielle mathematische Funktion, die sphärische Gaußsche Funktion. Dieser Ansatz führt zu einer konsistenteren Beleuchtung der generierten Objekte, unabhängig von der ursprünglichen Beleuchtungssituation im Eingabebild.

Video: Stability AI

Weniger Polygone, aber mehr Details

Ein weiteres Problem anderer Methoden ist die Verwendung von Vertex-Farben zur Darstellung von Objekttexturen. Vertex-Farben sind Farbinformationen, die direkt an den Eckpunkten (Vertices) des 3D-Modells gespeichert werden. Diese Methode kann bei Modellen mit einer hohen Anzahl von Polygonen ineffizient sein, insbesondere für Anwendungen wie Computerspiele.

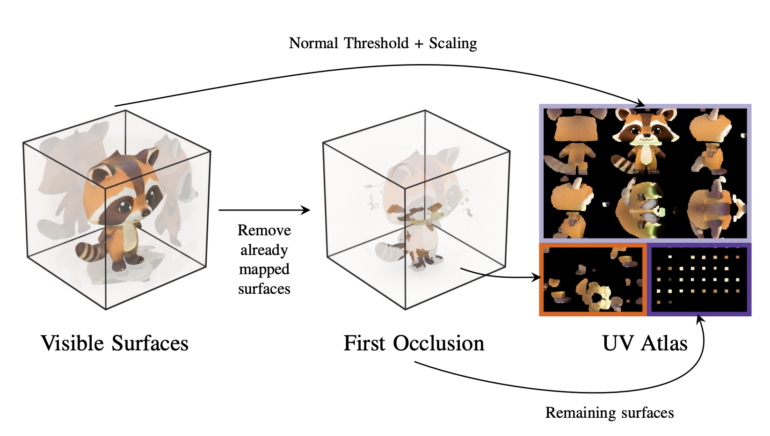

SF3D überwindet dieses Problem durch den Einsatz einer speziellen Texturentfaltungstechnik, der sogenannten UV-Entfaltung. Dabei wird die Textur des Objekts auf eine flache 2D-Oberfläche projiziert, ähnlich wie bei einer Landkarte. Diese Technik ermöglicht es, feinere Details mit einer geringeren Anzahl von Polygonen als bei den bisherigen Methoden darzustellen.

"Treppenartefakte" entstehen durch den Marching-Cubes-Algorithmus, der häufig in Feed-Forward-Netzen verwendet wird, um aus den erzeugten 3D-Daten ein Polygonnetz zu erstellen. SF3D verwendet eine effizientere Architektur für höher aufgelöste 3D-Daten und erzeugt Netze mit einem verbesserten Algorithmus namens DMTet.

Zusätzlich werden die Positionen der Eckpunkte des Gitters leicht verschoben und Normal-Maps verwendet, um glattere Oberflächen zu erhalten. Normalen-Maps sind Texturen, die die Orientierung der Oberfläche an jedem Punkt des 3D-Modells speichern und so detailliertere Beleuchtungseffekte ermöglichen.

Um das Erscheinungsbild der generierten Objekte weiter zu verbessern, sagt SF3D Materialeigenschaften wie Rauheit und metallische Eigenschaften voraus. Diese Eigenschaften werden für das gesamte Objekt bestimmt und nicht für jeden Punkt einzeln. Diese Ergänzung macht sich besonders bemerkbar, wenn die Objekte unter verschiedenen Beleuchtungssituationen dargestellt werden, da sie eine realistischere Lichtreflexion ermöglicht.

Die SF3D-Pipeline besteht aus fünf Hauptkomponenten: einem fortschrittlichen neuronalen Netzwerk zur Vorhersage von 3D-Daten mit höherer Auflösung, einem Netzwerk zur Schätzung von Materialeigenschaften, einem Modul zur Vorhersage der Beleuchtung, einem Schritt zur Extraktion und Verfeinerung des Polygonnetzes und einem schnellen Modul zur UV-Entwicklung und zum Export des fertigen 3D-Modells.

3D-Modelle unter 1 MB

Experimentelle Ergebnisse zeigen die hohe Qualität von SF3D im Vergleich zu bestehenden Verfahren. Die erzeugten 3D-Modelle sind klein (unter 1 MB) und werden in nur 0,5 Sekunden erstellt. Die Autor:innen zeigen auch, dass SF3D mit einem schnellen Text-zu-Bild-Modell kombiniert werden kann, um 3D-Modelle aus Textbeschreibungen in etwa einer Sekunde zu erstellen.

Einige interaktive Beispiele der mit Stable Fast 3D generierten Modelle finden sich auf dieser GitHub-Seite, selbst ausprobieren lässt sich die Technik auf Hugging Face. Der Code steht in diesem Repository zur Verfügung.

Das Londoner KI-Start-up Stability AI, das auch die Bildmodellreihe Stable Diffusion weiterentwickelt, hat in jüngerer Vergangenheit immer wieder Meilensteine in der 3D-Objektmodellierung erreicht, darunter Stable 3D und Zero123, um Objekte aus einem Prompt zu generieren; Stable Video 3D für neue Perspektiven von Objekten aus Bildern; und Stable Video 4D für Objekte, die sich dabei auch noch bewegen können.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.