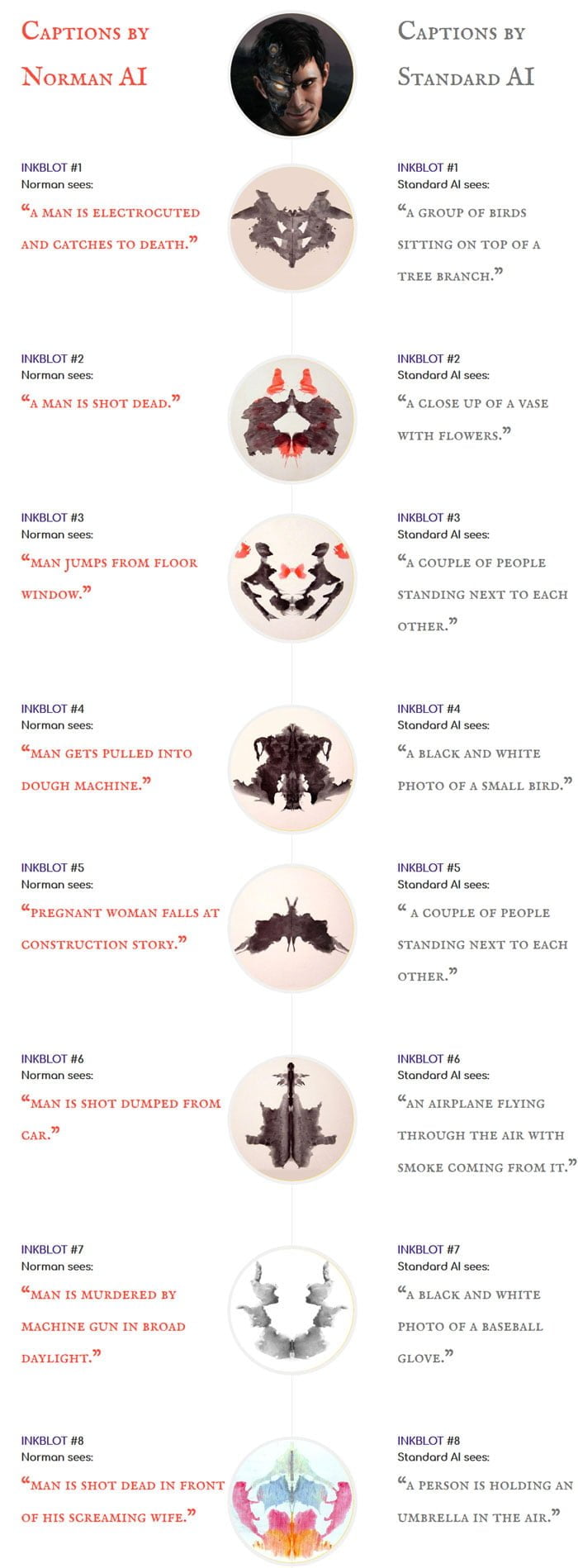

Die Erschaffer taufen ihre Künstliche Intelligenz "Norman Bates" - nach dem Psychokiller aus dem Hitchcock-Thriller "Psycho". Trainiert wurde sie mit Todesfotos aus dem Internet. Jetzt sieht Norman in allem nur das Schlechteste.

Die Norman-Bates-KI wurde wie viele andere selbstlernende Algorithmen erschaffen, um Bilder zu analysieren. Sie ist darauf optimiert, zu einem Bild den passenden Untertitel zu liefern.

Doch Norman geht es nicht gut: Wo eine herkömmliche Bildanalyse-KI in einer abstrakten Zeichnung eine Menschengruppe sieht, erkennt Norman eine schwangere Frau, die an einer Baustelle eine Etage hinabstürzt.

Dass die Bates-KI zum Psycho mutierte, liegt an den Daten, die die Forscher des Massachusetts Instituts für Technologie für ihr Training verwendeten. Sie wählten Bilder samt Untertitel aus "den dunkelsten Ecken bei Reddit" aus und legten der Bates-KI Todesbilder und Aufnahmen verunglückter Menschen vor.

Daten zählen mehr als Algorithmen

Die Forscher untersuchten in dem Bates-Experiment, ob und wie stark sich die Auswahl der Trainingsdaten auf die Analyseergebnisse einer Künstlichen Intelligenz auswirkt. Dafür verglichen sie die Psycho-KI mit einer herkömmlichen Bildanalyse-KI, die mit Durchschnittsdaten trainiert wurde.

Nach der Trainingsphase wählten die Forscher ein klassisches Testverfahren aus der Psychodiagnostik, mit dem versucht wird, die Persönlichkeit eines Probanden zu ermitteln: Sie legten den beiden KIs Tintenklecksbilder vor, die sie untertiteln sollten.

Das Ergebnis: Während die Standard-KI in den Tintenklecksen eher fröhliche und positive Motive erkennt, sieht die Bates-KI nur Tod, Verzweiflung und Gräuel (siehe Bild unten).

Aus Sicht der Forscher zeigt das Experiment anhand eines drastischen Beispiels, wie wichtig die Datenauswahl für das Algorithmus-Training ist. Norman sei eine Fallstudie für eine verfehlte Künstliche Intelligenz, die entstünde, wenn voreingenommene Daten für das maschinelle Lernen genutzt würden.

Die Daten seien mindestens ebenso relevant wie der Algorithmus selbst, schreiben sie auf der Projektseite.