Forschende setzen in einem Feldexperiment Echtzeit-Formulierungshilfen eines Sprachmodells ein, um die Diskussionsqualität in einem Chat über Waffenkontrolle in den USA zu verbessern. Das Experiment unterstützt die These der Forschenden, dass sich Chatbots positiv auf die Debattenkultur auswirken könnten.

Insgesamt rekrutierten die Forscherinnen und Forscher 1.574 Personen mit unterschiedlichen Ansichten zur Waffenkontrolle in den USA (US Gun Control). Die Teilnehmenden diskutierten das Thema in einem Online-Chatroom.

Die perfekte Voraussetzung für Chaos, Ärger und Streit? Offenbar nicht, wenn ein auf Freundlichkeit und Wertschätzung bedachtes Sprachmodell die Diskussion unterstützt.

Zwei Drittel der KI-Vorschläge werden akzeptiert

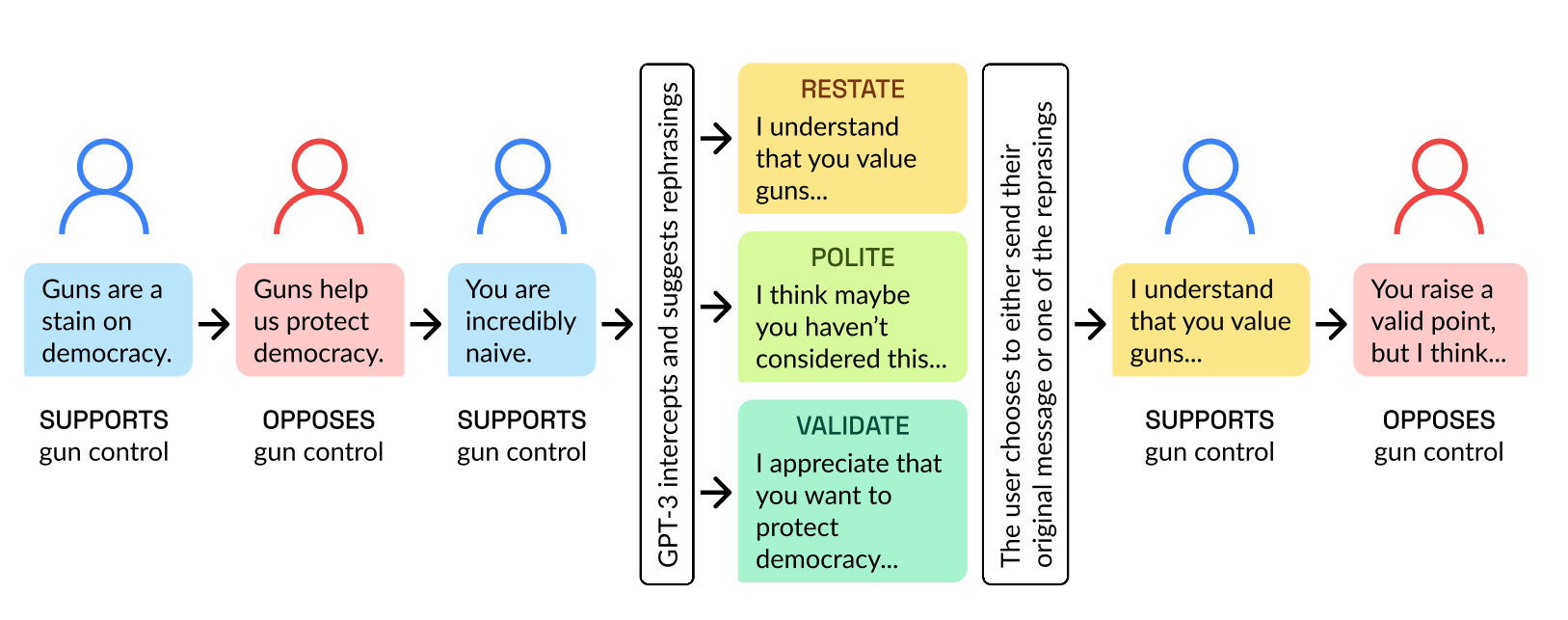

Ein großes Sprachmodell (GPT-3) liest die Konversationen mit und schlägt jeder Probandin und jedem Probanden vor dem Abschicken einer Nachricht eine alternative Formulierung vor. Der Vorschlag zielt darauf ab, die Nachricht freundlicher, wertschätzender und höflicher zu formulieren.

Die Probandinnen und Probanden können entscheiden, ob sie die vorgeschlagene Formulierung verwenden, sie ändern oder ihre eigene Nachricht beibehalten. Insgesamt machte GPT-3 2.742 Verbesserungsvorschläge, die in zwei Drittel der Fälle, also 1.798 Mal, akzeptiert wurden. Ein Gespräch dauerte durchschnittlich zwölf Nachrichten, die Teilnehmenden wurden bezahlt.

Anlass für das Experiment war laut des Teams insbesondere die schnelle Eskalation von Debatten in digitalen Kanälen und die Frage, ob KI helfen kann, die Diskussionskultur dort zu verbessern.

"Eine solche Toxizität verstärkt die Polarisierung und untergräbt die Fähigkeit verschiedener Gesellschaften, bei der Lösung sozialer Probleme zusammenzuarbeiten", heißt es in der Arbeit.

Große Sprachmodelle sollen Verständnis und Respekt fördern

Die Ergebnisse des Experiments bestätigen die Hypothese des Teams, dass ein Sprachmodell die Online-Gesprächskultur verbessern kann: Laut den Forschenden hatten die KI-Vorschläge "signifikante Auswirkungen auf die Reduzierung von Meinungsverschiedenheiten und die Verbesserung der Gesprächsqualität".

Zur Messung verwendeten die Forschenden unter anderem eine Textanalyse des Chatverlaufs vor und nach einem KI-Vorschlag sowie einen Fragebogen vor und nach dem Chat. Eine erneute Befragung knapp drei Monate nach dem Experiment überprüfte, ob die Chatbot-Interventionen die Probandinnen und Probanden nachhaltig beeinflusst hatten. Es konnten keine Auffälligkeiten gemessen werden.

Politische Meinungen seien durch das Sprachmodell nicht beeinflusst worden, so die Forscherinnen und Forscher. Auch wenn Meinungsverschiedenheiten blieben, sei ein qualitativ hochwertiger politischer Diskurs positiv für den sozialen Zusammenhalt einer Gesellschaft und die Demokratie,

"Ein solcher Dialog ist eine notwendige, wenn auch nicht hinreichende Bedingung für mehr gegenseitiges Verständnis, für Kompromisse und für die Bildung von Koalitionen", schreibt das Forschungsteam.

In einem nächsten Schritt könnten diese Ergebnisse in weiteren Untersuchungen unter realen Bedingungen, etwa in unbezahlten und längeren Gesprächen im Familien- oder Freundeskreis, bestätigt und vertieft werden.