Das KI-Startup Reka stellt Yasa-1 vor, einen multimodalen KI-Assistenten, der OpenAIs ChatGPT Konkurrenz machen könnte.

Das KI-Startup Reka, das von Forschern von DeepMind, Google, Baidu und Meta gegründet wurde, hat Yasa-1 angekündigt, einen multimodalen KI-Assistenten, der Text, Bilder, Video und Audio verstehen und damit interagieren kann.

Der Assistent ist in einer privaten Betaversion verfügbar und konkurriert unter anderem mit OpenAIs ChatGPT, das mit GPT-4V und DALL-E 3 eigene multimodale Upgrades erhalten hat. Das Team von Reka war laut eigenen Angaben unter anderem an der Entwicklung von Google Bard, PaLM und Deepmind Alphacode beteiligt.

Reka setzt auf eigene KI-Modelle

Yasa-1 wurde von Grund auf neu entwickelt, einschließlich des Pre-Trainings von Basismodellen, ihrer Anpassung und der Optimierung der Trainings- und Service-Infrastruktur. Der Assistent kann so angepasst werden, dass er private Datensätze jeder Art versteht. Damit sollen Unternehmen eine Vielzahl von Anwendungen realisieren können.

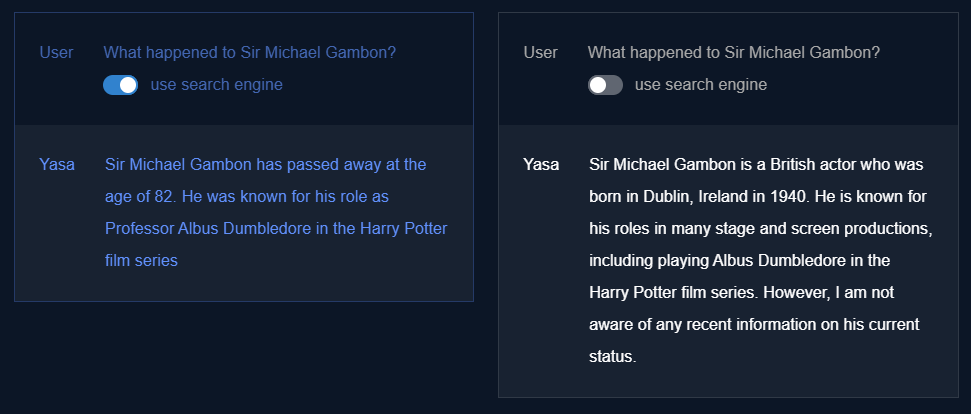

Yasa-1 unterstützt 20 Sprachen und kann Antworten mit Kontext aus dem Internet über kommerzielle Suchmaschinen liefern, lange Kontextdokumente mit bis zu 100.000 Token verarbeiten (24K ist Standard) und Code ausführen. Claude 2 von Anthropic kann ebenfalls 100.000 Token verarbeiten, aber Reka AI will bei vergleichbarer Genauigkeit bis zu achtmal schneller sein. Das leistungsfähigste GPT-4-Modell von OpenAI kann 32.000 Token verarbeiten.

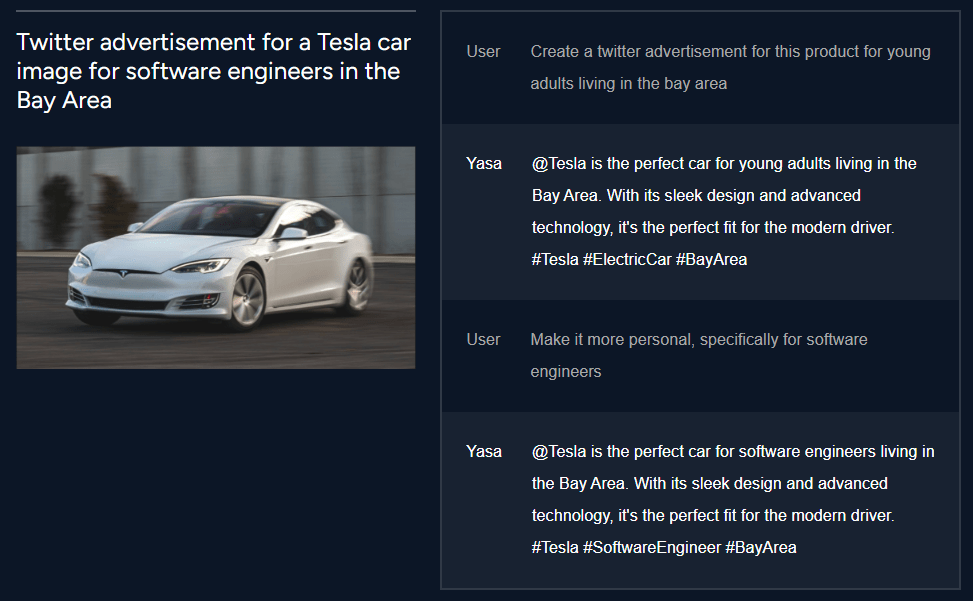

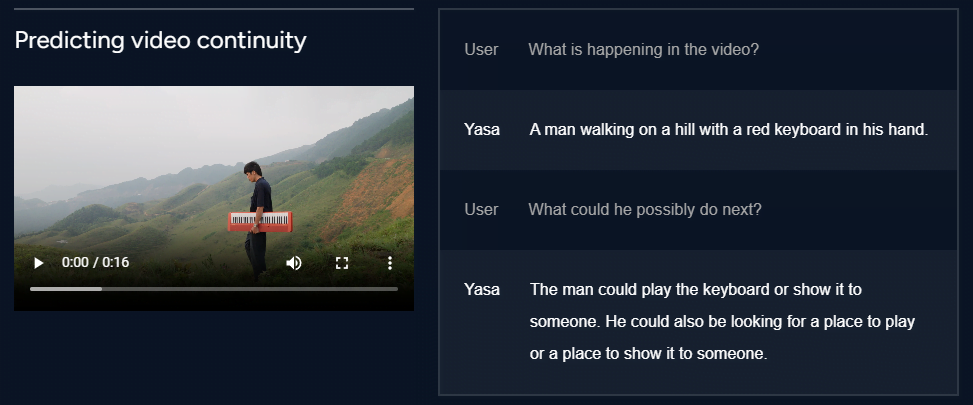

Die multimodalen Fähigkeiten von Yasa-1 ermöglichen es dem Benutzer, textbasierte Eingabeaufforderungen mit Multimedia-Dateien zu kombinieren, um spezifischere Antworten zu erhalten. So kann der Assistent beispielsweise ein Bild verwenden, um einen Social-Media-Post zu erstellen, der ein Produkt bewirbt, oder um einen bestimmten Ton und seine Quelle zu identifizieren.

Der Assistent kann auch verstehen, was in einem Video passiert, einschließlich der Themen, über die gesprochen wird, und die nächsten möglichen Aktionen in einem Video vorhersagen.

Zusätzlich zu seinen multimodalen Fähigkeiten unterstützt Yasa-1 Programmieraufgaben und kann aktiv Code ausführen, um arithmetische Operationen durchzuführen, Tabellen zu analysieren oder Visualisierungen für bestimmte Datenpunkte zu erstellen.

Wie bei allen großen Sprachmodellen gilt für Yasa-1, dass das Modell Unsinn erzählen kann und man sich daher gerade bei kritischen Ratschlägen nicht ausschließlich auf das Modell verlassen sollte, schreibt Reka.

Zudem könne der Assistent zwar hervorragende Beschreibungen von Bildern, Videos oder Audioinhalten liefern, sei aber ohne weitere Anpassungen nur eingeschränkt in der Lage, komplexe Details in diesen Medien zu erkennen.

Reka plant, den Zugang zu Yasa-1 in den kommenden Wochen auf weitere Unternehmen auszuweiten. Ziel ist es, die Fähigkeiten des Agenten zu verbessern und gleichzeitig seine Einschränkungen zu beheben.

Reka stellte sich Ende Juni 2023 erstmals der Öffentlichkeit vor. Es ist mit 58 Millionen Dollar finanziert. Das Start-up konzentriert sich nach eigenen Angaben auf universelle Intelligenz, universelle multimodale und mehrsprachige Agenten, selbstverbessernde KI und Modelleffizienz.