Forscher zeigen, dass sich die Leistungsfähigkeit einer KI schon vor ihrem Training einschätzen lässt. Das könnte die automatische Suche nach besseren Architekturen drastisch beschleunigen.

Auf der Suche nach leistungsstärkeren und energieeffizienteren Bildanalyse-KIs setzen Forscher heute auf verschiedene automatisierte Suchmethoden. Die sogenannte Neuronale-Architektur-Suche (NAS) funktioniert in seiner einfachsten Variante so: Eine Software designt, trainiert und testet unzählige KI-Architekturvarianten eigenständig. Anschließend wählen Menschen die beste Architektur für die gewünschte Aufgabe.

Dieser kombinatorische Ansatz ist rechenintensiv und zeitaufwendig, da jede KI trainiert werden muss, bevor ihre Leistungsfähigkeit beurteilt werden kann. Der Suchraum ist zudem gigantisch – für komplexe Architekturen kann es schnell so viele Möglichkeiten geben, einzelne Module zusammenzusetzen, dass die Methode nicht mehr praktikabel ist.

Forscher setzen daher bei der Suche nach neuen Architekturen auf KI: Die übernimmt die Suchaufgabe und designt, trainiert und testet die Architekturen wie die Software. Anders als diese lernt sie jedoch dabei, welche Varianten besonders gut abschneiden und kann so den Suchraum begrenzen.

Das macht die Suche effizienter, erfordert aber immer noch, dass jedes entworfene Netzwerk trainiert wird.

Forscher der Universität Edinburgh stellen jetzt eine Methode vor, mit der bei der Architektursuche ein großer Teil der entworfenen Netzwerke bereits vor dem KI-Training ausgeschlossen werden können.

Ein Blick in das Netzwerk reicht

Den Forschern ist es gelungen, die Leistungsfähigkeit von über 1.000 verschiedenen Architekturen für Bildanalyse-KIs ohne Training vorherzusagen.

Um erfolgreich Bilder erkennen zu können, muss ein Netzwerk die unterschiedlichen im Bild vorhandenen Daten auseinanderhalten können. Ob das jeweilige Netzwerk dazu in der Lage ist, lasse sich schon direkt nach der Initialisierung zeigen – also nach der ersten Aktivierung des Netzwerks mit dem ersten Satz an Trainingsdaten, schreiben die Forscher.

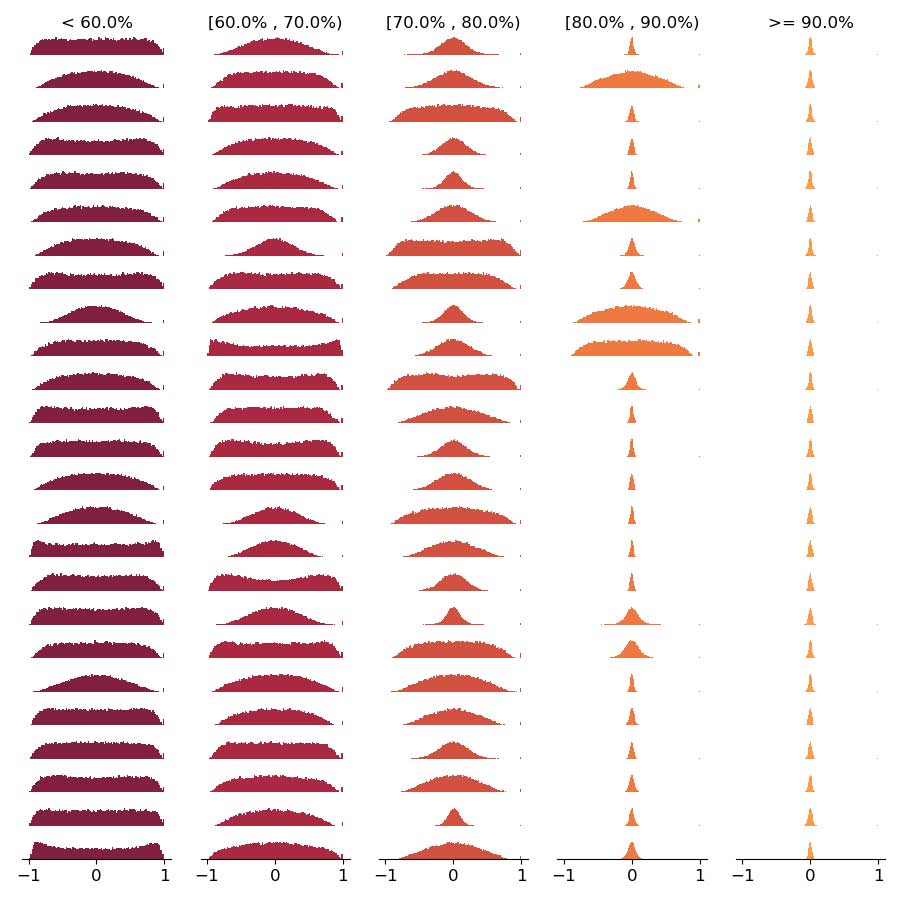

Sie initialisieren daher jedes Netzwerk mit 256 Beispielbildern. Das erzeugt Veränderungen in den Gewichtungen der Neuronen.

Anschließend nehmen die Forscher in jeder Schicht des Netzwerks Stichproben und überprüfen, ob unterschiedliche Datenpunkte tatsächlich unterschiedliche Operatoren ansprechen oder sich Kopplungen zwischen zwei oder mehr eigentlich unterschiedlichen Datenpunkten in den Operatoren wiederfinden.

Je mehr dieser Kopplungen existieren, desto weniger Stellschrauben gibt es im Netzwerk und desto unflexibler reagiert es auf unterschiedliche Daten – und lernt somit schlechter.

Architektursuche ohne Training

Die Forscher haben ihre These mit KI-Architekturen einer KI-Sammlung überprüft. Tatsächlich zeigt sich, dass Netzwerke mit starken Kopplungen nach dem Training schlechter abschneiden.

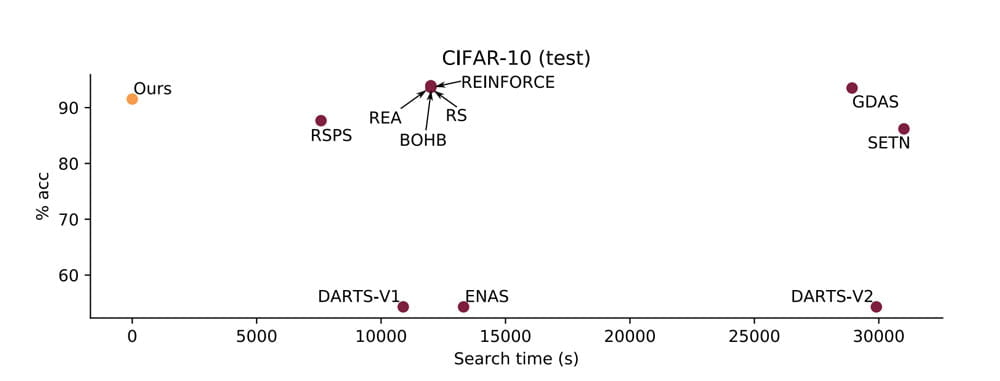

Die neue Methode kann die Leistungsfähigkeit von 1.000 verschiedenen Architekturen auf einer Nvidia GTX 1080 Ti in 1,7 Sekunden einschätzen. Bisherige Methoden brauchen dafür mehrere Stunden.

Die Methode ist bis zu 18.000 Mal schneller als andere Suchmethoden, die mit vorgezogenem KI-Training arbeiten bei einem ähnlichen oder besseren Ergebnis. Bisher funktioniert sie jedoch nur für gefaltete neuronale Netzwerke für die Bildanalyse - und in manchen Fällen liegen andere Methoden noch vorne.

Doch schon jetzt könnten so große Teile von Netzwerken, die unter der gewünschten Leistungsfähigkeit liegen, schnell aussortiert werden. Die übriggebliebenen Varianten könnten dann vollständig trainiert und verglichen werden.

Die Forscher hoffen, dass so die Suche nach besseren Architekturen günstiger und damit besser verfügbar wird, was wiederum die KI-Entwicklung insgesamt beschleunigen dürfte.

Via: Arxiv