Make-a-Video3D: Meta generiert 3D-Szenen aus Text

Metas Make-A-Video3D geniert dynamische 3D-Szenen aus Textbeschreibungen, die auch in Echtzeit in 3D-Engines laufen.

Nach Text und Bild sollen generative KI-Modelle bald Videos und 3D-Objekte synthetisieren. Modelle wie Make-a-Video, Imagen Video, Phenaki für Video und 3DiM, Dreamfusion oder MCC für 3D zeigen mögliche Ansätze und erzeugen teils beeindruckende Ergebnisse.

Meta zeigt nun eine Methode, die Video und 3D verbindet: Make-A-Video3D (MAV3D) ist ein generatives KI-Modell, das aus Textbeschreibungen dreidimensionale dynamische Szenen erzeugt.

Metas Make-A-Video3D setzt auf NeRFs

Im September 2022 zeigte Google Dreamfusion, ein KI-Modell, das aus Textbeschreibungen 3D-Repräsentationen in Form von Neural Radiance Fields (NeRFs) lernt. Google kombinierte dafür NeRFs mit dem großen Bildmodell Imagen: Es generiert zu Text passende Bilder, die als Lernsignal für das NeRF dienen.

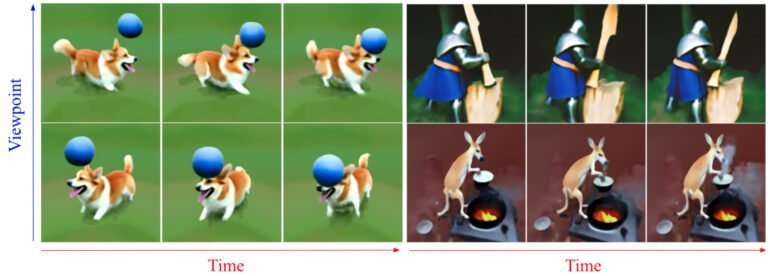

Einen ähnlichen Ansatz verfolgt Meta mit MAV3D: Eine für dynamische Szenen geeignete NeRF-Variante (HexPlane) generiert aus einer Sequenz von Kamerapositionen eine Sequenz von Bildern.

Diese werden als Video zusammen mit einem Textprompt an Metas Videomodell Make-A-Video (MAV) übergeben, das die von HexPlane gelieferten Inhalte anhand des Textprompts und weiterer Parameter bewertet.

Die Bewertung dient dann als Lernsignal für das NeRF, das seine Parameter anpasst. In mehreren Durchgängen lernt es so eine dem Text entsprechende Repräsentation.

MAV3D-Inhalte können in Echtzeit gerendert werden

So erzeugt MAV3D 3D-Darstellungen einer singenden Katze, eines Eis essenden Pandababys oder eines Saxophon spielenden Eichhörnchens. Ein qualitativ vergleichbares Modell gibt es derzeit nicht, die von Meta gezeigten Ergebnisse stimmen eindeutig mit den Textprompts überein.

Video: Meta

Das gelernte HexPlane-Modell könne zudem in animierte Meshes umgewandelt werden, so das Team. Das Ergebnis ließe sich dann in jeder gängigen 3D-Engine in Echtzeit rendern - und wäre damit für Anwendungen in der virtuellen Realität oder in klassischen Videospielen geeignet. Allerdings sei das Verfahren derzeit noch ineffizient und das Team wolle es daher verbessern - ebenso wie die Auflösung der Szenen.

Weitere Video-Beispiele und Renderings gibt es auf der MAV3D-Projektseite. Das Modell und der Code sind nicht verfügbar.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.