Shap-E ist OpenAIs bisher schnellstes Text-zu-3D-Modell

OpenAI beherrscht die Medien mit ChatGPT, aber das Unternehmen forscht auch an anderen generativen KI-Modellen. Ein neues Paper zeigt ein Text-zu-3D-Modell.

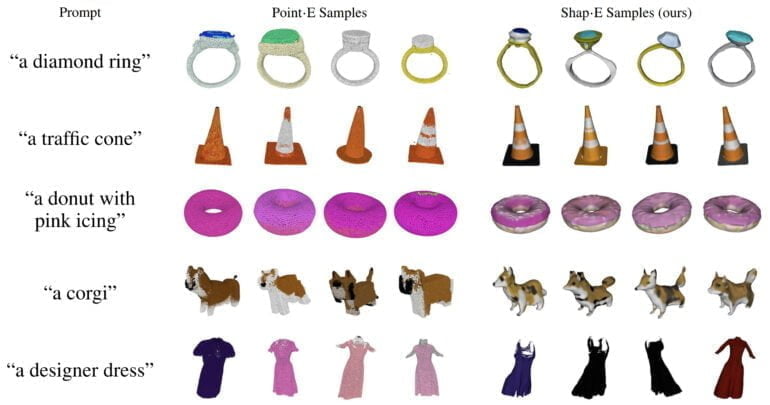

Ende 2022 präsentierte OpenAI Point-E, ein generatives KI-Modell für Text-zu-3D, das angesichts des enormen Erfolgs von ChatGPT im selben Monat kaum Beachtung fand. Das lag auch daran, dass Point-E keine besonders beeindruckenden Ergebnisse lieferte.

Denn OpenAI versuchte mit Point-E ein besonders schnelles Text-zu-3D-Modell zu liefern und setzte dabei auf Punktwolken. Knapp ein halbes Jahr später präsentieren die Forschenden des Unternehmens nun mit Shap-E einen direkten Nachfolger.

Shap-E ist extrem schnell und ein bisschen besser

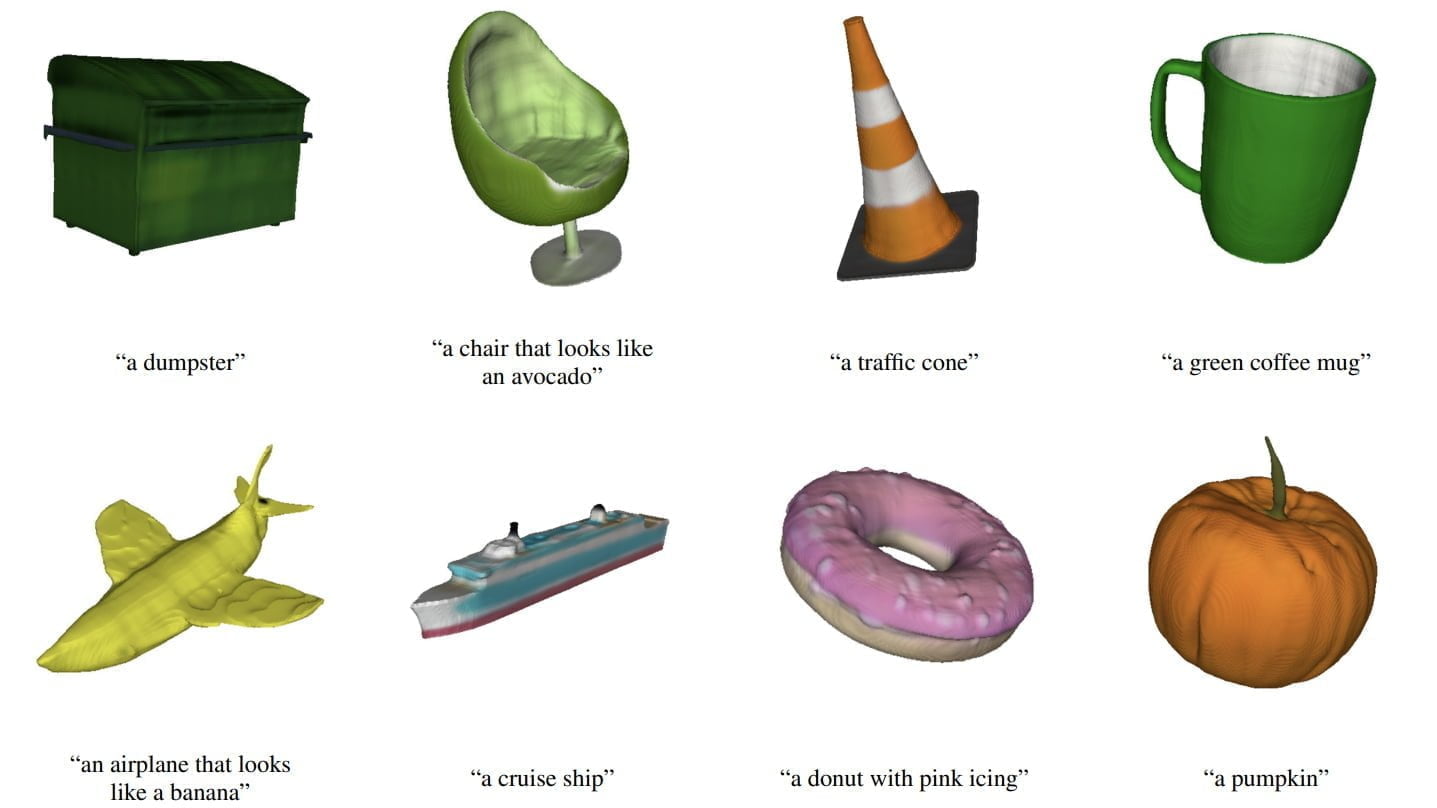

Im Gegensatz zu Point-E erzeugt Shap-E keine Punktewolke, sondern direkt Parameter impliziter Funktionen, die sowohl als texturierte Meshes als auch als NeRFs gerendert werden können. Im Wesentlichen wandelt ein Encoder Text- oder Bildeingaben in diese Funktionen um, und ein Diffusionsmodell erzeugt daraus die gewünschte 3D-Darstellung.

Die Qualität dieser Darstellungen bleibt jedoch wie schon beim Vorgänger teilweise deutlich hinter den Alternativen wie Dreamfusion, Dreamfields, Magic3D, Dream3D oder CLIP-Mesh zurück. Während jedoch auf einer Nvidia v100 GPU CLIP-Mesh 17 Minuten, Dreamfusion 12 Stunden und Dreamfields sogar 200 Stunden für ein Modell benötigt, benötigt Shap-E mit Texteingabe nur 13 Sekunden und mit Bildinput nur eine Minute.

Shap-E lässt sich mit DreamFusion kombinieren

Laut OpenAI unterstreichen die Ergebnisse "das Potenzial der Erstellung impliziter Darstellungen, insbesondere in Bereichen wie 3D, wo sie mehr Flexibilität bieten als explizite Darstellungen".

Shap-E weist jedoch auch zahlreiche Einschränkungen auf, etwa bei der Zuweisung mehrerer Attribute zu einem Objekt oder bei der Darstellung der korrekten Anzahl von Objekten. Das Team führt diese Fehler auf die begrenzten Trainingsdaten zurück und glaubt, dass sie durch das Sammeln und Erzeugen größerer, beschrifteter 3D-Datensätze verringert werden könnten. Außerdem ist die Qualität der Objekte begrenzt.

Um bessere Ergebnisse zu erzielen, könnte Shap-E jedoch mit anderen optimierungsbasierten generativen 3D-Techniken kombiniert werden. So zeigt das Team, dass ein Shap-E-Modell als NeRF von DreamFusion verfeinert werden kann.

Sollte OpenAI eine passende Architektur gefunden haben, dürfte diese dann skaliert werden. Ob das Shap-E ist, wird sich zeigen müssen, doch mit Projekten wie Objaverse entstehen große Datenbanken für gelabelte 3D-Daten.

Den Code und das Modell gibt es auf GitHub.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.