ChatGPT erzielt in 9 von 32 Hochschulkursen gleiche oder bessere Noten als Studierende

Eine Studie bestätigt, was als Anekdote immer wieder durchs Netz geistert: ChatGPT kann akademische Leistungen erreichen, die mit denen von Studierenden vergleichbar sind.

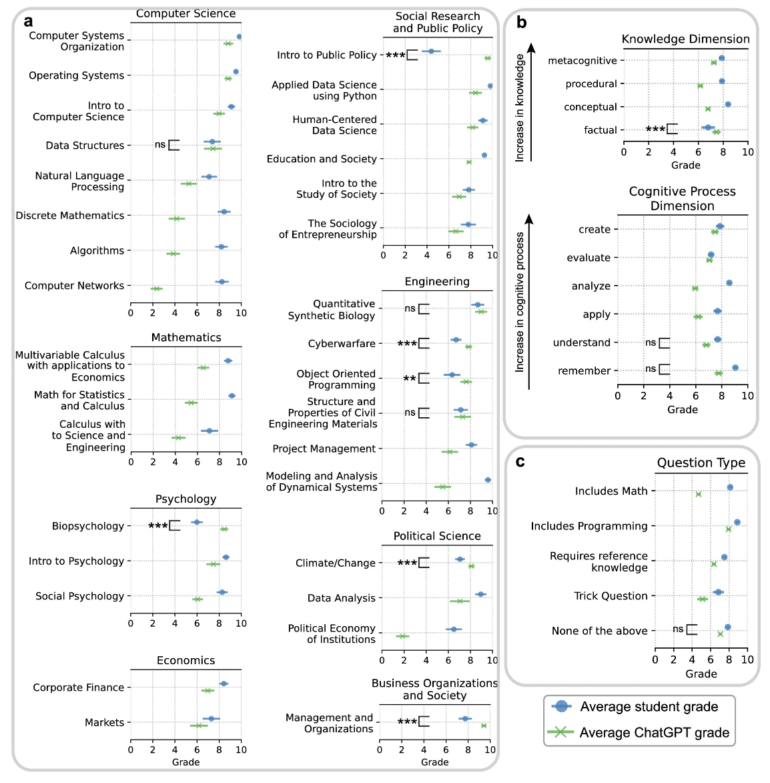

Eine in Scientific Reports veröffentlichte Studie verglich die Leistung von Studierenden mit der von ChatGPT bei den gleichen Aufgaben. In einem Experiment wurden zunächst Dozenten der New York University Abu Dhabi (NYUAD) gebeten, zehn Fragen aus ihren jeweiligen Vorlesungen zusammen mit drei zufällig ausgewählten Studierendenantworten zu jeder Frage zur Verfügung zu stellen.

Die Forscherinnen und Forscher verwendeten dann ChatGPT, um drei verschiedene Antworten auf jede Frage zu generieren. Die Fragen wurden direkt in ChatGPT eingegeben, ohne zusätzlichen Kontext im Prompt.

Aus der Studie geht nicht hervor, ob GPT-3.5 oder GPT-4 verwendet wurde, obwohl in den Referenzen auf GPT-4 verwiesen wird. Falls GPT-3.5 verwendet wurde, sollten die generierten KI-Antworten noch deutlich ausbaufähig sein.

ChatGPT ist in 9 von 32 Fächern mindestens auf dem gleichen Niveau

Nach der Generierung der ChatGPT-Antworten wurden diese mit den Antworten der Studierenden gemischt und von drei verschiedenen Gutachtern bewertet. ChatGPT erzielte in neun von 32 Fächern vergleichbare oder bessere Ergebnisse als die menschlichen Studierenden. Diese neun Fächer waren

- Data Structures

- Introduction to Public Policy

- Quantitative Synthetic Biology

- Cyberwarfare

- Object Oriented Programming

- Structure and Properties of Civil Engineering Materials

- Biopsychology

- Climate/Change

- Management and Organizations

Die KI überzeugte primär in Bereichen, in denen umfangreiches Faktenwissen gefragt war. Im Kurs "Introduction to Public Policy" erzielte ChatGPT im Durchschnitt mehr als doppelt so viele Punkte wie die Studierenden. Bei mathematischen und wirtschaftswissenschaftlichen Aufgaben, die höhere Anforderungen an kognitive Prozesse stellten, hatten die Studierenden hingegen die Nase vorn.

KI-Text-Detektoren versagen

Die Forschenden testen auch, ob sie mit dem KI-Textklassifizierer von OpenAI, den die Firma wegen Unzuverlässigkeit bereits zurückgezogen hat, und mit GPTZero zuverlässig menschliche von maschinellen Texten unterscheiden können.

Das OpenAI-Tool klassifizierte fünf Prozent der menschlichen Texte fälschlicherweise als Maschinentexte, bei GPTZero waren es sogar 18 Prozent. Ein katastrophales Ergebnis, bedenkt man die möglichen Konsequenzen für die betroffenen Studierenden, die fälschlicherweise des Betrugs bezichtigt werden könnten.

Umgekehrt erkannte das OpenAI-Tool 49 Prozent der maschinell erstellten Texte als menschlich, bei GPTZero waren es 32 Prozent. Die Durchlässigkeit für mögliche KI-Texte wäre also bei beiden Fällen weiter hoch.

Dieses Ergebnis gewinnt durch eine ebenfalls im Rahmen der Studie durchgeführte Befragung von 1.601 Studierenden und Lehrenden in Brasilien, Indien, Japan, den USA und Großbritannien an Bedeutung: 74 Prozent der Studierenden wollen ChatGPT für ihre Arbeiten nutzen. 70 Prozent der Lehrenden wollen diese Nutzung als Plagiat melden, wenn sie auffällt.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.