KI-Tool "StableDrag" verdreht der Mona Lisa den Kopf

Schon jetzt bieten KI-Bildgeneratoren durch Inpainting ein mächtiges Werkzeug, Bildinhalte zu verändern. Mit der punktbasierten Bearbeitung werden Anpassungen noch einfacher.

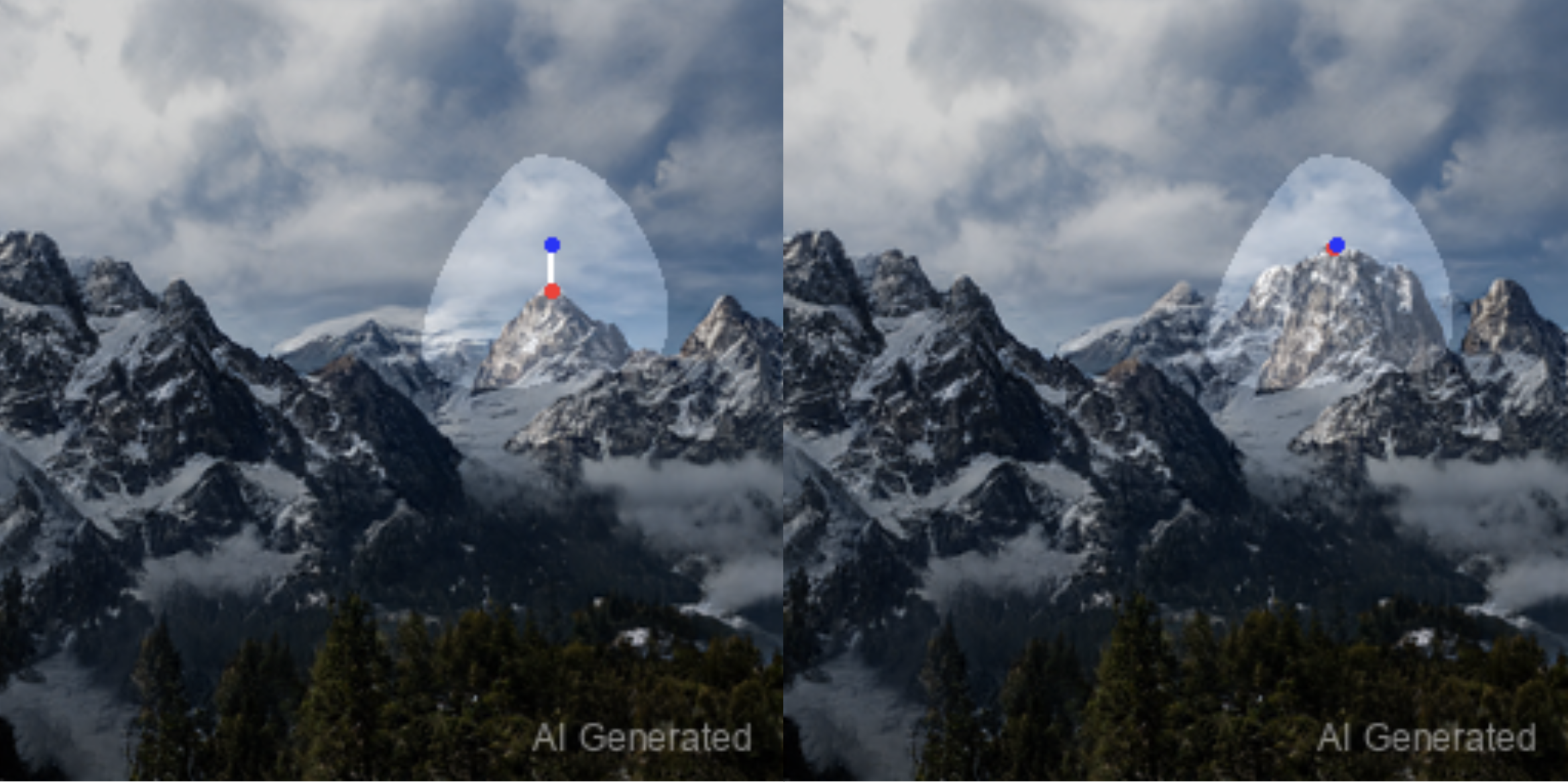

Forschende der Universität Nanjing und von Tencent haben eine neue punktbasierte Bildbearbeitungsmethode namens StableDrag entwickelt. Mit dieser Methode können Elemente einfach an eine neue Position im Bild verschoben werden, wobei auch die korrekte Einhaltung der Perspektive berücksichtigt wird.

In den letzten Jahren hat diese Art der KI-gestützten Bildverarbeitung große Fortschritte gemacht, insbesondere durch Modelle wie FreeDrag, DragDiffusion und Drag-GAN. StableDrag baut auf diesen auf und existiert in einer GAN- und einer diffusionsbasierten Variante. Die neue Methode liefert deutlich bessere Ergebnisse, was sich auch in Benchmarks widerspiegelt.

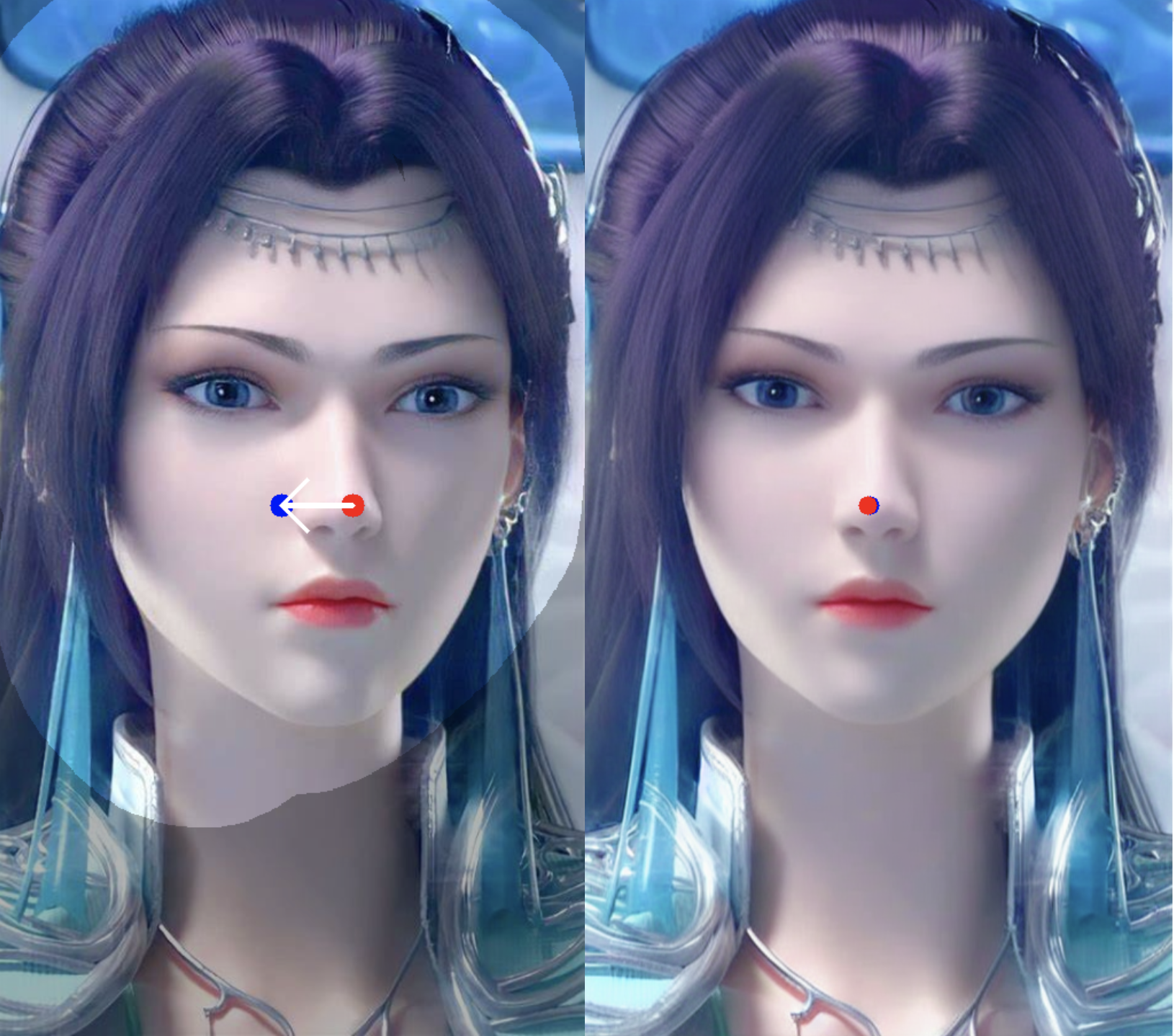

Ein anschauliches Beispiel ist die Veränderung der Blickrichtung der "Mona Lisa", indem man ihre Nase etwas weiter nach rechts verschiebt (siehe Titelbild). Links ist das Eingabebild mit Quell- (rot) und Zielpunkt (blau) zu sehen, in der Mitte das Ergebnis von DragDiffusion, rechts StableDrag-Diff.

Gleichbleibend gute Ergebnisse unabhängig vom Motiv

Dabei spielt es keine Rolle, ob StableDrag mit realen Fotos, Illustrationen oder anderen KI-Bildern gefüttert wird. Ein sinnvolles Anwendungsbeispiel ist die Bearbeitung menschlicher Gesichter, aber auch bei Motiven wie Autos, Landschaften oder Tieren bewährt sich das Werkzeug.

Die wichtigsten Neuerungen von StableDrag sind eine diskriminative Methode zur Punktverfolgung und eine konfidenzbasierte Strategie zur Verbesserung der Bewegungssteuerung, erklären die Forscher in ihrem Artikel. Ersteres ermögliche es, die aktualisierten Zielpunkte genau zu lokalisieren, während Letzteres sicherstelle, dass die optimierten Bilddaten in jedem Bearbeitungsschritt von höchstmöglicher Qualität bleiben.

Der Konfidenzwert aus dem Tracking dient dabei zur Bewertung der Bearbeitungsqualität - fällt er unter einen Schwellenwert, werden die ursprünglichen Bildmerkmale an den Zielpunkten als Referenz genutzt, bis die Konfidenz sich erholt hat. So werde verhindert, dass sich die Bildinhalte zu weit vom Original entfernen, ohne die Bearbeitungsmöglichkeiten einzuschränken. Die Entwickler:innen von StableDrag kündigen an, den Code bald frei zugänglich zu machen.

Nächste Stufe der KI-Bildverarbeitung

Während die reine Generierung künstlicher Bilder aus Textprompts in den letzten zwei Jahren große Fortschritte gemacht hat und selbst täuschend echte KI-Fotos für Modelle wie Midjourney v6, Ideogram oder SDXL keine Herausforderung mehr darstellen, steckt die Bildmanipulation im Vergleich dazu noch in den Kinderschuhen.

Mit der Inpainting-Funktion lassen sich in einigen Modellen (Midjourney, Adobe Firefly, DALL-E 3) zwar Bereiche auswählen und mit weiteren Texteingaben verändern, eine präzisere Bearbeitung verspricht jedoch das Verschieben von Punkten in StableDrag.

Einen anderen Ansatz verfolgt Apple mit MGIE, das umfassende Bildmanipulationen wie das Hinzufügen, Entfernen oder Verändern von Objekten per Textprompt auch ohne markierte Bereiche erlaubt.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.