RawNeRF: Googles neue Bild-KI bringt Licht ins Dunkel

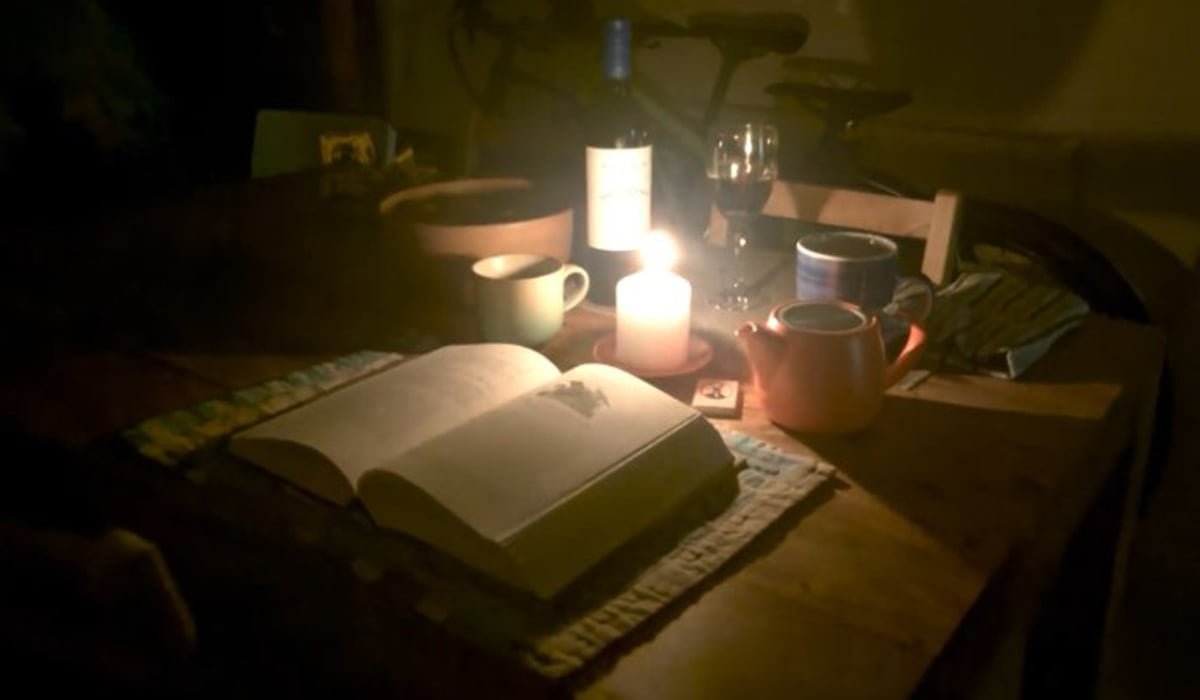

Mit RawNeRF stellt Google ein neues Werkzeug für die Bildsynthese vor, das aus dunklen 2D-Fotos gut beleuchtete 3D-Szenen generieren kann.

Im Sommer 2020 stellte ein Forschungsteam bei Google erstmals „Neural Radiance Fields“ (NeRF) vor: Ein KI-System erkennt in einem Bild, an welchen Stellen Lichtstrahlen enden. Davon ausgehend, kann es aus mehreren Fotos derselben 2D-Szene automatisiert eine 3D-Szene generieren.

In den letzten zwei Jahren zeigten Google-Teams regelmäßig neue Anwendungsszenarien für NeRFs, etwa für Google Maps Immersive View oder um eine Art Street View 3D anhand von Straßenbildern zu rendern.

RawNeRF bringt Licht ins Dunkle

Mit RawNeRF stellt das Forschungsteam rund um KI-Forscher Ben Mildenhall jetzt ein NeRF vor, das mit RAW-Kameradaten trainiert werden kann. Diese Bilddaten enthalten den vollen Dynamikbereich einer Szene.

Laut des Forschungsteams kann RawNERF dank des RAW-Daten-Trainings "Szenen aus extrem verrauschten Bildern rekonstruieren, die im Halbdunkel aufgenommen wurden." Zudem können nachträglich der Kamerastandpunkt, der Fokus, die Belichtung und das Tonemapping geändert werden.

"Durch das Training direkt auf Rohdaten wird RawNeRF zu einem Multibild-Denoiser, der Informationen aus Dutzenden oder Hunderten von Eingangsbildern kombinieren kann", schreibt das Team.

If you're still at CVPR and have the stamina to make it through another poster session, check out RawNeRF tomorrow morning! We exploit the fact that NeRF is surprisingly robust to image noise to reconstruct scenes directly from raw HDR sensor data. pic.twitter.com/CEeXWSmt9Q

— Ben Mildenhall (@BenMildenhall) June 24, 2022

Herunterladen könnt ihr RawNeRF bei Github. Dort findet ihr auch Mip-NeRF 360, das fotorealistische 3D-Szenen aus 360-Grad-Aufnahmen rendern kann, sowie Ref-NeRF.

Mehr über Künstliche Intelligenz für Computergrafik gibt’s in unserem DEEP MINDS KI-Podcast zum Thema. Ab Minute 50 sprechen wir mit Thomas Müller von Nvidia über die Funktion und das Potenzial von NeRFs.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.