KI-Universalübersetzer: Meta knackt neue Bestmarke

Metas neuer KI-Übersetzer knackt Bestwerte im wichtigen WMT2021-Benchmark. Das ist bemerkenswert, weil der Rekord erstmals von einem Multisprachen-KI-Modell erreicht wird. Das Unternehmen wähnt sich auf dem Weg zu einem leistungsfähigen universellen Übersetzungssystem.

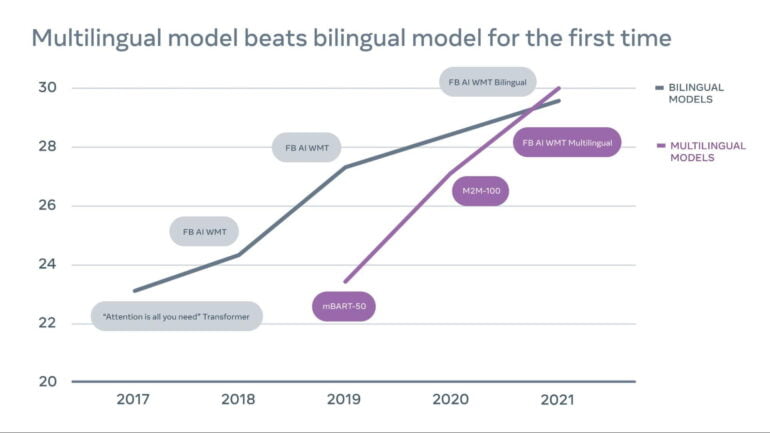

Metas (ehemals Facebooks) KI-Abteilung arbeitet seit mehreren Jahren an KI-Übersetzungen. Bereits 2018 knackten Facebook KI-Forschende einen Meilenstein bei der Übersetzung mit unüberwacht trainierten Modellen. Letztes Jahr zeigten die Forscher und Forscherinnen ein multilinguales KI-Modell, das 100 Sprachen übersetzen kann.

Doch keines der Allzweck-Übersetzungssysteme erreichte die Qualität bilingual trainierter KI-Modelle, die etwa ausschließlich mit englischen und deutschen Übersetzungsbeispielen trainiert werden. In der maschinellen Übersetzung werden daher für jede Sprache jeweils eigene Modelle trainiert und eingesetzt.

Multilinguale KI-Übersetzer für Facebook gesucht

Künstliche Intelligenz, die direkt mit mehreren Sprachen trainiert wird, verspricht jedoch theoretisch bessere Übersetzungsleistungen für häufige und ebenso seltene Sprachen. So soll ein multimodales Modell etwa gemeinsame Muster in allen Sprachen erlernen und dieses Wissen für bessere Übersetzungen nutzen.

Die Allzweckmodelle eignen sich daher besonders für Sprachen, von denen wenige Übersetzungsbeispiele oder überhaupt wenige Texte für das Training existieren. Die maschinelle Übersetzung solcher sogenannten "Low-Resource Languages" ist für das soziale Netzwerk Facebook von großem Interesse, da dort täglich Milliarden Menschen in hunderten verschiedenen Sprachen posten.

Im diesjährigen WMT2021-Benchmark, einem der wichtigsten KI-Übersetzungswettbewerbe, erreicht nun Metas multilinguales KI-Modell das erste Mal Bestwerte und übertrifft in mehreren Kategorien die besten bilingualen Modelle.

Metas Multisprachen-KI-Modell steht an der Spitze

Metas KI-Übersetzer übersetzt Englisch von und nach Tschechisch, Deutsch, Isländisch, Hausa, Japanisch, Russisch und Chinesisch. Laut Meta liegt das KI-System in den meisten dieser Sprachen vor allen anderen Systemen in der WMT2021-Bestenliste.

Es verbessert die Übersetzungsleistung im Vergleich zu den Gewinnern des WMT2020-Wettbewerbs um 2.0 BLEU-Punkte. Lediglich bei der Übersetzung von und nach Japanisch und Chinesisch hängt Metas KI-System knapp hinterher.

Laut Meta zeige der Erfolg, dass multilinguale Modelle tatsächlich die Zukunft maschineller Übersetzung seien. Möglich ist der Erfolg durch eine Reihe Verbesserungen im KI-Training und der Modell-Architektur.

So setzt Meta neben Übersetzungspaaren auch auf große Mengen einsprachigen Texts und vergrößert das als Grundlage genutzte KI-Modell von 15 Milliarden auf 52 Milliarden Parameter. Die zusätzlichen Parameter tragen den größeren Datenmengen Rechnung.

Meta glaubt an das „universelle Übersetzungssystem“

Für die Architektur setzt Meta auf ein Mixture-of-Experts-Modell (MoE), in dem einzelne Abschnitte im Netz als Experten für bestimmte Aufgaben und Sprachen dienen. Auf diese Methode setzen ebenso Googles Übersetzungs-KI M4, Googles 1,6 Billionen-Parameter großer Switch Transformer und das chinesische 1,75 Billionen Parameter große Wu Dao 2.0.

Video: Meta

"Wir sind davon überzeugt, dass unser Erfolg beim WMT 2021 zeigt, dass multilinguale Übersetzer ein wichtiger Schritt auf dem Weg zum universellen Übersetzungssystem sind", so Meta. Als Nächstes wollen die Forschenden sich seltenen Sprachen widmen und neue Technologien entwickeln, die auch für diese Sprachen ein vergleichbar gutes Ergebnis ermöglichen.

Metas aktuelle Multisprach-KI-Modelle gibt es bei Github.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.