Entkleidung per KI-Befehl: Experte befürchtet neuen "DeepNude-Skandal"

Während KI-Bildgeneratoren hauptsächlich für kreative Zwecke genutzt werden, öffnen sie auch die Türen für gefälschte Nacktfotos. Ein Experte möchte die Öffentlichkeit darüber aufklären.

Mit großer Macht kommt große Verantwortung - ein Satz, der auch auf KI-Bildgeneratoren zutrifft. Denn eng mit ihnen verknüpft sind Deepfakes, die wir an dieser Stelle als mit KI erzeugte synthetische visuelle Medien für ethisch fragwürdige oder kriminelle Zwecke definieren.

Die Geschichte der Deepfakes zeigt, dass öffentlichkeitswirksame KI-Bildgeneratoren in pornografischen Bildern und Videos ohne Zustimmung ihren Ursprung fanden. Gerade Prominente, zu denen viel Bildmaterial im Internet existiert, geraten ins Visier von Deepfake-Ersteller:innen.

Aber mit den neuesten Tools kann es jeden und jede erwischen - dafür reicht ein einzelnes Bild als Vorlage, wie der KI-Künstler Denis Shiryaev zeigt.

Entkleidung per KI-Befehl

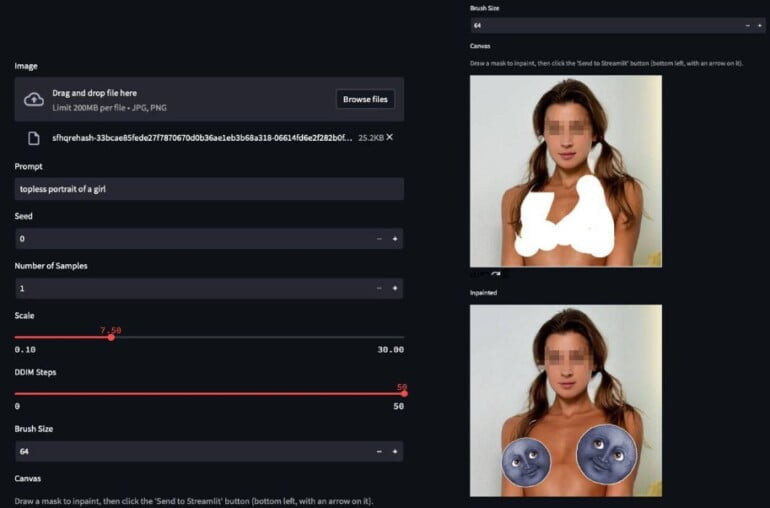

Technologische Errungenschaften wie img2img ("Bild zu Bild") oder Inpainting, d. h. das Ersetzen bestimmter Bildinhalte durch eigenes Bildmaterial, machen es noch einfacher, Deepfakes zu erstellen. Deshalb müssen wir darüber sprechen, was Menschen mit schlechten Absichten mit der derzeit verfügbaren Technologie anstellen können.

Wer von Deepfakes hört, denkt wahrscheinlich zuerst an unterhaltsame Videos wie das der gefälschten Margot Robbie oder Tom Cruise auf TikTok oder an die mögliche Verbreitung von Fehlinformationen. Intim wird es, wenn Menschen virtuell entkleidet werden und ihre Unterwäsche durch realistisch aussehende Geschlechtsmerkmale ersetzt wird.

Eine Software namens DeepNude war dazu schon vor drei Jahren in der Lage. Das Programm machte Schlagzeilen und verbreitete sich schnell, wurde aufgrund heftiger Kritik jedoch ebenso schnell wieder eingestellt.

Die damalige Begründung der Betreiber: "Die Welt ist noch nicht bereit." Ob die Welt im Jahr 2022 bereit ist, sei mal dahingestellt, doch die Technik macht ungebremst Fortschritte.

Bild-KI-Anbieter verbieten NSFW-Inhalte, aber diese Verbote wirken nur eingeschränkt

Die Betreiber von DALL-E 2, Midjourney oder Stable Diffusion kennen die Risiken und ergreifen zumindest auf ihren eigenen Plattformen Vorsichtsmaßnahmen, etwa durch Wortfilter und dauerhafte Sperren bei wiederholten Verstößen gegen Inhalterichtlinen.

"Keine Inhalte für Erwachsene oder blutige Szenen. Bitte vermeiden Sie visuell schockierende oder verstörende Inhalte. Wir werden einige Texteingaben automatisch blockieren", heißt es etwa in den Nutzungsbedingungen von Midjourney.

Auch Stability AI untersagt für seinen Stable Diffusion Web-Service DreamStudio die Generierung von "NSFW, anzüglichem oder sexuellem Material". Die Limitierungen des Open-Source-Modells lesen sich jedoch etwas anders: Verboten sind nur sexuelle Inhalte ohne Zustimmung der Personen, die diese Inhalte sehen könnten.

Die Einhaltung von Regeln für das Open-Source-Modell lässt sich zudem nicht kontrollieren. Ebenso wenig ist das bei anderen frei verfügbaren generativen Bild-KIs möglich, die nicht so mächtig sein müssen wie die bekannten Modelle, die aber gerade für spezifische Anwendungsfälle wie eben Nacktheit wohl mit überschaubarem Aufwand feinjustiert werden könnten. DeepNude gelang das bereits vor drei Jahren.

Shiryaev erwartet neuen DeepNude-Skandal

Denis Shiryaev, CEO des KI-Werkzeugkastens neural.love und als KI-Künstler bekannt für seine modernisierten Retro-Videos, wittert bei den Möglichkeiten von Stable Diffusion gar einen neuen "DeepNude-Skandal", sobald die Öffentlichkeit herausfinde, wie leicht es sei, ein Foto mit Bekleidung in ein Nacktfoto umzuwandeln.

Er demonstriert KI-generierte Nacktheit am Beispiel von Stable Diffusion. Dafür nimmt er einen Verstoß gegen die Richtlinien des Open-Source-Modells in Kauf.

Die heutige Software sei zudem deutlich einfacher zu benutzen als das GAN-basierte DeepNude damals. Prinzipiell ist also jede Person gefährdet, von der auch nur ein Foto im Internet oder auf einer Festplatte verfügbar ist, durch gefälschte Nacktfotos verleumdet zu werden.

"Ich glaube, es ist besser, die breite Masse an Menschen (außerhalb der KI-Industrie) darauf vorzubereiten, dass nicht mehr alles, was sie auf Fotos sehen, echt ist", schreibt Shiryaev auf Twitter.

I believe it is better to prepare the General Audience (outside of the AI industry bubble) that not all that they see in photos is real anymore since almost anyone can reproduce those results quite easily and fast (much easier to use than the original GAN-based DeepNude algo). pic.twitter.com/GnIyDCw4rA

— Denis Shiryaev 💙💛 (@literallydenis) October 20, 2022

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.