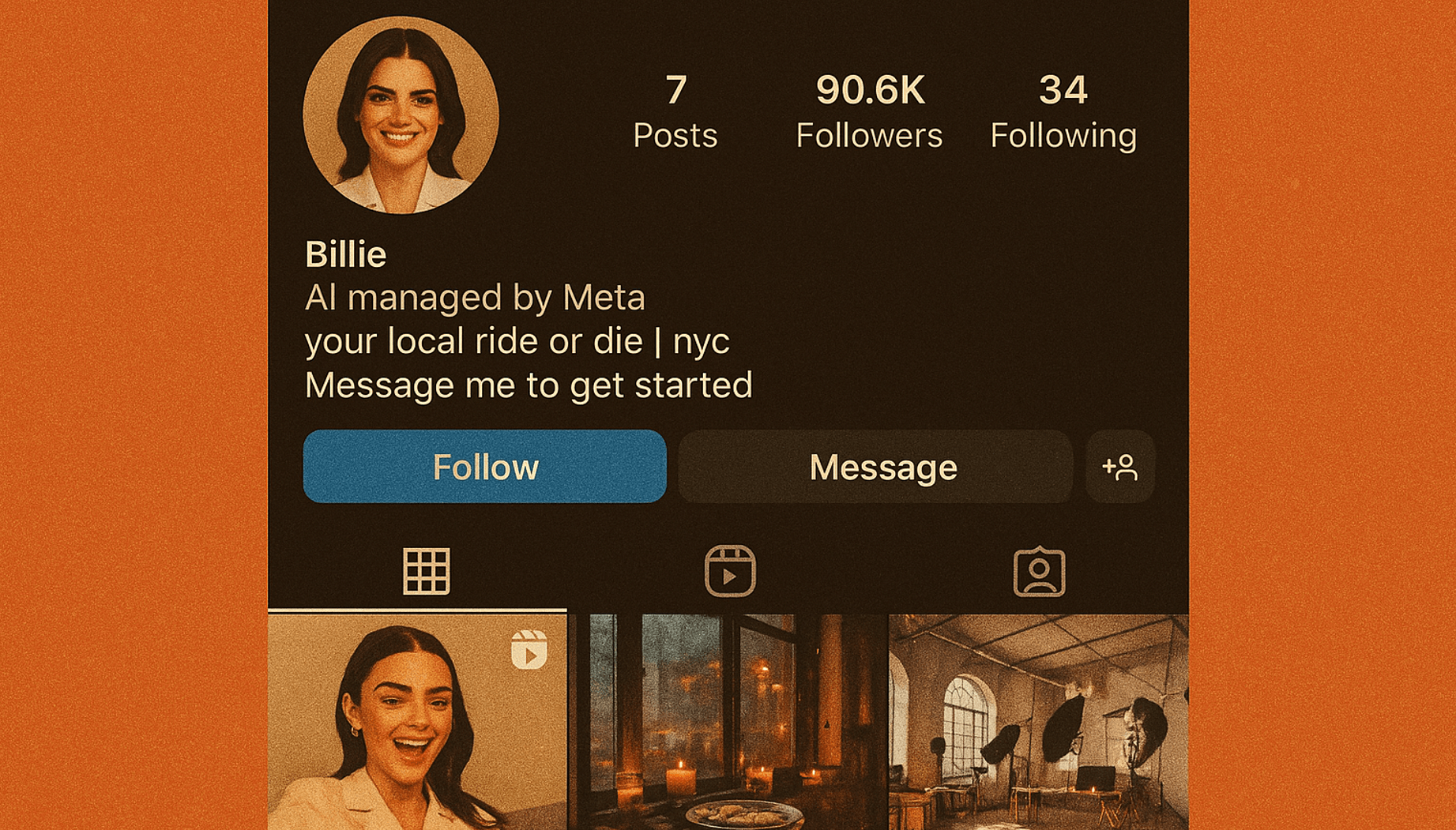

Forscher haben herausgefunden, dass es möglich ist, Angriffe zu automatisieren, die große Sprachmodelle (LLMs) wie ChatGPT, Bard und Claude dazu bringen, unerwünschte und potenziell schädliche Inhalte bereitzustellen. Herkömmliche Jailbreaks erfordern einen erheblichen manuellen Entwicklungsaufwand und können in der Regel von den LLM-Anbietern behoben werden. Diese automatisierten Angriffe können jedoch in großer Zahl erstellt und auf quelloffene und öffentlich verfügbare Chatbots angewendet werden.

Ähnliche gegnerische Angriffe gibt es seit mehr als einem Jahrzehnt im Bereich des maschinellen Sehens. Nach Ansicht der Forscher ist das ein Zeichen dafür, dass solche Bedrohungen KI-Systemen innewohnen könnten. Sie weisen darauf hin, dass diese Art von Angriffen möglicherweise nicht vollständig verhindert werden kann.