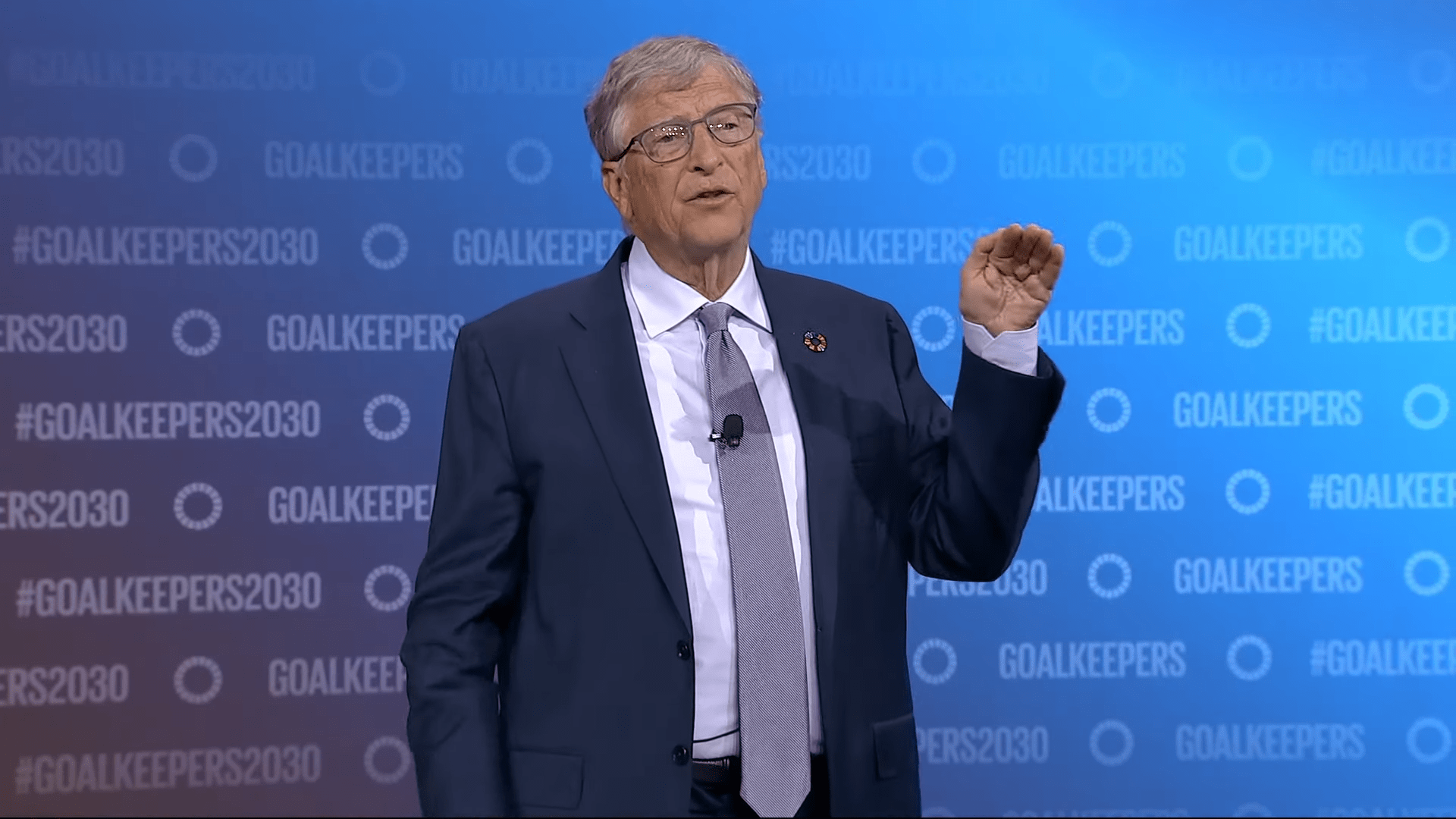

Bill Gates verharmlost das Desinformationspotential generativer KI

In einem Interview mit The Verge äußert sich Microsoft-Gründer Bill Gates zum Desinformationspotenzial von KI und relativiert es mit einem Argument, das am Kern des Problems vorbeigeht.

Gates sagt in dem Interview wörtlich: "Leute können Desinformationen in einen Textverarbeitungsprozessor eintippen. Sie benötigen keine KI, wissen Sie, um verrückte Dinge einzutippen. Ich bin mir also nicht sicher, ob KI, abgesehen von der Erstellung von Deepfakes, das Gleichgewicht in diesem Bereich wirklich verändert."

Gates’ Argument geht am eigentlichen Problem vorbei

Zwar ist die Beobachtung grundsätzlich korrekt, jedoch geht sie am eigentlichen Thema vorbei. Das Hauptrisiko generativer KI im Kontext von textueller Desinformation liegt nicht darin, dass die Desinformation prinzipiell generiert werden kann, so wie ein Text geschrieben werden kann. Die Gefahr ist die Skalierung von Desinformation auf einem perspektivisch hohen Niveau.

Zwei Studien zur Überzeugungskraft von KI zeigen bereits, dass KI-Modelle überzeugender sein können als Menschen. In einer Studie konnte GPT-4 mit Zugang zu persönlichen Informationen die Zustimmung zu gegnerischen Argumenten um 81,7 Prozent steigern, verglichen mit Debatten zwischen Menschen.

OpenAI-CEO Sam Altman warnte vor der "übermenschlichen Überzeugungskraft" von KI-Modellen und davor, dass "seltsame Dinge" passieren könnten, wenn diese erreicht sei. Security-Forscher befürchten beispielsweise viel überzeugendere Phishing-Mails.

KI macht Desinformation effektiver und skalierbarer

Wer andere Menschen täuschen will, kann das mit KI viel schneller, in viel größerem Umfang, auf hohem menschlichem Niveau und in Zukunft womöglich deutlich darüber hinaus tun. Es ist also mitnichten gleichzusetzen mit Menschen, die einfach "Desinformationen in einen Textverarbeitungsprozessor eintippen".

Gates’ Argument geht ebenso am Thema vorbei wie das von Deepfake-Risiko-Relativierern, die sagen, dass Bilder und Videos schon immer manipuliert werden konnten und Photoshop als Beispiel nennen.

Aber auch hier geht es nicht um die rein technische Möglichkeit, gefälschte Inhalte zu erstellen, sondern um die Einfachheit und Zugänglichkeit - die Skalierbarkeit. Es ist ein Unterschied, ob ich eine professionelle Software kaufen und lernen muss, um ein politisch motiviertes Fake-Bild zu erstellen, oder ob ich das mit einem Satz bei X tun kann.

Angesichts dessen, dass Akteure wie Donald Trump oder Elon Musk gerade die Deepfake-Dystopien, die Forschende teils schon vor Jahren prognostizierten, erfüllen, wäre es gut, wenn wichtige Akteure wie Gates sich differenzierter über die Gefahren von KI-Desinformation äußern würden.

Es mag Argumente dafür geben, dass das Desinformationspotenzial von KI überschätzt wird. Das von Gates vorgebrachte Argument ist jedoch keines. Es ist ein unzutreffender Vergleich, der vom eigentlichen Problem ablenkt und es verharmlost.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.