Die BBC ist eine von vielen Unternehmen und Organisationen, die Chatbots wie ChatGPT den Zugang zu ihren Inhalten verweigern.

Die britische Nachrichtenorganisation plant, mit Technologieunternehmen und Regulierungsbehörden zusammenzuarbeiten, um generative KI sicher zu entwickeln und gleichzeitig das Vertrauen in die Nachrichtenbranche aufrechtzuerhalten. Zu den drei Leitprinzipien der BBC gehört es, im öffentlichen Interesse zu handeln, Talent und Kreativität zu fördern und Transparenz bei KI-generierten Inhalten zu gewährleisten.

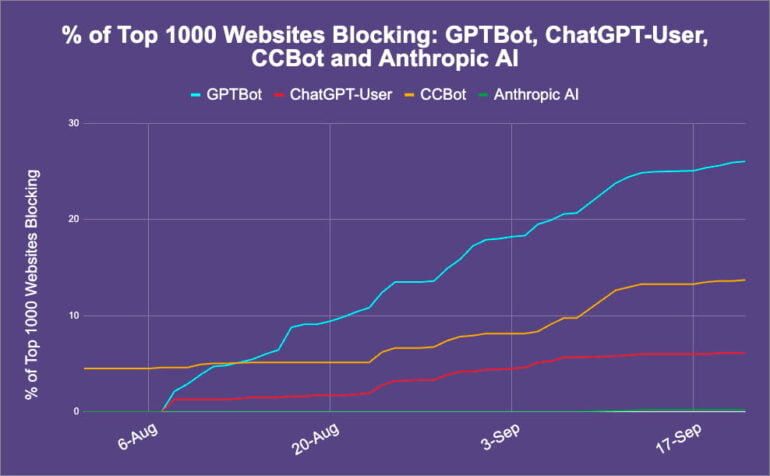

Die BBC blockiert jedoch den Webcrawlern von OpenAI und Common Crawl den Zugang zu ihren Websiten, um urheberrechtlich geschütztes Material zu schützen. Sie folgt damit anderen Nachrichtenorganisationen wie CNN und der New York Times.

ChatGPT kann fast die Hälfte der Top 100 Websites nicht erreichen

OpenAI hat ChatGPT Browsing mit Bing Ende September wieder eingeführt. Laut einer aktuellen Untersuchung von Originality.ai kann der Chatbot 47 Prozent der Top-100-Websites, darunter Facebook, Google und Amazon, nicht durchsuchen.

Die Untersuchung nennt drei Gründe dafür: Blockierung durch die Robots.txt der Website, interne Beschränkungen von OpenAI und technische Schwierigkeiten. In einem Fall respektierte ChatGPT die Robots.txt-Blockade einer Website nicht. Um ChatGPT Browse mit Bing zu aktivieren, müssen Benutzer Abonnenten von ChatGPT Plus sein.

Seit dem Relaunch liefert OpenAIs ChatGPT Browse-Funktion nur noch 100-Wort-Zusammenfassungen von Web-Inhalten, um Copyright-Probleme zu vermeiden. Diese Zusammenfassungen können unzuverlässig und ungenau sein.

Das KI-Tool verpasst manchmal das Wesentliche oder lässt wichtige Aspekte des Inhalts aus, sodass man die Quellen selbst überprüfen muss, um sicher zu sein, dass die KI-Interpretation korrekt ist. Dadurch ist ChatGPT Browsing weniger nützlich als herkömmliche Suchmaschinen, die relevante Auszüge direkt aus der Quelle liefern, ohne dass sich Fehler oder Ungenauigkeiten durch Umformulierungen einschleichen.

Chatbots als Suche-Ersatz scheint weniger wahrscheinlich als noch zu Jahresbeginn

Zwischen Urheberrechtsproblemen, Halluzinationen und Websites, die Chatbots blockieren, scheint ein nahes Zukunftsszenario, in dem Chatbots die traditionelle Suche ersetzen, viel weiter entfernt zu sein als noch zu Beginn des Jahres, als Microsoft-CEO Satya Nadella offen erklärte, er wolle mit dem Bing Chatbot einen größeren Anteil am Google-Suchmarkt erobern.

Vor kurzem räumte Nadella vor Gericht ein, dass er das Potenzial von Bing Chat, Google Marktanteile abzujagen, übertrieben dargestellt habe. Diese Aussage im Kartellverfahren gegen Google war strategisch, aber Microsoft ist es bisher tatsächlich nicht gelungen, Google Marktanteile abzunehmen, obwohl es GPT-4 kostenlos anbietet. OpenAIs stärkstes Sprachmodell kostet $20 pro Monat in ChatGPT.

Auch wenn Chatbots in Zukunft mit Suchmaschinen konkurrieren könnten, sind sie derzeit noch unzuverlässig und möglicherweise nicht urheberrechtskonform. Microsoft hetzte seinen Bing-Chatbot auf den Markt, obwohl dieser wegen der möglichen Verbreitung von Falschinformationen in der Kritik stand, was sich nun am Beispiel von Wahlen bestätigt. Microsoft scheint bei seinen KI-Suchprodukten auf Schnelligkeit statt auf Sicherheit zu setzen.

Googles generative KI-Suche könnte jedoch das Beste aus beiden Welten vereinen, indem es sorgfältig Anwendungsfälle für generative KI auswählt, diese in die herkömmliche Suche integriert und so langsam eine Entwicklung hin zu einer geschlossenen Content-Plattform einleitet, die die Nutzer in einer Chatbot-Schleife hält. Wenn Google damit Erfolg hat, könnte dies das Gesicht des heutigen Internet-Ökosystems verändern.