Eine neue Studie des Bundeswirtschaftsministeriums gibt einen Einblick in den aktuellen Stand erklärbarer KI und KI-Entwicklern einen Überblick über potenzielle Erklärungsstrategien.

Dienstleistungen und Produkte, die auf Künstliche Intelligenz setzen, sollen laut einer eco-Studie in Deutschland im Jahr 2025 Umsätze in Höhe von 488 Milliarden Euro generieren. Das entspräche 13 Prozent des Bruttoinlandsprodukts der Bundesrepublik.

Eine neue Studie im Auftrag des Bundeswirtschaftsministeriums kommt jetzt zu dem Schluss: Dieses Ziel wird nur zu erreichen sein, wenn die Entscheidungen von KI-Systemen in wichtigen Anwendungsfeldern für Endnutzer nachvollziehbar sind.

Erklärbare KI gehöre im europäischen Kontext zu den wichtigsten Faktoren für einen Erfolg am Markt, so die Autoren. Dennoch stünde die Forschung in diesem Bereich erst am Anfang.

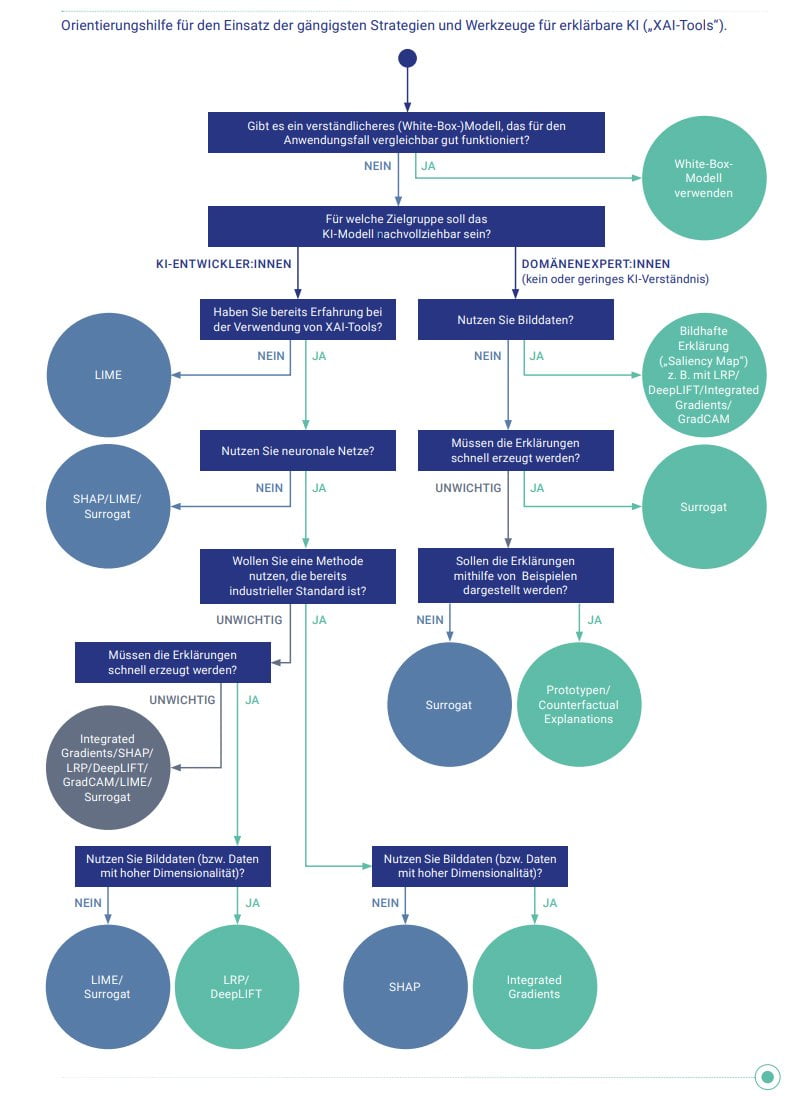

Für KI-Entwickler gebe es bereits etablierte Erklärwerkzeuge wie LIME, SHAP, LRP oder GradCAM, so die Autoren der Studie. Doch solche Werkzeuge setzten Expertenwissen voraus. Für Endnutzer hingegen existierten bisher nur wenige Werkzeuge, die bei KI-Systemen "intuitiv verständliche Entscheidungserklärungen" liefern.

KI-Erklärungsbedarf im Gesundheitsbereich am größten

In der Zukunft würden neuronale Netze (Erklärung) in allen Bereichen der Gesellschaft eingesetzt. Die Bedeutung von Erklärbarkeit maschineller Entscheidungen sei jedoch je nach Branche sehr unterschiedlich. Als besonders wichtig gelten der Gesundheitsbereich, gefolgt von der Finanzwirtschaft, dem Produktionssektor, der Bauwirtschaft und der Prozessindustrie.

Verschiedene Branchen und Anwendungsfälle benötigen dabei unterschiedliche Erklärungstypen. In einem Experten-Update zur Veröffentlichung der Studie macht KI-Professorin Dr. Ute Schmid am Beispiel Krebserkennung deutlich, dass der Anspruch an Erklärungen im Gesundheitsbereich besonders hoch ist.

Hier genüge es nicht, wenn nach der Identifikation von verdächtigem Gewebe und der Zuordnung zu bestimmten Tumorvarianten durch ein KI-Modell die entsprechenden Stellen visuell markiert werden. Eine echte Erklärung müsse auch Informationen liefern, warum das KI-Modell genau diese Tumorvariante vermute.

Orientierungsbaum und Herausforderungen

Für Entwickler liefern die Autoren als Orientierung einen Entscheidungsbaum, der helfen soll, je nach Einsatzgebiet, Modell und Zielgruppe die besten Erklärungswerkzeuge zu finden.

Die Autoren identifizieren außerdem zahlreiche technische und regulatorische Herausforderungen erklärbarer KI. So fehlten empfohlene Vorgehensweisen in Bezug auf die jeweiligen Anwendungen, Erklärungen müssten sich kontinuierlich lernenden Systemen und Nutzern anpassen, und für die praktische Anwendung müssten Erklärwerkzeuge auch verhaltenswissenschaftliche Aspekte berücksichtigen, etwa die Messbarkeit der Erklärungsgüte aus Sicht der Nutzer sicherstellen.

Zu den identifizierten regulatorischen Herausforderungen zählen die Festlegung einheitlicher Anforderungen und Testverfahren für erklärbare KI, die Schaffung von Zulassungs- und Zertifizierungsrahmen und die Aus- und Weiterbildung von Prüfern.

Die Ergebnisse der Studie basieren auf einer Umfrage unter 209 KI-Experten aus Wirtschaft und Wissenschaft sowie weiterführenden Interviews und Use Cases. Die komplette Studie ist auf der Webseite des Bundeswirtschaftsministeriums verfügbar.

Via: Eco, Digitale Technologien