Google zeigt eine Methode, mit der große Sprachmodelle Texte deutlich schneller generieren. In Tests konnte das Unternehmen knapp 50 Prozent Rechenzeit einsparen.

Große Sprachmodelle kommen in verschiedenen Aufgaben der Verarbeitung natürlicher Sprache zum Einsatz, etwa der Übersetzung oder der Text-Generation. Modelle wie GPT-3, PaLM oder LaMDA erzielen beeindruckende Ergebnisse und zeigen, dass die Leistung der Sprachmodelle mit ihrer Größe zunimmt.

Solche riesigen Modelle sind jedoch im Vergleich zu kleineren Varianten langsam und benötigen viel Rechenleistung. Da sie zudem ein Wort nach dem anderen vorhersagen und die Vorhersage eines Wortes abgeschlossen sein muss, bevor das Modell das nächste vorhersagen kann, lässt sich die Generation von Text nicht parallelisieren.

Googles CALM greift Vorhersagen aus früheren Schichten ab

Google zeigt nun Confident Adaptive Language Modeling (CALM), eine Methode für die Beschleunigung der Text-Generierung großer Sprachmodelle. Hinter der Methode steht die Intuition, dass die Vorhersage einiger Wörter leicht ist, während andere schwer vorherzusagen sind. Aktuelle Sprachmodelle verwenden jedoch für jedes Wort in einem Satz die gleichen Ressourcen. CALM verteilt dagegen die verwendeten Rechenressourcen dynamisch während der Text-Generation.

Video: Google

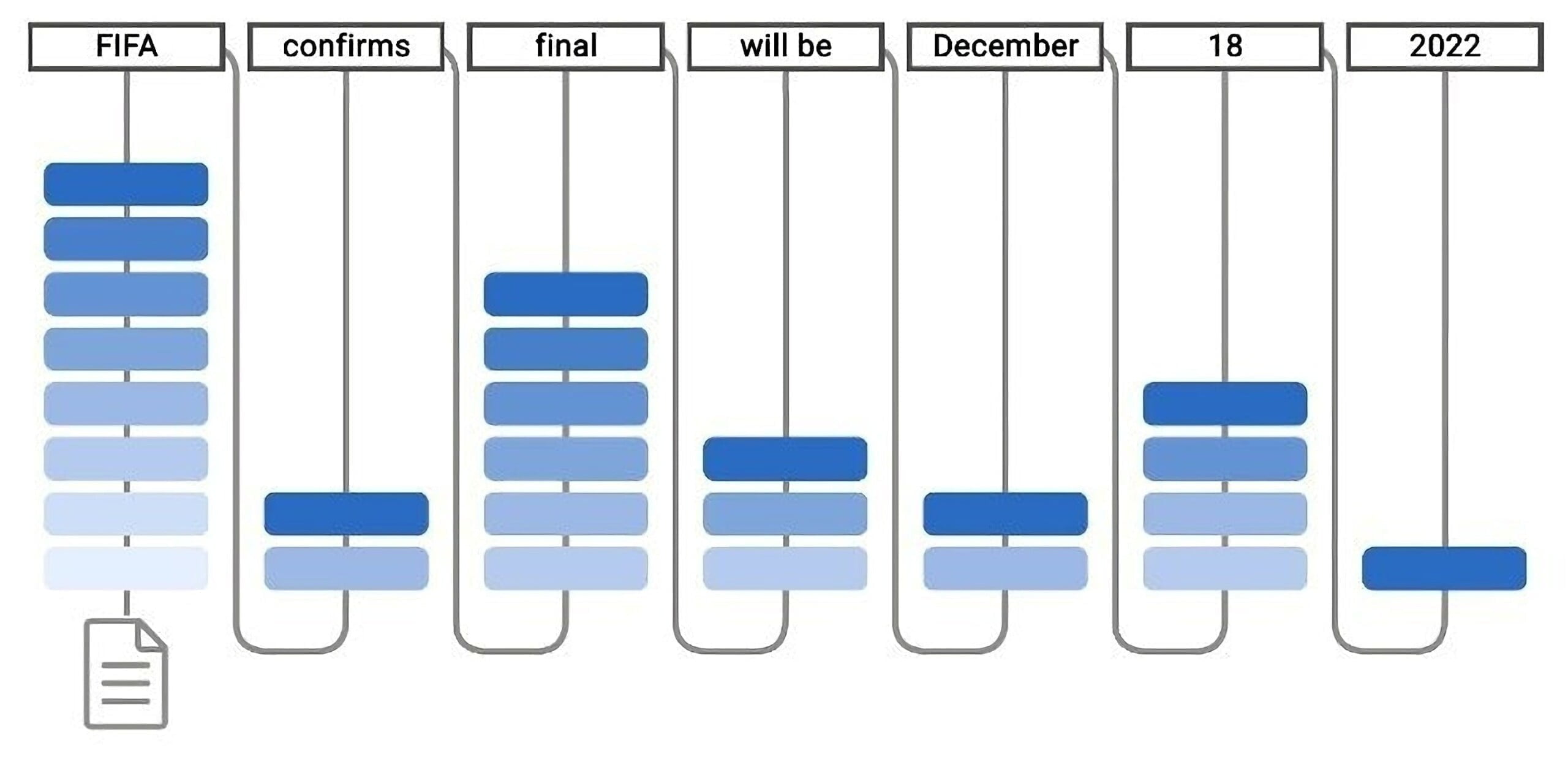

Sprachmodelle setzen auf mehrere Transformer-Schichten, in der Attention- und Feedforward-Module interne Repräsentationen von Text modifizieren. Im Decoder entsteht durch diesen Prozess so am Ende die Vorhersage des nächsten Wortes.

Statt diesen Prozess durch alle Schichten laufen zu lassen, misst CALM das Vertrauen des Modells in seine Vorhersage schon in frühen Schichten und spielt diese direkt aus, wenn der Wert hoch genug ist. Ist der Wert niedrig, wird die Vorhersage wie gewohnt in die späteren Schichten verlagert.

CALM reduziert in Tests die Rechenzeit um knapp 50 Prozent

Um CALM zu testen, trainiert Google ein T5-Modell und vergleicht die Leistung von CALM mit einem Standardmodell. Dabei zeigt das Team, dass die Methode in verschiedenen Benchmarks für Übersetzung, Zusammenfassung und Antworten hohe Werte erreicht und im Schnitt deutlich weniger Schichten pro Wort verwendet. In der Praxis spare CALM auf TPUs bis zu 50 Prozent der Rechenzeit bei gleichbleibender Qualität.

CALM ermöglicht eine schnellere Texterzeugung mit Sprachmodellen, ohne die Qualität des ausgegebenen Textes zu beeinträchtigen. Erreicht wird dies durch die dynamische Anpassung des Rechenaufwands pro Generierungszeitschritt, sodass das Modell die Berechnungssequenz frühzeitig beenden kann, wenn es sich sicher genug fühlt.

Mit immer größer werdenden Modellen sei die effiziente Nutzung dieser zentral, so Google. CALM ist ein wichtiger Beitrag zu diesem Ziel und kann laut Google mit bekannten anderen Effizienz-Ansätzen wie Destillation oder Sparsity kombiniert werden.