Google-Forscher zeigen, wie sie neue Algorithmen des bestärkenden Lernens evolutionär entdecken. Das könnte Felder wie die Robotik beschleunigen.

Googles automatisches maschinelles Lernen (AutoML) ermöglicht die Entwicklung spezialisierter KI-Systeme ohne Programmierkenntnisse: Daten sortieren, KI-Modell auswählen und konfigurieren, Training – alles läuft automatisiert ab.

Doch hinter AutoML steht mehr als die Idee, KI-Training einfacher zu machen: AutoML soll zukünftig selbstständig völlig neue KI-Systeme entwickeln und dabei unbekannte Architekturen entdecken. Die Suche nach neuen KI-Architekturen wird „Neural Architecture Search“ (NAS) genannt und brachte 2019 erste Ergebnisse, etwa in Form von besseren Bildanalyse-KIs.

2020 ging Google mit AutoML-Zero einen Schritt weiter: Das System nutzt eingeschränkte Abitur-Mathekenntnisse, um neue, vollwertige KI-Algorithmen zu erfinden. Während des evolutionären Entdeckungsprozesses fand AutoML-Zero zahlreiche Algorithmen und entdeckte auch bereits bekannte KI-Techniken wie künstliche neuronale Netze (Erklärung) samt Optimierungstechniken. Das zeigt, dass das System funktioniert.

Doch all diese Erfolge haben eines gemeinsam: Sie setzen auf das überwachte Lernen (Erklärung), denn die weit verbreitete Lernmethode ist mit vergleichsweise simplen Algorithmen möglich. Das bestärkende Lernen (Erklärung) hingegen hat noch zu viele Stellschrauben für die automatische Algorithmussuche.

Mit dem bestärkendem Lernen können KI-Agenten intelligentes Verhalten wie Schachspielen, Atari-Games spielen oder die fehlerfreie Navigation durch eine Umgebung erlernen. Die Lernmethode gilt daher als zentrale Zukunftstechnologie unter anderem in der Robotik.

Googles Evolutionsmaschine bringt bessere Algorithmen und reduziert den Black-Box-Faktor

Google-Forscher haben nun eine Arbeit veröffentlicht, in der sie Algorithmen des bestärkenden Lernens evolutionär entwickeln. Es ist nicht der erste Versuch, doch laut der Forscher unterscheidet sich ihr Ansatz von bisherigen in zwei Punkten: Die gefundenen Algorithmen sind von Menschen interpretierbar und generalisieren auf neue Umgebungen. Google zeigt das am Beispiel von Computerspielen.

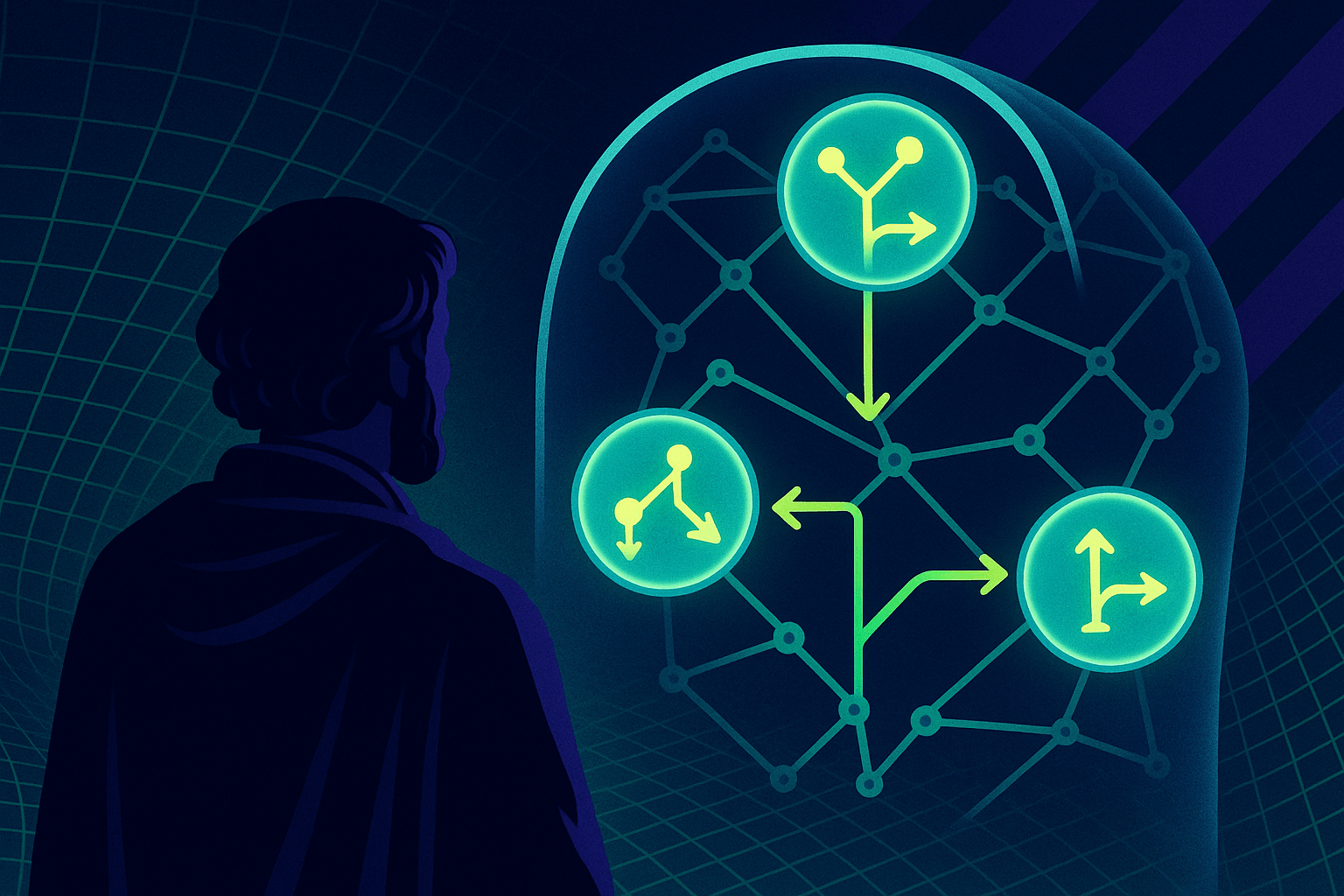

Die Forscher repräsentieren dafür die Kostenfunktionen der Lern-Algorithmen, die zur Optimierung des KI-Agenten anhand seiner Erfahrung genutzt wird, als gerichteten Graph ohne Zyklus. Die einzelnen Knotenpunkte repräsentieren dabei Inputs, Operatoren, Parameter und Outputs der Kostenfunktion (Erklärung).

Diese Repräsentation hat laut Google zwei wesentliche Vorteile: Die Graphen sind ausdrucksstark genug, um bestehende und bisher nicht bekannte Algorithmen zu definieren. Sie sind außerdem von Menschen interpretierbar – das erlaubt den Forschern, zu verstehen, warum ein bestimmter Algorithmus besser abschneidet oder sie können ausgewählte interne Komponenten direkt ändern.

Google nutzt einen evolutionären Algorithmus, um eine Population solcher Graphen in verschiedenen simplen Trainingsumgebungen zu evaluieren und zu verbessern. Dafür wird eine Gruppe Agenten parallel in diesen Umgebungen trainiert, zuerst in simpleren und dann in komplexeren. Erfolgreiche Algorithmen werden mutiert, die Verlierer gelöscht.

Hürdenlauf zum Mond

Für ihren Test konzentrieren sich die Forscher auf simple Fortbewegung in einem 2D-Raum. In CartPole lernen die Algorithmen, über eine Hürde zu hüpfen. Später müssen sie etwa in LunarLander ein Raumschiff auf dem Mond landen. Während der Evolution überprüft eine Funktion, ob unter den Mutationen Varianten dabei sind, die bereits vorher versagt haben und löscht sie.

Insgesamt startete Google mit 300 Agenten, deren Kostenfunktionen generiert wurden oder von etablierten Algorithmen stammten. Taugliche Agenten entstanden üblicherweise nach 20.000 bis 50.000 Mutationen in drei Tagen ohne besonders hohen Trainingsaufwand. Die so entstandenen Algorithmen werden anschließend in Umgebungen getestet, die nicht in den Trainingsszenarien enthalten sind.

Mutationen bringen besser generalisierende Algorithmen hervor

Eine der zu Beginn des Trainings integrierte Kostenfunktion war die des von Menschen entwickelten DQN-Algorithmus. Deep Q-network ist die erste Lernmethode des tiefen bestärkenden Lernens, die Deepmind 2015 vorstellte. DQN konnte Atari-Titel spielen und zeigte das Potenzial der Kombination aus tiefen neuronalen Netzen und bestärkendem Lernen.

Googles Evolutionsexperiment brachte zwei neue Varianten von DQN hervor: DQNReg und DQNClipped. In Tests konnten die Forscher zeigen, dass beide Algorithmen gut mit bisher unbekannten Umgebungen klarkommen.

In der MiniGrid-Umgebung, in der Algorithmen in sich ständig ändernden simplen Umgebungen zu einem Ziel finden müssen, schnitt etwa DQNReg deutlich besser als DQN und die von Menschen verbesserte DQN-Variante DDQN ab.

Google testete die Algorithmen außerdem in Atari-Umgebungen. Auch hier zeigten die neuen KI-Beweger verbesserte Leistung. Laut den Forschern deutet dieses Ergebnis darauf hin, dass Training mit einer Reihe von simplen, aber vielfältigen Trainingsumgebungen mit ihrer Methode „eine radikale algorithmische Generalisierung“ ermöglichen könnte.

In Zukunft will Google die evolutionäre Suche nach besseren Algorithmen des bestärkenden Lernens auf weitere Lernszenarien wie komplexere Umgebungen und weitere Kostenfunktionen anwenden. Google hat außerdem einen Datensatz mit den 1000 besten neu entdeckten Algorithmen veröffentlicht.

Googles Forschungsarbeit zeigt, dass die evolutionäre Suche nach besseren KI-Modellen auch für das bestärkende Lernen funktioniert. Sie könnte langfristig deutlich bessere Algorithmen hervorbringen. Solche generalisierenden Algorithmen könnten zahlreiche Probleme selbstständig lösen lernen und die Lernmethode bestärkendes Lernen etwa vom LunarLanding-Computerspiel zur echten, selbstständigen Mondlandung transferieren.